多源数据融合的场景空间模型自适应建模方法与流程

本技术涉及数据处理领域,具体涉及一种多源数据融合的场景空间模型自适应建模方法。

背景技术:

1、随着三维重建技术的发展,场景空间建模在智慧城市、室内导航等领域的应用日益广泛。传统的场景建模方法往往依赖单一数据源,如仅使用视觉图像或激光点云数据,这使得建模过程容易受到遮挡、光照变化等因素的影响,难以保证模型的完整性和准确性。虽然目前已有一些多源数据融合的建模方案,但这些方案通常采用固定的建模策略,无法根据场景特点自适应调整建模方法。

2、在处理复杂动态场景时,现有系统普遍存在建模效率低、精度不稳定等问题。特别是在室内外复杂环境下,场景中的动态目标、光照变化和几何遮挡等因素会严重影响建模质量。同时,现有方法缺乏对场景复杂度的有效评估机制,无法根据场景特征智能选择最优的建模策略,这导致建模效果与实际应用需求存在较大差距。此外,系统对动态场景变化的适应能力不足,难以及时调整建模参数以响应场景变化。

3、因此,如何实现多源数据的有效融合、建立场景复杂度评估机制,以及提高系统对动态场景的适应能力,是当前亟需解决的关键技术问题。这不仅关系到三维重建的质量和效率,也是推动空间信息技术发展的重要方向。

技术实现思路

1、针对现有技术中的问题,本技术提供一种多源数据融合的场景空间模型自适应建模方法,能够有效解决传统建模方案在复杂动态场景下精度不稳定、适应性差的问题,提升三维场景重建的质量和效率。

2、为了解决上述问题中的至少一个,本技术提供以下技术方案:

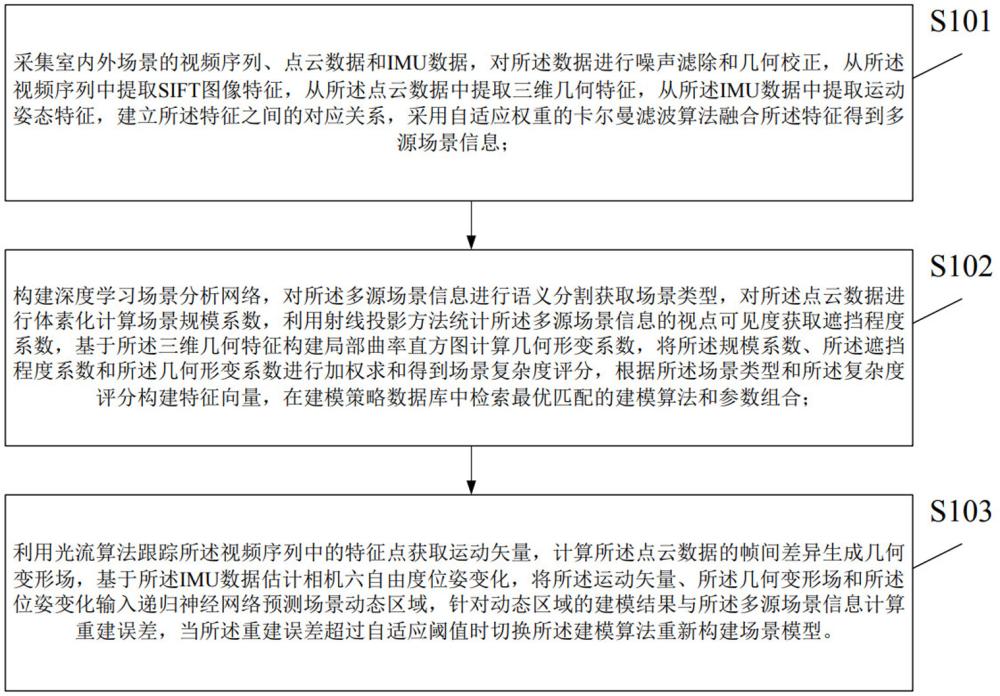

3、第一方面,本技术提供一种多源数据融合的场景空间模型自适应建模方法,包括:

4、采集室内外场景的视频序列、点云数据和imu数据,对所述数据进行噪声滤除和几何校正,从所述视频序列中提取sift图像特征,从所述点云数据中提取三维几何特征,从所述imu数据中提取运动姿态特征,建立所述特征之间的对应关系,采用自适应权重的卡尔曼滤波算法融合所述特征得到多源场景信息;

5、构建深度学习场景分析网络,对所述多源场景信息进行语义分割获取场景类型,对所述点云数据进行体素化计算场景规模系数,利用射线投影方法统计所述多源场景信息的视点可见度获取遮挡程度系数,基于所述三维几何特征构建局部曲率直方图计算几何形变系数,将所述规模系数、所述遮挡程度系数和所述几何形变系数进行加权求和得到场景复杂度评分,根据所述场景类型和所述复杂度评分构建特征向量,在建模策略数据库中检索最优匹配的建模算法和参数组合;

6、利用光流算法跟踪所述视频序列中的特征点获取运动矢量,计算所述点云数据的帧间差异生成几何变形场,基于所述imu数据估计相机六自由度位姿变化,将所述运动矢量、所述几何变形场和所述位姿变化输入递归神经网络预测场景动态区域,针对动态区域的建模结果与所述多源场景信息计算重建误差,当所述重建误差超过自适应阈值时切换所述建模算法重新构建场景模型。

7、进一步地,所述采集室内外场景的视频序列、点云数据和imu数据,对所述数据进行噪声滤除和几何校正,从所述视频序列中提取sift图像特征,从所述点云数据中提取三维几何特征,从所述imu数据中提取运动姿态特征,包括:

8、对所述采集的视频序列利用高斯滤波进行图像降噪,采用双边滤波对所述点云数据进行噪点过滤,利用小波变换对所述imu数据进行信号平滑,对所述数据建立统一的时序索引,将所述视频序列、所述点云数据和所述imu数据进行时间戳对齐和几何校正;

9、利用尺度不变特征变换算法对所述视频序列提取sift特征点和特征描述子,对所述点云数据计算法向量和局部曲率特征得到三维几何特征,将所述imu数据通过姿态解算获取加速度和角速度,采用卡尔曼滤波估计运动姿态特征。

10、进一步地,所述建立所述特征之间的对应关系,采用自适应权重的卡尔曼滤波算法融合所述特征得到多源场景信息,包括:

11、基于所述sift特征描述子计算特征点匹配度,利用ransac算法剔除错误匹配点,将所述三维几何特征投影到图像平面建立与所述sift特征点的空间对应关系,将所述运动姿态特征与所述sift特征点和所述三维几何特征进行时空配准;

12、根据所述特征点匹配度计算所述sift特征的权重系数,基于所述三维几何特征的局部曲率值确定权重系数,利用所述运动姿态特征的估计误差设定权重系数,将所述权重系数输入卡尔曼滤波器构建状态估计方程,对所述特征进行加权融合得到多源场景信息。

13、进一步地, 所述构建深度学习场景分析网络,对所述多源场景信息进行语义分割获取场景类型,对所述点云数据进行体素化计算场景规模系数,利用射线投影方法统计所述多源场景信息的视点可见度获取遮挡程度系数,基于所述三维几何特征构建局部曲率直方图计算几何形变系数,包括:

14、构建包含编码器和解码器的u-net卷积神经网络,所述编码器采用残差结构提取所述多源场景信息的多尺度特征,所述解码器通过上采样和跳跃连接恢复特征分辨率,对所述多源场景信息进行像素级语义分割,采用全连接层将分割结果映射为场景类型标签;

15、对所述点云数据建立三维网格划分体素,统计每个体素内点的数量计算空间占用率得到场景规模系数,从不同视点位置向场景投射采样射线,计算射线与所述多源场景信息的交点数量获取遮挡程度系数,对所述三维几何特征中的法向量和主曲率值构建局部曲率直方图,通过直方图峰值分布计算几何形变系数。

16、进一步地,所述将所述规模系数、所述遮挡程度系数和所述几何形变系数进行加权求和得到场景复杂度评分,根据所述场景类型和所述复杂度评分构建特征向量,在建模策略数据库中检索最优匹配的建模算法和参数组合,包括:

17、根据所述规模系数的数值范围设定归一化权重系数w1,基于所述遮挡程度系数的分布特性确定归一化权重系数w2,依据所述几何形变系数的统计特征确定归一化权重系数w3,对所述系数进行加权求和运算得到0到1之间的场景复杂度评分值;

18、将所述场景类型进行独热编码转换为类型特征,将所述场景复杂度评分转换为数值特征,连接所述类型特征和所述数值特征构建高维特征向量,采用k近邻算法在预先构建的建模策略数据库中检索与所述特征向量最相似的策略模板,提取对应的建模算法和参数组合。

19、进一步地,所述利用光流算法跟踪所述视频序列中的特征点获取运动矢量,计算所述点云数据的帧间差异生成几何变形场,基于所述imu数据估计相机六自由度位姿变化,将所述运动矢量、所述几何变形场和所述位姿变化输入递归神经网络预测场景动态区域,包括:

20、采用lucas-kanade光流算法对所述视频序列的相邻帧计算像素位移场,利用角点检测筛选稳定特征点,计算所述特征点的运动矢量,对所述点云数据计算相邻帧点集的欧氏距离获取位移向量场,采用最近邻搜索建立点对应关系生成几何变形场,通过扩展卡尔曼滤波器对所述imu数据进行姿态解算得到相机的平移向量和旋转四元数;

21、构建长短期记忆网络lstm对时序特征进行建模,将所述运动矢量组成特征序列输入第一个lstm单元,将所述几何变形场组成特征序列输入第二个lstm单元,将所述平移向量和旋转四元数组成特征序列输入第三个lstm单元,融合三个lstm单元的输出特征通过全连接层生成场景动态区域的概率图。

22、进一步地,所述针对动态区域的建模结果与所述多源场景信息计算重建误差,当所述重建误差超过自适应阈值时切换所述建模算法重新构建场景模型,包括:

23、对所述场景动态区域的概率图进行二值化分割得到动态区域掩膜,将所述建模结果投影到图像平面获取深度图,计算所述深度图与所述多源场景信息在动态区域内的均方根误差和点云配准误差,采用指数加权平均方法对所述误差进行滑动统计得到重建误差

24、基于所述重建误差的历史数据计算自适应阈值,采用双阈值机制进行误差判断,当所述重建误差大于高阈值或连续多帧大于低阈值时,在所述建模策略数据库中重新检索建模算法,将检索得到的新建模算法应用于动态区域的场景重建。

25、第二方面,本技术提供一种多源数据融合的场景空间模型自适应建模装置,包括:

26、多源场景确定模块,用于采集室内外场景的视频序列、点云数据和imu数据,对所述数据进行噪声滤除和几何校正,从所述视频序列中提取sift图像特征,从所述点云数据中提取三维几何特征,从所述imu数据中提取运动姿态特征,建立所述特征之间的对应关系,采用自适应权重的卡尔曼滤波算法融合所述特征得到多源场景信息;

27、场景分析模块,用于构建深度学习场景分析网络,对所述多源场景信息进行语义分割获取场景类型,对所述点云数据进行体素化计算场景规模系数,利用射线投影方法统计所述多源场景信息的视点可见度获取遮挡程度系数,基于所述三维几何特征构建局部曲率直方图计算几何形变系数,将所述规模系数、所述遮挡程度系数和所述几何形变系数进行加权求和得到场景复杂度评分,根据所述场景类型和所述复杂度评分构建特征向量,在建模策略数据库中检索最优匹配的建模算法和参数组合;

28、自适应建模模块,用于利用光流算法跟踪所述视频序列中的特征点获取运动矢量,计算所述点云数据的帧间差异生成几何变形场,基于所述imu数据估计相机六自由度位姿变化,将所述运动矢量、所述几何变形场和所述位姿变化输入递归神经网络预测场景动态区域,针对动态区域的建模结果与所述多源场景信息计算重建误差,当所述重建误差超过自适应阈值时切换所述建模算法重新构建场景模型。

29、第三方面,本技术提供一种电子设备,包括存储器、处理器及存储在存储器上并可在处理器上运行的计算机程序,所述处理器执行所述程序时实现所述的多源数据融合的场景空间模型自适应建模方法的步骤。

30、第四方面,本技术提供一种计算机可读存储介质,其上存储有计算机程序,该计算机程序被处理器执行时实现所述的多源数据融合的场景空间模型自适应建模方法的步骤。

31、第五方面,本技术提供一种计算机程序产品,包括计算机程序/指令,该计算机程序/指令被处理器执行时实现所述的多源数据融合的场景空间模型自适应建模方法的步骤。

32、由上述技术方案可知,本技术提供一种多源数据融合的场景空间模型自适应建模方法,通过融合视频序列、点云数据和imu数据构建完整的场景信息。采用深度学习网络进行场景分析,基于规模系数、遮挡程度和几何形变系数计算场景复杂度评分,实现建模策略的智能匹配。同时,利用光流算法、几何变形场和相机位姿变化预测场景动态区域,通过重建误差监控建模质量,实现建模算法的自适应切换。该方法有效解决了传统建模方案在复杂动态场景下精度不稳定、适应性差的问题,提升了三维场景重建的质量和效率。

- 还没有人留言评论。精彩留言会获得点赞!