一种基于强化学习的动态最大压交通信号控制方法

本发明涉及一种基于强化学习的动态最大压交通信号控制方法,属于交通。

背景技术:

1、随着机动车与非机动车保有量的持续增加,道路拥堵的交通状态已逐渐呈现常态化。采用先进的交通信号控制手段调节交通流运行的管控技术是缓解交通拥堵、提高出行效率、助力碳达峰与碳中和的重要途径。最大压交通信号控制是一种先进的分布式信号控制方法,它能够有效防止排队溢出,确保车辆能够有效且流畅地在网络中通行,同时最大化路网吞吐量。然而,现有的最大压交通信号控制大多只考虑了单一交通压力参数作为最大压控制器的输入,且对相邻路口压力关联的考虑不足,使得最大压信号控制难以适应复杂多变的交通状况。

2、目前人工智能算法如强化学习是解决复杂城市交通网络交通信号灯控制的一种很有前途的数据驱动方法。因此,为了解决最大压现有的局限性问题,本发明结合数据驱动的方法和理论控制模型的优势,建立动态交通压力参数和上下游压力动态关联的动态最大压交通信号控制模型,利用具有高度自适应特性的深度强化学习技术来优化模型。现有基于强化学习的交通信号控制方法得到的控制策略通常用神经网络来表示,由于神经网络泛化能力的问题,如训练得到的模型不进行额外的调整,直接将在模拟环境中离线学习的强化学习策略应用到现实世界中是不可取的,本发明结合理论控制模型的优势,使用强化学习去优化最大压控制模型,最终的控制策略由优化后的最大压控制模型得到。

技术实现思路

1、本发明要解决的技术问题是提供一种基于强化学习的动态最大压交通信号控制方法,用于进一步优化最大压交通信号控制方法,制定能够灵活适应复杂多变的交通状况的信号控制方案,研究基于高度自适应的强化学习方法,克服最大压信号控制模型以单一交通压力参数作为压力权重和对相邻路口压力关联的考虑不足的局限性。

2、为了实现上述目的,本发明采用了如下技术方案:

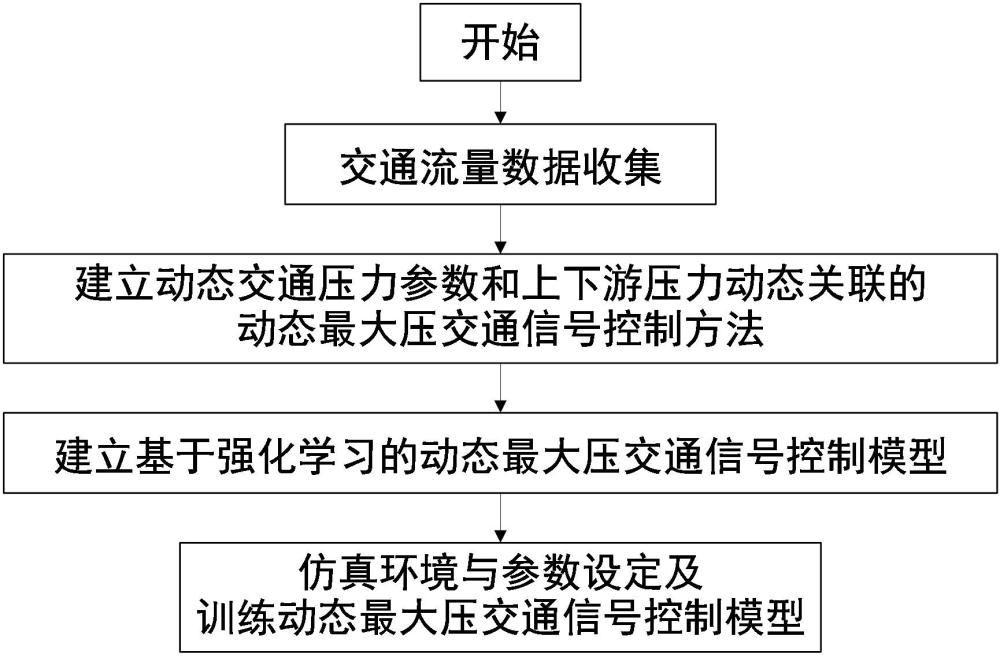

3、本发明提供一种基于强化学习的动态最大压交通信号控制方法,包括以下步骤:

4、步骤1:收集交通流量数据;

5、步骤2:建立动态交通压力参数和上下游压力动态关联的动态最大压交通信号控制方法;

6、步骤3:建立基于强化学习的动态最大压交通信号控制模型;

7、步骤4:设定仿真环境与参数,完成基于强化学习的动态最大压交通信号控制模型训练。

8、进一步地,所述交通流量数据用于模型训练;

9、进一步地,所述步骤2包括:

10、步骤2.1:基于可变元胞传输模型,根据自由流密度、拥塞流密度和路段长度,划分出四类动态交通压力参数,表示为:

11、

12、

13、

14、

15、其中,为拥塞流密度的压力;为拥塞流密度与自由流密度组合的压力;为结合路段长度下的拥塞流密度的压力;为结合路段长度下的拥塞流密度与自由流密度组合的压力;为拥塞流密度压力;为自由流密度压力;,,表示压力种类;为路段长度;为时间;,为路段编号;

16、步骤2.2:根据上下游相邻交叉口压力动态关联,用上下游关联参数来表征相邻交叉口是否关联,的取值为0和1,其中,0表示不关联,1表示关联;

17、步骤2.3:采用固定相位相序,建立动态交通压力参数和上下游压力动态关联的动态最大压交通信号控制方法,在每个信号周期结束时,根据每个相位的压力占比计算各相位绿灯时间。

18、进一步地,所述步骤2.3,具体描述如下:

19、首先计算压力权重,在每个时间时,控制器根据所选交通压力参数及上下游关联参数来计算压力权重:

20、

21、其中,和为交通压力参数;为压力种类;,,为路段编号;为从路段到路段的车流比例,为起始路段为的所有下游路段的集合;

22、计算车流压力,以最大压压力权重与饱和流率的乘积来表示车流压力,即:

23、

24、计算相位压力,为相位编号,每个相位包含若干个车流,因此相位压力等于相位内所包含的所有车流压力之和:

25、

26、其中,表示相位内从到转向车流;

27、根据每个相位的压力占比计算各相位绿灯时间为:

28、

29、其中,,分别为相位和相位内所包含的所有车流压力之和;为节点编号;,为相位编号;为信号周期;为相位集合;

30、为保证行人过街,设置最小绿灯时间为,同时设置最大绿灯时间为,则相位绿灯时间最终表示为:

31、。

32、进一步地,所述步骤3包括:

33、步骤3.1:强化学习智能体,包括状态、动作和奖励的设计;

34、步骤3.2:建立基于强化学习的动态最大压交通信号控制模型,包括时空特征提取模块、深度q网络(dqn)动作决策模块和值分解混合网络模块。

35、进一步地,所述步骤3.1包括:

36、所述动作的设计具体为将划分出的四类动态交通压力参数和上下游关联参数的离散组合作为强化学习动作,通过dqn动作决策出交通压力参数和关联参数之后,将输入到所述动态交通压力参数和上下游压力动态关联的动态最大压交通信号控制方法中,输出各相位绿灯时间;

37、所述状态的设计具体为所述状态包括当前交叉口每个进口道排队车辆数,进口道车辆密度,当前交叉口出口道车辆密度,上一动作和交叉口编号,状态表示为一个状态向量state={,,,,};

38、所述奖励的设计具体为所述奖励为相邻时间步的交叉口排队车辆数与交叉口吞吐量的组合:

39、

40、其中,为在时刻状态下交叉口执行动作后获得的奖励,为时刻下一周期的持续时间,为交叉口进口道总排队车辆数,为交叉口车辆吞吐量,为权重系数。

41、进一步地,所述步骤3.2包括:

42、所述时空特征提取模块,由图注意力网络gat和门控循环单元gru组成串联而成,将各交叉口的状态特征输入到所述时空特征提取模块,输出包含邻近交叉口和历史信息的新的交叉口状态特征,具体为:

43、所述图注意力网络gat具体构建为:

44、输入特征矩阵x,形状为n×f,n为交叉口个数,f为交叉口状态维度;对于每个交叉口a及相邻交叉口b,对应的状态向量为和,计算交叉口a和相邻交叉口b之间的注意力系数为:

45、

46、其中,为注意力机制,是一个可学习的参数向量;t表示矩阵转置;leakyrelu为激活函数;是一个可学习的权重向量;||表示矩阵拼接操作;

47、使用softmax函数对注意力系数进行归一化,得到相邻交叉口b对交叉口a的注意力权重为:

48、

49、其中,为交叉口a和相邻交叉口b之间的注意力系数,为交叉口a和相邻交叉口c之间的注意力系数;exp为自然指数函数;是交叉口a的相邻交叉口集合;c为交叉口编号;

50、将交叉口a的所有相邻交叉口的特征进行加权求和,得到交叉口a的新特征表示,并对新特征向量应用sigmoid函数进行激活,最终输出新的特征矩阵z:

51、

52、其中,为图注意网络学习的包含相邻交叉口信息的新的交通状态,为表示邻居交叉口集合;

53、采用多头注意力机制,每个注意力头都输出各自的注意力系数,因此将多个输出的特征进行拼接得到融合特征:

54、

55、其中,为相邻交叉口b对交叉口a的注意力权重,是一个可学习的权重向量,为注意力头编号,,为注意力头总数;

56、所述门控循环单元gru具体构建为:

57、将图注意力网络输出的各交叉口的新特征作为输入,同时输入一个包含历史流量信息的隐藏状态,获得重置门信号和更新门信号:

58、

59、

60、其中,为图注意力网络输出的各交叉口的新特征;、、和是要学习的权重矩阵;

61、通过重置门将前一时刻的隐藏状态中的相关信息进行丢弃,并与当前输入的新特征进行结合,获取候选隐藏状态;之后通过更新门,结合前一时刻的隐藏状态和候选隐藏状态获得当前时刻的隐藏状态:

62、

63、

64、其中,、是要学习的权重矩阵;tanh是双曲正切激活函数,⊙表示元素级乘法;

65、所述dqn动作决策模块具体构建为:

66、将通过所述时空特征提取模块得到的隐藏状态输入到q网络,获取当前状态下的动作价值函数,为q网络参数,并通过在每个时间t上选择q值最高的动作来最大化奖励r;

67、所述值分解混合网络模块包含一个q函数的求和网络,通过输入所有路口的q函数来计算全局q函数:

68、

69、其中,为第个路口的q函数。

70、进一步地,所述步骤4包括:

71、步骤4.1:根据实际路网编写路网文件,所述路网文件包括交叉口、道路、信号灯;根据合成车流数据和真实车流数据编写车流文件,所述车流文件包括每辆车的车辆编号、车辆类型、最大加减速度、最大速度、路径信息、开始时间;根据所述路网文件和所述车流文件创建仿真环境;

72、步骤4.2:初始化超参数,包括探索率、学习率、折扣因子、经验池样本大小、随机抽样样本大小、训练回合、时空特征提取模块和dqn动作决策模块隐藏层尺寸;

73、步骤4.3:根据仿真环境和初始化的超参数训练基于强化学习的动态最大压交通信号控制模型。

74、进一步地,所述步骤4.3包括:

75、将所述智能体与仿真环境交互,获取当前状态,通过时空特征提取模块得到新的融合状态,将融合状态传入q网络输出不同动作的q值,之后按-贪婪策略选择动作,当进行动作决策时,以概率随机选择一个随机动作,以概率1-选择使q值最大的动作,整个过程表述为:

76、

77、

78、

79、

80、其中,为交叉口的状态;为通过图注意力网络gat输出的包含空间特征信息的交叉口的新状态;是通过门控循环单元gru输出的包含时间特征信息的交叉口的新特征;是由全连接层fc构成交叉口的q网络;是动作;i为交叉口编号;a为离散动作个数;是q网络需要优化的参数;rand(0,1)表示在0至1的范围内取随机数;int(0,a)表示0至n-1共a个整数随机选取;

81、收集交互过程中的轨迹经验,所述轨迹经验由状态、动作、奖励、下一状态组成,通过元组表示,将所述轨迹经验存储到经验池中,所述经验池为一个队列,当经验池容量达到上限则丢弃最开始存储的经验以存储新经验,从经验池中随机抽样批量经验样本进行学习,计算每一个经验样本的目标q值:

82、

83、其中,是折扣因子;是下一个动作;是学习的模型参数;

84、计算损失函数,使用反向传播和梯度下降更新图注意力网络、门控循环单元和dqn动作模块的网络参数,以最小化损失函数:

85、

86、其中,是批量经验样本;是批量经验样本的大小;为批量样本状态;为批量样本动作;是批量样本的编号;是目标q值;是全局q网络的q值。

87、本发明的有益效果是:

88、(1)本发明采用图注意力网络和门控循环单元构建时空特征提取模块,充分考虑相邻交叉口的影响,有效提取了包含时空特征的路网状态。

89、(2)本发明利用具有高度自适应特性的深度强化学习技术来优化模型,克服最大压信号控制模型以单一交通压力参数作为压力权重和对相邻路口压力关联的考虑不足的局限性。

90、(3)本发明结合理论控制模型的优势,使用强化学习去优化最大压控制模型,最终的控制策略由优化后的最大压控制模型得到,一定程度上解决了神经网络泛化的问题,这对于实际应用具有现实意义。

- 还没有人留言评论。精彩留言会获得点赞!