基于改进深度强化学习机制的配网无功电压主动控制方法与流程

本发明涉及智能电网无功优化,具体为基于改进深度强化学习机制的配网无功电压主动控制方法。

背景技术:

1、能源市场紧缺引起关注,促使越来越多的国家发展可再生能源。光伏、风电等分布式发电的接入、负荷的不确定性波动会导致电压质量越限甚至失稳的风险加大,影响电网安全稳定运行。配电网无功优化又称为无功电压优化控制,是保证电网稳态运行的一种有效手段,在降低供电侧经济成本的同时也提高了供电质量。

2、多类型柔性可控资源和无功补偿设备的动作变量组合导致搜索空间巨大,深度强化学习(deepreinforcementlearning,drl)是将深度学习的感知能力与强化学习的决策能力相结合,能够为配电网的无功电压控制提供新思路。

3、本发明研究电网面对多类型柔性可控资源无功响应特性,利用改进深度强化学习机制对电网进行优化控制,进一步支撑复杂电网运行条件下电网无功电压控制技术发展。

技术实现思路

1、(一)解决的技术问题

2、针对现有技术的不足,本发明提供了一种基于改进深度强化学习机制的配网无功电压主动控制方法,解决了现有无功电压控制中动作空间较大,且收敛速度较慢的技术问题。

3、(二)技术方案

4、本发明所要解决的技术问题是克服现有的技术缺陷,提出一种基于改进深度强化学习机制的电网无功电压主动控制方法,该方法在实际配电网运行环境下,处理配电网无功电压主动控制问题,旨在保证配电网安全稳定运行。该方法对深度强化学习机制进行改进设计,使得改进后的深度强化学习机制对于电压波动、可控设备动作复杂的电网运行环境效果更好,能够使得动作空间缩减,加快收敛速度,更快获得无功电压控制策略,从而保证电网的正常运行。

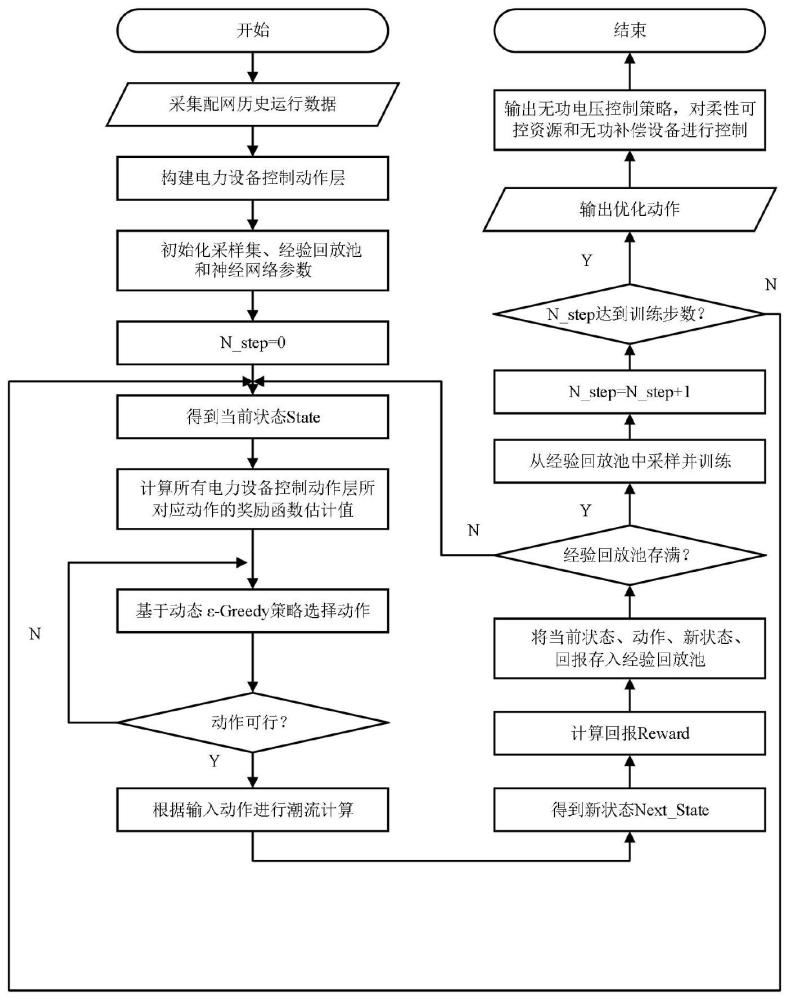

5、本发明提供了一种基于改进深度强化学习机制的电网无功电压主动控制技术,其特征在于,包括以下步骤:

6、(1)配电网历史运行数据采集阶段:根据选定的需要进行控制的含多种柔性可控资源的配电网,采集新能源、柔性可控资源汇集区域电网运行数据、含多种柔性可控资源的配电网参数信息、负荷运行数据和电力设备运行状态数据等配网历史运行数据。

7、(2)获得电力设备控制动作层,构建智能体阶段:根据参数信息,形成含多种柔性可控资源的配电网电压控制马尔科夫决策过程,并且针对大规模动作空间问题,将原始动作空间缩减得到电力设备控制动作层,构建基于改进深度强化学习机制的智能体,进而提高算法的收敛速度。

8、(3)智能体训练阶段:根据基于改进深度强化学习机制的智能体与新能源、柔性可控资源汇集区域电网运行数据、负荷运行数据和电力设备运行状态数据,对智能体进行训练。

9、(4)获取无功电压控制策略阶段:通过训练好的智能体,对含多种柔性可控资源的配电网无功补偿设备进行调控,并给出配电网的无功电压控制策略,由电力设备控制动作层处理,多种柔性可控资源和无功补偿设备执行。

10、本发明可有效针对含可再生能源的配电网给出设备配置建议,从而提升电网无功电压管理运行水平,保障电压的合理运行的同时,降低系统损耗和运行成本。

11、进一步的,所述步骤(1)中的配网历史运行数据采集,由于广域测量系统和监控设备在电网的投入使用,可实时采集到电网新能源、柔性可控资源汇集区域电网运行数据、负荷运行数据和电力设备运行状态数据等。该阶段主要是为后面电网智能体的构建与分析、挖掘电网状态和动作联系以及智能体训练做相对应的准备。根据配电系统分析和控制的需求合理配置量测,以获取所需要的数据。

12、进一步的,所述步骤(2)中的获得电力设备控制动作层和智能体构建,本发明中的智能体构建主要是对当前配电网系统中无功补偿资源,根据参数信息,统计和提取配电网运行状态下各节点有功功率、无功功率、电压幅值、柔性可控资源调控功率、调节设备的投切档位和无功补偿设备已经接入配电网的补偿量信息,形成含多种柔性可控资源的配电网电压控制马尔科夫决策过程。根据配网历史运行数据、参数,确定状态集s,用来表示配电网的当前状态。

13、s={pi,qi,vi,fi,ti,ci|i∈ωk} (1)

14、其中,s表示配电网状态空间集合;pi、qi、vi、fi、ti、ci分别表示配电网节点i的注入有功功率、注入无功功率、电压幅值、柔性可控资源调控功率、调节设备的投切档位和无功补偿设备已经接入配电网的补偿量;ωk表示配电网中可以量测的节点集合。

15、根据接入配网的柔性可控资源和无功补偿设备,确定智能体的动作向量。

16、az=[a1,a2,a3,...,an] (2)

17、其中,a1,a2,a3,...,an表示在不同节点的柔性可控资源和无功补偿设备的控制动作。根据历史运行数据,考虑类似的运行场景下,柔性可控资源和无功补偿设备的控制动作相似性,对动作层进行缩减,进而改进深度强化学习算法,加快收敛速度。从函数的非线性映射的角度分析,关键是合理构建配电网的运行状态和无功电压控制策略之间的映射关系。通过极限学习机算法对配电网状态和柔性可控资源、无功补偿设备之间的关系进行理解和学习,对动作向量进行缩减,形成电力设备控制动作层。

18、ad=[ad1,ad2,ad3,...,adn] (3)

19、其中,ad1,ad2,ad3,...,adn表示在不同节点的经过缩减后的电力设备的控制动作。其中包含了柔性负荷的功率调度,oltc的分接头档位、电容器组的投切容量。

20、进一步的,考虑配电网运行对于电压要求的安全因素和对于网损要求的经济要求,考虑约束条件包括节点电压、有功功率、无功功率以及潮流方程的约束,具体公式定义如下:

21、vi,min≤vi≤vi,max (4)

22、

23、

24、其中,ui,min,ui,max分别为节点i的电压ui的下限和上限;pwt,i和qwt,i为风电的有功功率和无功功率;ppv,i和qpv,i为光伏的有功功率和无功功率;pload,i和qload,i为负荷的有功功率和无功功率;ptou,i为柔性可控资源经过负荷转移后进行控制的有功功率;qc,i为无功补偿设备注入节点i的无功容量;nload为负荷节点;ntou为负荷转移节点;nwt和npv分别为接入风电和光伏的节点。

25、进一步的,在约束条件下,确定即时奖励r,从而得到累积回报reward。

26、

27、

28、rn=ε(r+γmaxrn(s′,a′d)) (9)

29、其中,rn表示时间步n的即时奖励;vp,i表示节点i的电压安全要求的惩罚值;δploss表示网损的优化值;vmin、vmax分别表示保证电网安全运行情况下节点允许的最小、最大电压;rn表示时间步n的奖励函数;折扣因子γ∈[0,1],表示了后续动作对于当前回报的影响;rn(s′,a′d)表示新状态s′下,采取电力设备动作层的新动作a′d时的回报函数。

30、进一步的,所述步骤(3)是在所述步骤(2)缩减获得电力设备动作层和构建的配电网电压控制的马尔科夫决策过程的基础上,对基于改进深度强化学习机制的智能体进行训练。在训练过程中,采用梯度下降法对网络权值参数进行更新,网络的损失函数如下所示:

31、l(θ)=ε(rn-q(s,ad|θ))2 (10)

32、其中,rn为回报目标值,是在考虑后续动作的基础上由式(9)计算获得;q(s,ad|θ)为状态s下动作ad的回报函数估计值。按照设定的间隔步数,对网络权重参数进行更新。

33、进一步的,智能体训练过程中根据动态ε-greedy策略进行动作选择,指的是在进行下一步动作选择时,以ε的概率随机选择一个动作,以(1-ε)的概率选择当前回报值最大的动作,所述ε如下表示:

34、ε=exp((q(s,a|θ)-q(s,amax|θ))·μn) (11)

35、其中,q(s,a|θ)表示状态s下动作a的回报函数估计值;q(s,amax|θ)表示状态s下选择回报函数估计值最大的动作amax时的回报函数估计值;μn为时间步n时的调整系数。

36、进一步的,根据当前的配电网状态,通过训练完成的智能体,得出无功电压控制策略,对柔性可控资源和无功补偿设备采取相应动作,以实现配网无功电压主动控制。

37、(三)有益效果

38、本发明提供了基于改进深度强化学习机制的电网无功电压主动控制方法。具备以下有益效果:

39、该基于改进深度强化学习机制的电网无功电压主动控制方法建立基于改进深度强化学习机制的电网智能体,充分挖掘配电网运行状态和无功电压控制设备动作的联系,有效缩减动作空间,简化了多个柔性可控资源和无功补偿设备控制时的复杂迭代过程,具有更好的收敛性和稳定性。并且充分考虑了可再生能源出力的不确定性,利用柔性负荷具备的柔性调控能力,有效控制无功补偿设备,且有针对性的给出配置建议,从而提升电网无功电压管理运行水平,保障电压的合理运行的同时,降低系统损耗和运行成本。

- 还没有人留言评论。精彩留言会获得点赞!