基于MADDPG的多配电网格单元协同运行系统及方法

本发明属于电力系统运行调度,尤其涉及基于maddpg的多配电网格单元协同运行系统及方法。

背景技术:

1、配电网是电力系统的重要组成部分。随着对配电网规划及建设,配电网格单元通过以网格为单位对负荷需求信息收集、电能区块化分配,能够更好分析用户用能特性并对配电网格单元分类。配电网格单元的设置使其在配电网运行调度中需要面对多配电网格单元系统的存在,因此其在解决多配电网格单元协同运行问题时需要进行更为深入的研究。

2、多配电网格单元协同运行问题是一个复杂的决策优化问题。在过去的研究中通常采用粒子群算法、遗传算法等进行求解,但这类算法在应用中存在一定局限性,一是考虑到精确建模的困难及求解需要较长的计算时间,无法应对需要快速响应的实际应用问题,二是这些算法在计算过程中容易陷入局部最优解,无法满足实际应用中决策的最优性。深度强化学习算法的初步应用为这类决策优化问题提供了新的思路,基于数据驱动的深度强化学习算法具有迅速响应并给出最优解的能力。而对于多配电网格单元协同运行问题,可定义其为多智能体环境的调度问题,还需要处理配电网格单元间的协同关系、状态空间与动作空间连续且复杂等问题。

技术实现思路

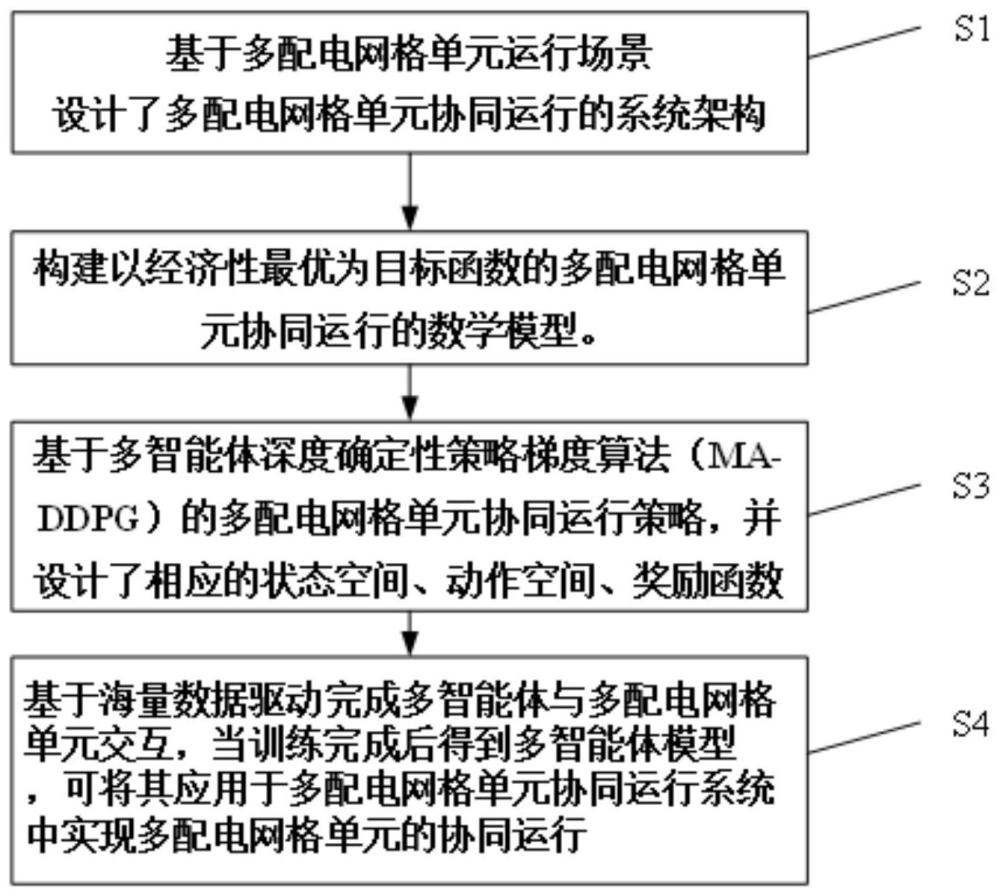

1、本发明针对多智能体环境的调度决策问题,提出了一种基于maddpg的多配电网格单元协同运行系统及方法,能够快速决策并指导多配电网格单元间协同运行。

2、本发明提供一种基于maddpg的多配电网格单元协同运行系统,包括:基于多配电网格单元运行场景设计了多配电网格单元协同运行的系统架构。

3、该系统架构主要包括三层,分别为状态空间层、信息传输层和智能决策层。

4、状态空间层是包含了多个配电网格单元的风机、光伏、储能等设备及相应的监测装置,能够实现对多配电网格单元的运行数据实时监控及采集;信息传输层一方面能够对状态空间层的数据进行处理、存储及上传,另一方面能够根据上层智能决策层的调度动作实现配电网格单元间协同运行;智能决策层是根据训练得到的多智能体模型在信息传输层传输的多配电网格单元状态信息下采取相应的调度动作。

5、本发明还提供一种基于maddpg的多配电网格单元协同运行系统的方法,包括:

6、s01:构建以经济性最优为目标函数的多配电网格单元协同运行的数学模型。

7、s02:基于多智能体深度确定性策略梯度算法(multi-agent deep deterministicpolicy gradient,maddpg)的多配电网格单元协同运行策略,并设计了相应的状态空间、动作空间、奖励函数。

8、s03:基于海量数据驱动完成多智能体与多配电网格单元交互,当训练完成后得到多智能体模型,可将其应用于多配电网格单元协同运行系统中实现多配电网格单元的协同运行。

9、根据本发明提供的一种基于maddpg的多配电网格单元协同运行系统的方法,包括以下具体步骤:

10、s02步骤中,构建以经济性最优为目标函数的多配电网格单元协同运行的数学模型。

11、①目标函数:

12、多配电网格单元协同运行是以整体运行成本最优为目标函数:

13、

14、式中:ne为配电网格单元的数量,c为整体系统的运行总成本,ci为配电网格单元i的运行成本。

15、

16、式中:cbes,i(t)为储能设备的运行成本,cex,i(t)为配电网格单元的功率交互成本,cg,i(t)为微型燃气轮机的运行成本。

17、1)储能设备的运行成本:

18、cbes,i(t)=λch,ipbes,i,ch(t)+λdis,ipbes,i,dis(t)

19、式中:λch,i、λdis,i分别为配电网格单元i的储能设备充电与放电的损耗成本系数(单位为元/mw),pbes,i,ch(t)、pbes,i,dis(t)分别为配电网格单元i储能设备在时刻t的充电功率与放电功率。

20、2)功率交互成本:

21、

22、式中:λex分别为配电网格单元之间的功率交互成本系数(单位为元/mw);δpij(t)为第i个配电网格单元与第j个配电网格单元之间的功率交互。

23、3)微型燃气轮机成本:

24、cg,i(t)=aipg,i(t)

25、式中,ai为配电网格单元i中微型燃气轮机运行成本的燃料系数(单位分别为元/kw),pg,i(t)表示配电网格单元i中微型燃气轮机在时刻t的出力。

26、②约束条件:

27、(1)微型燃气轮机约束:

28、输出上下限约束:

29、

30、式中,pg,i,min、pg,i,max分别为配电网格单元i中微型燃气轮机的输出功率上下限。

31、爬坡约束:

32、

33、

34、式中:pg,i,up、pg,i,down分别为配电网格单元i中微型燃气轮机的爬坡上下限,pg,i(t)、pg,i(t-1)分别为配电网格单元i中微型燃气轮机在时刻t与时刻t-1的输出功率。

35、(2)储能设备运行约束:

36、储能设备出力上下限约束:

37、

38、

39、式中:分别为配电网格单元i中储能设备的充电功率上下限;分别为配电网格单元i中储能设备的放电功率上下限。

40、储能荷电量约束:

41、

42、ses,min≤ses(t)≤ses,max

43、式中:ses(t)、ses(t-1)表示t与t-1时段储能装置能量状态;σes表示储能装置自损率;ηes,ch和ηes,dis表示充放电效率;pbes,i,ch(t-1)、pbes,i,dis(t-1)为配电网格单元i中储能设备t-1时段储能充放电功率。ses,max和ses,min为储能装置能量状态上下限。

44、另外,储能设备在一个调度周期结束和开始时储存的能量要相同,该约束表示为:

45、ses(0)=ses(t)

46、(3)功率平衡约束:

47、为保证配电网格单元内部的功率平衡,当内部无法满足时,可通过与其他配电网格单元进行功率交互实现功率平衡。其功率平衡表达式如下:

48、

49、式中:pload,i(t)为t时段电负荷;pbes,i,dis(t)表示t时段储能放电功率;pbes,i,ch(t)表示t时段储能充电功率;ppv,i(t)、pw,i(t)分别为光伏与风机的出力。

50、s03步骤中,基于多智能体深度确定性策略梯度算法(multi-agent deepdeterministic policy gradient,maddpg)的多配电网格单元协同运行方法,并设计了相应的状态空间、动作空间、奖励函数。

51、多配电网格单元协同运行系统是以深度强化学习算法为策略核心,其能够在每个采取动作时间时采取合适的动作与环境进行交互产生状态的转移并提供奖励,在与多配电网格单元协同运行系统场景交互过程中,其状态变化是由系统场景与深度强化学习算法所具有的智能体交互完成的。ddpg算法是一种基于actor-critic框架的深度强化学习算法,其设置了独立目标网络,具有经验回放能力,能够打破数据之间的关联性,降低模型的训练难度。进一步多智能体ddpg(ma-ddpg)算法是一种能够适用于多配电网格单元协同运行的应用场景,其具备“集中训练、分散执行”的协调配合模式。critic(q网络)能获得全局信息(o1,o2,...,on)和全局动作(a1,a2,...,an);而actor(π网络)只能根据本地的观察来做出动作。

52、maddpg算法流程如下所示:

53、步骤(1):设定经验回放池d存储容量,设定多智能体的个数n

54、步骤(2):设定模型训练回合总次数m,初始化m=1,设定一个回合的总调度时间为t,并设定时间步长为1;

55、步骤(3):进入训练回合m,初始化当前多配电网格单元协同运行环境的状态特征,并组成对应智能体需要的状态序列si,t;

56、步骤(4):每个智能体根据对应环境状态信息si,t在当前策略及探索扰动n叠加下选择动作at,其动作选择表达式为:

57、

58、式中:为智能体i的当前策略,δ为探索扰动。

59、步骤(5):将多智能体的动作集合at=[a1,t,ai,t,...,an,t]与多配电网格单元的环境场景进行交互,环境将会转移到新状态si,t+1,并获得相应的奖励ri,t;

60、步骤(6):将上述信息组成四元组序列(st,at,st+1,rt),并将其存储在经验回放池d中;

61、步骤(7):随着训练次数的增加,当经验回放池存储足够多经验数据时,随机采样四元组序列数据更新critic网络及actor网络参数,其相应网络的损失函数公式如下所示:

62、

63、步骤(8):更新多智能体相应的目标网络参数:

64、θ'i=τθi+(1-τ)θ'i

65、步骤(9):当总回合训练结束时,其多智能体模型训练完成能够投入使用实现多配电网格单元的协同运行。

66、进一步,根据多配电网格单元协同运行场景对状态空间、动作空间、奖励函数进行设计:

67、①状态空间:

68、每个配电网格单元可视为由一个智能体进行控制,因此智能体的状态集为可再生能源光伏与风机的出力、负荷的实际需求、储能的容量状态。由此可定义状态空间s为:

69、si=[pload,i(t),ppv,i(t),pw,i(t),ses(t)]

70、②动作空间:

71、智能体的联合动作集a,是发送至储能设备以及联络线交互的控制信号的实时集合,故可定义动作空间为:

72、ai=[pg,i(t),pbes,i,ch(t),pbes,i,dis(t),δpij(t)]

73、③奖励函数:

74、根据多配电网格单元协同运行模型,考虑到多配电网格单元整体系统的经济运行成本最优化,结合数学模型中构建的目标函数,可对各智能体的奖励函数进行设置:

75、

76、式中:ri表示的是对于配电网单元格i的智能体所具有的奖励函数,包含了配电网格单元中所有设备的运行成本及功率交互成本。

77、s04步骤中,基于海量数据驱动完成多智能体与多配电网格单元交互,当训练完成后得到多智能体模型,可将其应用于多配电网格单元协同运行系统中实现多配电网格单元的协同运行。

78、智能决策层通过信息传输层收集来自状态空间层的不同配电网格单元环境信息,包含储能状态、负荷需求、风力与光伏出力,根据智能决策层中多智能体模型给出配电网格单元的调度动作,信息传输层根据上层的调度动作对状态空间层中配电网格单元的储能装置的充放电以及功率交互动作,从而实现多配电网格单元之间的协同运行并具有较好的整体系统运行经济性。

79、本发明还提供一种电子设备,包括存储器、处理器及存储在存储器上并可在处理器上运行的计算机程序,所述处理器执行所述程序时实现如上述任一种所述基于maddpg的多配电网格单元协同运行方法。

80、本发明还提供一种非暂态计算机可读存储介质,其上存储有计算机程序,该计算机程序被处理器执行时实现如上述任一种所述基于maddpg的多配电网格单元协同运行方法。

81、本发明还提供一种计算机程序产品,包括计算机程序,所述计算机程序被处理器执行时实现如上述任一种所述基于maddpg的多配电网格单元协同运行方法。

82、与现有技术相比,本发明的有益效果:本发明所提出的基于maddpg的多配电网格单元协同运行方法在训练过程中多个智能体根据各自控制的配电网格单元中获取的环境信息做出动作,并依据奖励函数指导各智能体进行策略的优化,从而实现多智能体与环境的交互探索中协同运行并优化策略;应用过程中将训练好的多智能体模型内置于系统架构,通过状态空间层、信息传输层与智能决策层实现状态信息监测、传输及最优调度策略的下达,最终实现快速响应多配电网格单元协同运行并保证其具有较好的运行经济性。

- 还没有人留言评论。精彩留言会获得点赞!