汇聚边缘云池组化系统的制作方法

1.本发明涉及通信技术领域,尤其涉及一种汇聚边缘云池组化系统。

背景技术:

2.5g时代,通信网络向网络架构演进,通过引入简化的网络设备,提升网络流量疏导能力,采用“核心+汇聚/接入”的简化架构,以实现通信云、移动业务、政企客户接入以及固网宽带等业务综合承载的目标,构建出以通信云数据中心为核心的融合承载的智能城域网。在智能城域网中,大多数业务数据流量由客户端和服务器之间的南北向流量组成;同时由于虚拟化技术的发展,应用程序越来越多地以分布式方式部署,导致东西向流量带宽的需求也在不断增加。

3.现有技术中,对南北向流量的传送支撑提出了汇聚边缘云的架构理念,这种汇聚边缘云涉及核心云、边缘云与整个通信网的协同,完全可以满足增强型移动带宽的5g应用场景,对固移业务的综合承载支持能力较高;而对东西向流量的传送支撑采用的是脊叶拓扑架构,这种拓扑架构能够提供高带宽、低延迟、低抖动以及无阻塞的服务器到服务器连接服务;这两种处理方式都仅满足单一向的流量传送支撑需求。

4.因此,在智能城域网中如何将汇聚边缘云和脊叶拓扑架构结合以更好的应对各方向流量的传送支撑需求是一个亟待解决的问题。

技术实现要素:

5.本发明提供一种汇聚边缘云池组化系统,实现在智能城域网中将汇聚边缘云和脊叶拓扑架构结合以更好的应对各方向流量的传送支撑需求。

6.第一方面,本发明提供一种汇聚边缘云池组化系统,包括:通信云资源池和至少一个汇聚边缘云资源池;

7.通信云资源池部署有一对一级核心路由设备;

8.汇聚边缘云资源池部署有一个中心汇聚边缘云和至少一个汇聚边缘云,中心汇聚边缘云部署有一对二级核心路由设备;汇聚边缘云部署有一对汇聚路由设备;

9.根据预设的脊叶拓扑架构将一级核心路由设备和二级核心路由设备互联;并将二级核心路由设备和汇聚路由设备互联;以及将汇聚路由设备和汇聚边缘云内部的设备互联。

10.在一种可能的设计中,通信云资源池部署有管理节点;

11.中心汇聚边缘云部署有第一计算节点;汇聚边缘云部署有第二计算节点;其中,中心汇聚边缘云所属机房较汇聚边缘云所属机房空间大且供电充足,可部署较多服务器;

12.应用智能城域网,管理节点和第一计算节点互联;第一计算节点和第二计算节点互联。

13.在一种可能的设计中,当汇聚边缘云资源池内部署大于一个汇聚边缘云时,每个汇聚边缘云中的第二计算节点对应的业务数据流通过汇聚路由设备互通。

14.在一种可能的设计中,当预设范围内部署大于一个汇聚边缘云资源池时,每个汇聚边缘云资源池中的中心汇聚边缘云中的第一计算节点对应的业务数据流通过二级核心路由设备互通。

15.在一种可能的设计中,当管理节点接收到第二计算节点的故障消息时,根据预先存储的第二计算节点对应的容灾计算节点,将第二计算节点对应的业务数据流牵引至容灾计算节点上。

16.在一种可能的设计中,当管理节点接收到第二计算节点对应的业务承载负荷大于第一阈值时,将第二计算节点对应的业务数据流牵引至汇聚边缘云资源池内的其他节点上。

17.在一种可能的设计中,通信云资源池部署有一对一级核心路由设备;

18.汇聚边缘云资源池部署有一个中心汇聚边缘云,中心汇聚边缘云部署有一对二级核心路由设备;

19.根据预设的脊叶拓扑架构将一级核心路由设备和二级核心路由设备互联。

20.在一种可能的设计中,当一级核心路由设备、二级核心路由设备和汇聚路由设备中的任一设备容量不足以承载当前业务时,通过新增加对应设备进行扩容。

21.在一种可能的设计中,第一计算节点和第二计算节点都为一组服务器资源,用于承载汇聚边缘云的业务数据流。

22.在一种可能的设计中,管理节点和第一计算节点、第二计算节点通过心跳检测机制监测存活状态。

23.本发明提供一种汇聚边缘云池组化系统,该系统包括通信云资源池和至少一个汇聚边缘云资源池;通信云资源池部署有一对一级核心路由设备;汇聚边缘云资源池部署有一个中心汇聚边缘云和至少一个汇聚边缘云,中心汇聚边缘云部署有一对二级核心路由设备;汇聚边缘云部署有一对汇聚路由设备;根据预设的脊叶拓扑架构将一级核心路由设备和二级核心路由设备互联;并将二级核心路由设备和汇聚路由设备互联;以及将汇聚路由设备和汇聚边缘云内部的设备互联,实现在智能城域网中将汇聚边缘云和脊叶拓扑架构结合以更好的应对各方向流量的传送支撑需求。

附图说明

24.为了更清楚地说明本发明实施例或现有技术中的技术方案,下面将对实施例或现有技术描述中所需要使用的附图作一简单地介绍,显而易见地,下面描述中的附图是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动性的前提下,还可以根据这些附图获得其他的附图。

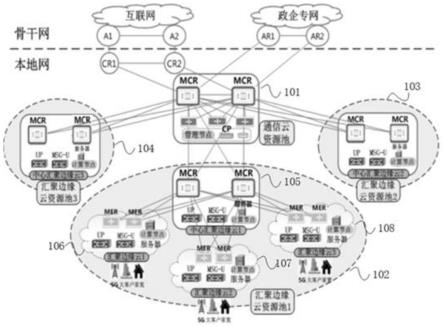

25.图1为本发明根据一示例实施例示出的汇聚边缘云池组化系统的应用场景图;

26.图2为本发明根据一示例实施例示出的汇聚边缘云池组化系统的计算节点分层架构示意图;

27.图3为本发明根据一示例实施例示出的汇聚边缘云池组化系统的扩容示意图;

28.图4为本发明根据一示例实施例示出的汇聚边缘云池组化系统的部署架构示意图。

management function,smf)/多业务接入网关控制面(multi-service access gateway control plane,msg-c)等,云管平台的管理设备即管理节点,能力开放节点设备,比如编排协同器。(2)业务应用者的相关设备:业务应用调度节点和业务应用核心云节点。

35.在通信云资源池内部署一对一级核心路由设备(metro core router,mcr),负责地市本地网的数据流量汇聚和转发,一级mcr和汇聚边缘云资源池中的中心汇聚边缘云中的二级mcr通过脊叶拓扑架构互联。

36.汇聚边缘云资源池:运营商将地理位置上相邻的若干个连片的汇聚边缘云进行服务器资源整合,组成一个汇聚边缘云资源池,同一个汇聚边缘云资源池内各汇聚边缘云的计算节点之间通过智能城域网实现超大传输带宽、超短传输路径、超低传输时延和超低传输时延抖动的网际互连协议(internet protocol,ip)路由互通,整合同一个汇聚边缘云资源池内的所有计算节点的服务器资源进行统筹安排、统一调度,比如,计算资源中央处理器(central processing unit,cpu)、图形处理器(graphic processing unit,gpu)、存储资源磁盘、内存、数据库等。

37.汇聚边缘云是汇聚层边缘云的简称,位于地市本地网传输汇聚机房,每个汇聚边缘云承载了移网、宽带和政企专线业务。运营商在汇聚边缘云部署用户面设备(user plane,up)和服务器资源即计算节点。汇聚边缘云还部署业务应用者的相关设备,比如业务应用边缘云节点。每个汇聚边缘云内部都部署一对汇聚路由设备(metro edge router,mer),负责汇聚边缘云内部的数据流量的汇聚和转发,并且mer和各自汇聚边缘云内部的设备之间也采用脊叶拓扑架构互联。每个汇聚边缘云有自己独立的标识。

38.中心汇聚边缘云:把一个汇聚边缘云资源池内某个空间大且供电充足的机房中的汇聚边缘云设定为该资源池内的中心汇聚边缘云,在中心汇聚边缘云部署一对二级mcr,或者让mer兼做二级mcr,因为在此网络拓扑架构下,汇聚边缘云资源池内各汇聚边缘云的计算节点之间业务数据流量走不同传输路由并不会引起传输时延明显变化,二级mcr负责资源池内东西向流量的转发,通过脊叶拓扑架构与汇聚边缘云资源池内其它汇聚边缘云的mer互联。其中,中心汇聚边缘云和其它的汇聚边缘云一样,同样承载移网、宽带和政企专线业务,并有自己独立的汇聚边缘云标识。

39.本地网中不同的两个汇聚边缘云资源池之间和每个汇聚边缘云资源池内,通过脊叶拓扑架构进行互联,以解决各汇聚边缘云资源池中计算节点之间的东西向无阻塞大流量、低时延、低抖动、高可靠高稳定的数据传输需求痛点。为汇聚边缘云池组化的理念落地实施提供坚实而强大的网络架构支撑。

40.上述通信云资源池、汇聚边缘云资源池、中心汇聚边缘云以及汇聚边缘云都由运营商管理和运营。

41.在一种可能的设计中,应用智能城域网,管理节点和第一计算节点互联;第一计算节点和第二计算节点互联。

42.其中,管理节点部署于省市核心机房的通信云资源池内,负责统一管理所有的计算节点,并提供镜像仓库、监控等功能,管理节点一般配置为3节点的高可用集群,可管理上千个计算节点。管理节点支持对预设范围内所有计算节点的基础设施即服务(infrastructure as a service,iaas)+平台即服务(platform as a service,paas)的底座进行远程配置,可灵活配置容灾、负载分担等策略,并对计算节点的资源和能力进行灵活

调度。同时各类业务应用的业务调度节点可以与运营商的管理节点同局房部署,便于实现信息快速交互,运营商的能力开放平台/节点与管理节点同局房部署,能力开放节点提供信息查询和能力调用接口,供各类业务应用调用。管理节点属于下层基础能力平台,由运营商统一管理和运营。

43.计算节点是运营商在汇聚边缘云部署的一组服务器资源,位于地市本地网传输汇聚机房,承载各类上层业务应用的轻量级边缘云业务应用,受汇聚机房的空间、动力和空调限制,运营商计算节点一般包含几台服务器。通过虚机、容器等虚拟化技术,运营商在计算节点部署iaas层和paas层,业务应用提供者部署软件即服务(software-as-a-service,saas)层,运营商提供包括云、网、平台相关信息在内的应用开发运行环境和开发工具组件,灵活支持多个业务应用提供者的各种业务应用saas的快速上线和迭代,实现多租户共享边缘云的服务器资源。实现运营商iaas+paas底座平台与各类上层业务应用saas的灵活快速适配和共享承载。

44.每个计算节点有自己唯一的标识,由管理节点统一编号和管理。图2为本发明根据一示例实施例示出的汇聚边缘云池组化系统的计算节点分层架构示意图,如图2所示,运营商云管平台的管理节点和计算节点通过智能城域网实现路由互通,管理节点和计算节点之间通过传输控制协议(transmission control protocol,tcp)或者网络互连协议(internet protocol,ip)进行交互,实现计算节点统一管理,任务统一下发,并且管理节点与计算节点通过心跳检测机制相互监测存活状态。

45.在一种可能的设计中,当汇聚边缘云资源池内部署大于一个汇聚边缘云时,每个汇聚边缘云中的第二计算节点对应的业务数据流通过汇聚路由设备互通。

46.其中,汇聚路由设备mer用于多业务综合承载,包括移网基站回传业务、大客户业务、通信云业务以及家庭宽带业务等。具体的,将mer部署在汇聚边缘云所在的传输汇聚机房,并通过脊叶拓扑架构上联二级核心路由设备mcr。

47.在一种可能的设计中,当预设范围内部署大于一个汇聚边缘云资源池时,每个汇聚边缘云资源池中的中心汇聚边缘云中的第一计算节点对应的业务数据流通过二级核心路由设备互通。

48.在一种可能的设计中,当管理节点接收到第二计算节点的故障消息时,根据预先存储的第二计算节点对应的容灾计算节点,将第二计算节点对应的业务数据流牵引至容灾计算节点上。

49.在一种可能的设计中,当管理节点接收到第二计算节点对应的业务承载负荷大于第一阈值时,将第二计算节点对应的业务数据流牵引至汇聚边缘云资源池内的其他计算节点上。

50.上述可能的设计中,运营商通过打造一个统一的云平台底座,基于汇聚边缘云部署iaas+paas的统一平台,将云管平台的管理节点部署于省市核心通信云机房,将几百个计算节点部署于汇聚边缘云,运营商在计算节点部署轻量级的云平台底座,降低系统开销,预留宝贵的计算、存储资源部署各类上层业务应用;各类业务应用提供者在核心云部署重量级的应用,把主要、海量业务数据存储在核心云,实现轻重合理高效搭配。

51.运营商搭建和管理的iaas+paas平台和各类上层业务应用的saas灵活快速适配,系统架构上深度融合,畅通信息交互通道,提供信息查询和能力调用的接口。汇聚边缘云管

理节点和业务应用调度节点之间可以共享业务相关的信息,举例来说,当管理节点接收到第二计算节点的故障消息时,根据预先存储的第二计算节点对应的容灾计算节点,管理节点通知业务应用调度节点,由业务应用调度节点进行业务策略调整,将第二计算节点对应的业务数据流牵引至容灾计算节点上。当管理节点接收到第二计算节点对应的业务承载负荷大于第一阈值时,管理节点通知业务应用调度节点,将第二计算节点对应的业务数据流牵引至汇聚边缘云资源池内的其他计算节点上。

52.在一种可能的设计中,通信云资源池部署有一对一级核心路由设备;

53.汇聚边缘云资源池部署有中心汇聚边缘云,中心汇聚边缘云部署有一对二级核心路由设备;

54.根据预设的脊叶拓扑架构将一级核心路由设备和二级核心路由设备互联。

55.在一种可能的设计中,当一级核心路由设备、二级核心路由设备和汇聚路由设备中的任一设备容量不足以承载当前业务时,通过新增加对应设备进行扩容。

56.具体的,图3为本发明根据一示例实施例示出的汇聚边缘云池组化系统的扩容示意图,如图3所示,举例来说,对于大型城市或超大型城市,可以考虑部署2个层级的mcr以实现数据流量的分层级处理。不同汇聚边缘云资源池的mcr通过脊叶拓扑架构上联上一级mcr,对于超大型城市,上一级mcr可以考虑在2个不同的核心机房各部署1对mcr,以更好地保障本地网的整体网络安全。由于采用脊叶拓扑架构进行互联,同一层级的mcr之间的数据流量负荷分担比较均衡,如果某个mcr出现故障,其承载的流量会被同一层级的其它mcr均衡分担,不会出现拥塞,因此基本上不会影响网络性能指标和用户业务体验。脊叶拓扑架构可以同时带来更高的扩容灵活性和便捷性,当mcr或mer节点容量不足或业务规模增长较大时,可通过新增mcr或mer节点实现简单快速扩容的同时,不改动和影响现有网络拓扑架构,方便运营商运营以提升运营效率和效益。

57.固移业务融合承载的汇聚边缘云,由于同时为固网宽带、移网用户以及政企专线客户提供服务,用户规模显著增大,由于服务的用户数增加带来的规模效应显著提升,可以提升汇聚边缘云计算节点的热点缓存内容命中效率、计算效率,减少多个计算节点(比对固网、移网的用户分别进行内容缓存)之间重复的缓存内容刷新,提升了运营商整体资源利用和运营效率。

58.在实际部署中,运营商汇聚边缘云的云管平台部署架构、运营商的固移综合承载网络架构和上层业务应用的部署架构精准匹配。其中,业务应用调度节点、业务应用核心云节点、运营商的能力开放节点、边缘云管理节点、移固网络的控制面节点在省市核心机房通信云资源池部署,其中,业务应用核心云节点可以灵活部署于不同的通信云资源池机房。同时,业务应用边缘云saas节点部署于运营商的汇聚边缘云计算节点的iaas+paas平台之上,运营商的移网和固网用户面转发节点在汇聚边缘云部署。

59.通过以上部署方法,实现云管平台、本地网设备、业务应用节点全面共局址匹配部署,核心云、本地网络、汇聚边缘云、终端、业务应用和平台,比如新业务新产品的开发和孵化平台、运营商能力开放平台深度融合和高效互动,敏捷支撑不同垂直行业个性化、差异化、定制化的业务需求。图4为本发明根据一示例实施例示出的汇聚边缘云池组化系统的部署架构示意图,如图4所示,各类上层业务应用的调度节点可以通过运营商的能力开放平台/节点提供的应用程序接口(application program interface,api))实现快捷访问,按

需实时查询运营商的云、网资源的状态信息,状态信息包括云、网的资源利用率、各计算节点故障信息等,根据业务感知的质量指标,按需动态实时进行运营商的云网能力调用,比如,进行端到端服务质量(quality of service,qos)保障或5g切片运营,计算节点内部容量的扩缩容或计算节点数量的增减部署,或按需实时流量调优等,以提升业务感知能力。

60.核心云和边缘云的业务应用服务端、业务应用用户端有缓存功能,支持移动同步,计算节点和汇聚边缘云资源池之间移动通过应用层解决。用户在不同计算节点的覆盖范围,以及在不同汇聚边缘云资源池的覆盖范围之间移动时,为了保证用户业务体验的连续性,相关同步管理通过业务应用层实现。为支持以下的汇聚边缘云池组化的业务调度方法,需做好业务应用的进度同步管理,作为业务应用提供者进行业务调度的前提条件。具体的,每个业务应用位于计算节点的服务端和位于客户终端的客户端应支持进度缓存功能,以支撑不同汇聚边缘云的计算节点之间的业务数据同步,保证用户业务体验的连续性。

61.本发明提供的汇聚边缘云池组化系统,通过根据脊叶拓扑架构和汇聚边缘云池组化理念进行适配产生新的汇聚边缘云池组化系统架构,在满足现有的汇聚边缘云南北向较大的业务数据流量的支撑需求的同时,能够满足不同汇聚边缘云资源池之间东西向较大的业务数据流量,以及新产生的汇聚边缘云资源池内的不同汇聚边缘云间的计算节点对应的业务数据流量的支撑需求。

62.最后应说明的是:以上各实施例仅用以说明本发明的技术方案,而非对其限制;尽管参照前述各实施例对本发明进行了详细的说明,本领域的普通技术人员应当理解:其依然可以对前述各实施例所记载的技术方案进行修改,或者对其中部分或者全部技术特征进行等同替换;而这些修改或者替换,并不使相应技术方案的本质脱离本发明各实施例技术方案的范围。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1