具有至少一个听力设备的听力系统及运行听力系统的方法与流程

1.本发明涉及一种运行听力系统的方法,听力系统用于辅助用户的听力,并且具有至少一个佩戴在用户的耳朵中或者耳朵上的听力设备。本发明还涉及这种听力系统。

背景技术:

2.一般将辅助佩戴听力设备的人(下面称为“佩戴者”或者“用户”)的听力的电子设备称为听力设备。本发明特别是涉及如下的听力设备,这些听力设备被配置为用于完全或者部分地补偿听力受损的用户的听力损失。这种听力设备也称为“助听器”。此外,存在如下的听力设备,这些听力设备保护或者改善听力正常的用户的听力,例如要使得能够在复杂的听力情形中改善语音理解能力。

3.一般地说听力设备,具体地说助听器,通常被构造为用于由用户佩戴或者佩戴在用户的耳朵上,特别是作为耳后式设备(根据英文术语“behind the ear(耳后式)”,也称为bte设备)或者入耳式设备(根据英文术语“in the ear(入耳式)”,也称为ite设备)。关于其内部结构,听力设备通常具有至少一个(声电)输入转换器、信号处理单元(信号处理器)和输出转换器。在听力设备运行时,输入转换器接收来自听力设备的环境的空气声(luftschall),并且将这种空气声转换为输入音频信号(即传输有关环境声音的信息的电信号)。下面,也将该输入音频信号称为“接收到的声音信号”。在信号处理单元中,对输入音频信号进行处理(即在其声音信息方面进行修改),以辅助用户的听力,特别是补偿用户的听力损失。信号处理单元将相应地处理后的音频信号(也称为“输出音频信号”或者“修改后的声音信号”)输出到输出转换器。在大多数情况下,输出转换器被构造为电声转换器,电声转换器又将(电)输出音频信号转换为空气声,其中,将(相对于环境声音修改后的)这种空气声输出到用户的耳道中。在听力设备佩戴在耳朵后面的情况下,也称为“听筒”(“接收器”)的输出转换器通常在耳朵外部集成听力设备的壳体中。在这种情况下,借助音管将输出转换器输出的声音引导到用户的耳道中。作为其替换,输出转换器也可以布置在耳道中,因此布置在佩戴于耳朵后面的壳体的外部。这种听力设备(根据英文术语“receiver in canal(接收器在耳道中)”)也称为ric设备。佩戴在耳朵中的听力设备的尺寸非常小,使得它们不会向外突出到耳道外部,(根据英文术语“completely in canal(完全在耳道中)”)也称为cic设备。

4.在其它结构形式中,输出转换器也可以被构造为机电转换器,机电转换器将输出音频信号转换为固体声(振动),其中,例如将这种固体声输出到用户的头骨中。此外,存在可植入的听力设备,特别是耳蜗植入物,以及输出转换器直接刺激用户的听觉神经的听力设备。

5.术语“听力系统”表示一个设备或者一组设备以及一起提供在听力设备运行时所需的功能的可能的非物理的功能单元。在最简单的情况下,听力系统可以由一个听力设备构成。作为其替换,听力系统可以包括两个协同作用的听力设备,用于向用户的两只耳朵供应。在这种情况下,将其称为“双耳听力系统”。附加地或者替换地,听力系统可以包括至少

一个另外的电子设备,例如用于助听器或者每一个助听器的遥控器、充电设备或者编程设备。在现代听力系统中,经常设置特别是所谓的app(应用程序)形式的控制程序,来代替遥控器或者专用的编程设备,其中,这种控制程序被构造为在外部计算机、特别是智能电话或者平板电脑上实现。在此,外部计算机本身通常不是听力系统的一部分,并且特别是一般也不由听力系统的制造商提供。

6.听力受损的用户以及(在较小的程度上)还有听力正常的用户的一个经常的问题在于,在多个人说话的听力情形(多说话人环境)中,对话者被很差地理解。可以部分通过输入音频信号的与方向有关的衰减(波束成形)来解决该问题。通常设置相应的算法,使得其相对于其它噪声源,选择性地突出来自前方的环境声音的部分,从而只要用户看着对话者,那么使用户可以更好地理解对话者。但是这种信号处理不利地限制了用户与环境进行交互的可能性。例如,在交谈期间,用户不能使头部偏离对话者,从而不会有失去联系的危险。此外,传统的与方向有关的衰减也增加了如下的风险,即,用户不理解或者甚至根本没有注意到想要参与交谈、但是位于定向波瓣外部的其他人。

技术实现要素:

7.本技术要解决的技术问题是,使得听力系统的用户特别是在多说话人环境中能够更好地理解语音。

8.根据本发明,在方法方面,上述技术问题通过运行用于辅助用户的听力的听力系统的方法来解决。根据本发明,在助听器系统方面,上述技术问题通过用于辅助用户的听力的听力系统来解决。在下面的描述中说明部分本身被视为具有创造性的本发明的有利的设计方案和扩展方案。

9.一般地说,本发明基于用于辅助用户的听力的听力系统,其中,听力系统具有至少一个佩戴在用户的耳朵中或者耳朵上的听力设备。如前面所描述的,在本发明的简单的实施方式中,听力系统可以仅由一个听力设备构成。但是除了听力设备之外,优选听力系统还包括用于供应用户的另一只耳朵的至少一个另外的部件、例如另一个(特别是相同类型的)听力设备,用于在用户的外部计算机(特别是智能电话)上执行的(特别是app形式的)控制程序,和/或至少一个另外的电子设备、例如遥控器或者充电设备。在此,听力设备和至少一个另外的部件彼此进行数据交换,其中,听力系统的数据存储和/或数据处理功能分布在听力设备和至少一个另外的部件上。

10.听力设备具有至少一个用于从听力设备的环境中接收(特别是空气声形式的)声音信号的输入转换器、用于为了辅助用户的听力而处理(修改)接收到的声音信号的信号处理单元以及用于输出修改后的声音信号的输出转换器。如果听力系统具有用于供应用户的另一只耳朵的另一个听力设备,则该另一个听力设备优选也具有至少一个输入转换器、信号处理单元和输出转换器。代替具有输入转换器、信号处理单元和输出转换器的第二听力设备,对于第二只耳朵,也可以设置如下的听力设备,该听力设备本身没有输出转换器,而是仅接收声音,并且在进行或者不进行信号处理的情况下,将其转发至第一只耳朵的听力设备。这种所谓的cros或者bicros设备特别是用于单侧耳聋的用户。

11.听力系统的听力设备或者每一个听力设备特别是以开头描述的结构形式(具有内部或者外部输出转换器的bte设备,ite设备、例如cic设备,植入式听力设备、特别是耳蜗植

入物等)中的一种存在。在双耳听力系统的情况下,优选两个听力设备被构造为具有相同的类型。

12.输入转换器或者每一个输入转换器特别地是将来自环境的空气声转换成电输入音频信号的声电转换器。为了使得能够以与方向有关的方式对接收到的声音信号进行分析和处理,听力系统优选包括至少两个输入转换器,其可以布置在同一个听力设备中,或者如果存在,可以分布在听力系统的两个听力设备上。输出转换器优选被构造为电声转换器(听筒),电声转换器将信号处理单元修改后的音频信号又转换成空气声。替换地,输出转换器被构造为用于输出固体声或者直接刺激用户的听觉神经。

13.信号处理单元优选包括应用于接收到的声音信号、即输入音频信号的多个信号处理功能,用于对接收到的声音信号进行预处理,以便辅助用户的听力。信号处理功能特别是包括以下功能中的任意选择:频率选择性放大、动态压缩、频谱压缩、与方向有关的衰减(波束成形)、干扰噪声抑制、例如借助维纳滤波器(wiener

‑

filter)的一般的干扰噪声抑制或者主动干扰噪声抑制(active noise cancellation(主动降噪),缩写为anc)、主动反馈抑制(active feedback cancellation(主动反馈消除),缩写为afc)、风噪声抑制、语音识别(voice activity detection(语音活动检测))、对自己的声音的识别或者预处理(own voice detection(自身语音检测)或者own voice processing(自身语音处理))、耳鸣掩蔽等。在此,这些功能中的每一个或者这些功能中的至少大部分可以通过一个或多个信号处理参数进行参数化。将如下变量称为信号处理参数,可以对该变量相关联不同的值,用于影响相关信号处理功能的作用方式。在最简单的情况下,信号处理参数可以是二进制变量,通过二进制变量,可以打开或者关闭相应的功能。在更复杂的情况下,通过标量浮点数、二进制或者连续可变的矢量或者多维阵列等形成助听器参数。这种信号处理参数的一个示例是用于信号处理单元的多个频带的一组放大因子,其定义听力设备的与频率有关的增益。

14.在借助听力系统执行的方法的过程中,听力设备的至少一个输入转换器接收来自听力设备的环境的声音信号。在信号处理步骤中修改接收到的声音信号(输入音频信号),以便辅助用户的听力。借助听力设备的输出转换器将修改后的声音信号输出。

15.根据方法,在分析步骤中,通过对接收到的声音信号进行分析来识别语音区间,在语音区间中,接收到的声音信号包含与用户不同的说话人(说出)的语音。

16.这里以及下面,一般地将包含说出的语音的接收到的声音信号的在时间上有限的片段称为语音区间(speech interval)。在此,将包含用户本身的语音的语音区间称为“自身语音区间”(own speech intervals)。与此区分,将与语言类型(language)无关地(也即与说话人是说英语、德语、还是说法语等无关地)包含与用户不同的至少一个说话人的语音的语音区间,称为“他人语音区间”(foreign speech intervals)。

17.为了避免语言上的不清楚,下面仅将与用户不同的人称为“说话人”(talker)。也就是说,这里以及下面,即使在用户说话时,用户本身也不视为“说话人”。

18.根据本发明,在分析步骤中,通过对识别出的他人语音区间中的接收到的声音信号进行分析,来辨别不同的说话人。在此,在如下意义上使用词语“辨别”,即,以能够再次识别的方式区分辨别出的说话人中的每一个与其他说话人。在此,在分析步骤中,将每一个识别出的他人语音区间与在该他人语音区间中说话的说话人相关联。优选将同时说话的人的信号部分(例如用户和至少一个说话人的信号部分或者多个说话人的信号部分)通过信号

处理技术彼此分离,并且以彼此分离的方式进行处理。在此,自身语音区间和他人语音区间或者不同的说话人的他人语音区间可能在时间上重叠。在本发明的替换实施方案中,即使接收到的声音信号的时间片段包含多个人的语音部分,也总是仅将这些时间片段与参与的说话人中的一个相关联。

19.根据本发明,在交互分类的过程中,对于每一个识别出的他人语音区间,根据相关联的说话人是否与用户处于直接交流关系,来对该相关联的说话人进行分类。下面将与用户处于直接交流关系的说话人称为“主要说话人”(main talker)。下面将不与用户处于直接交流关系的说话人称为“次要说话人”(secondary talker)。这里以及下面,将说话人和用户之间通过说出的语音至少尝试的(有意的或者无意的)信息传输称为“交流”。在此,当直接(在不通过另外的人或者介质进行中介的情况下)在说话人和用户之间传输信息时,给出直接交流关系。在此,特别是直接交流关系的四种情况与当前的方法相关,即,

20.‑

第一种即用户和说话人交替地彼此说话的情况,

21.‑

第二种即说话人直接与用户交谈并且用户有意地倾听说话人的情况,

22.‑

第三种即说话人直接与用户交谈、但是用户没有有意地倾听说话人的情况(这尤其是包括用户完全没有注意到说话人以及其与用户的交流的情况),以及

23.第四种即说话人不直接与说话人交谈、但是用户有意地倾听说话人的情况。

24.相反,当说话人不直接与用户交谈,并且用户也没有有意地倾听说话人时,不存在直接交流关系。

25.在多说话人环境中,可以将多个说话人的每一个分类为主要说话人或者次要说话人。因此,可以同时给出多个主要说话人和/或多个次要说话人。此外,以时间分辨的方式进行交互分类。因此,辨别出的说话人可以根据其与用户当前的交流关系,更换其作为主要说话人或者次要说话人的状态。当在说话人和用户之间出现直接交流关系时,迄今为止被分类为次要说话人的说话人相应地变为主要说话人。同样,当说话人和用户之间的直接交流关系结束时(例如当说话人和用户分别持续转向至其它对话者时),迄今为止被分类为主要说话人的说话人变为次要说话人。

26.根据这种交互分类(即根据与识别出的他人语音区间相关联的说话人被分类为主要说话人、还是次要说话人),在信号处理步骤中,特别是使用信号处理参数的不同的设置,以不同的方式修改识别出的他人语音区间。例如,与应用于与次要说话人相关联的他人语音区间相比,将与方向有关的衰减(波束成形)以更大的程度应用于与被辨别为主要说话人的说话人相关联的他人语音区间。换言之,优选使波束成形器的定向波瓣(richtkeule)特别显著地指向被辨别为主要说话人的说话人,而优选对次要说话人的信号部分进行衰减,或者以较小的方向效果或者在没有方向效果的情况下,对次要说话人的信号部分进行处理。

27.通过将辨别出的说话人分类为主要说话人和次要说话人,以及通过根据这种(交互)分类对他人语音区间进行不同的信号处理,使得能够特别是突出接收到的声音信号中的返回到主要说话人的部分,因此使得用户能够更好或者更简单地感知接收到的声音信号中的返回到主要说话人的部分。

28.在所述方法的一个有利的实施方式中,交互分类基于对辨别出的说话人或者每一个辨别出的说话人相对于用户、特别是相对于其头部朝向的空间朝向的分析。在此,在分析

步骤中,对于至少一个辨别出的说话人(优选对于每一个辨别出的说话人),检测该说话人相对于用户的头部的空间朝向,并且可选地检测该说话人相对于用户的头部的距离,并且在交互分类中考虑该空间朝向以及可选地该距离。例如,在此,将如下发现评估为说话人可以被分类为主要说话人的标志,即,用户特别频繁地和/或长时间地转向辨别出的说话人,从而该说话人相对于用户的头部主要位于正面。相反,往往将相对于用户的头部总是或者至少主要位于侧面或者后方的说话人,分类为次要说话人。

29.如果在交互分类中还考虑辨别出的说话人的距离,那么将处于特定距离范围内的说话人的距离,评估为该说话人是主要说话人的标志。相反,以更高的概率将相对于用户的头部处于相对大的距离的说话人,分类为次要说话人。

30.作为空间朝向的附加或者替换,对于交互分类,优选还考虑他人语音区间和自身语音区间彼此交替(轮换(turn

‑

taking))的顺序。在此,在分析步骤中,还识别用户说话的自身语音区间。对于至少一个(优选对于每一个)辨别出的说话人,检测并且在交互分类中考虑相关联的他人语音区间和识别出的自身语音区间的时间顺序。往往将如下的说话人分类为主要说话人,该说话人的相关联的他人语音部分与自身语音部分,以没有重叠的方式或者以仅具有相对小的重叠以及相对小的中间语音停顿的方式交替,因为将这种轮换评估为说话人与用户彼此正在交谈的标志。相反,将与自身语音区间在时间上不相关的他人语音区间(例如其与自身语音区间平均具有大的重叠),评估为次要说话人的他人语音区间。

31.此外,可选地,还对(与用户不同的)两个说话人之间的轮换进行分析,并且针对交互分类考虑该轮换。在此,将以彼此没有重叠的方式或者以仅具有小的重叠的方式在时间上相关地交替的不同的说话人的他人语音区间,评估为如下的标志,即,与这些他人语音区间相关联的说话人彼此交谈,因此在没有用户被动或者主动参与的其它标志的情况下,可以将与这些他人语音区间相关联的说话人分类为次要说话人。

32.又附加地或者替换地,在本发明的优选实施方案中,基于接收到的声音信号的音量和/或信噪比进行交互分类。在此,在分析步骤中,对于每一个识别出的他人语音区间,确定并且在交互分类中考虑平均音量(水平)和/或信噪比。在此,往往将具有预先给定的范围内的音量或者相对好的信噪比的他人语音区间与主要说话人相关联,而将他人语音区间期间的相对小的音量或者小的信噪比,评估为相关联的说话人是次要说话人的标志。在一个有利的实施方式中,在交互分类中,对说话人的空间分布随着时间的改变(变化的说话人位置或者变化的说话人数量)进行分析。

33.又附加地或者替换地,在交互分类中,优选考虑他人语音区间期间的用户的生理反应。在此,特别是借助集成在听力系统中或者外部的至少一个生物传感器,例如心率监测器、皮肤电阻测量设备、皮肤温度计或者eeg传感器,来确定生理反应,即检测到的生理测量参量(例如心跳(脉搏速率)、皮肤电阻、身体温度、耳肌的状态、眼位和/或大脑活动)随着时间的改变。在此,将他人语音区间期间的用户的明显的生理反应,即检测到的生理测量参量的相对大的改变,评估为与该他人语音区间相关联的说话人是主要说话人的标志。相反,往往将如下说话人分类为次要说话人,对该说话人的他人语音区间,用户没有明显的生理反应。

34.此外,对于交互分类,还有利地分析并且使用行为模式,例如头部和躯干运动的模式的改变、在空间中的运动(接近或者远离其他说话人)、说话方式(特别是强度、音调、说话

速率/每时间单位的字数)或者说话时间的改变、坐姿的改变、理解问题、对话伙伴的选择等。例如,可以针对用户在基于距离或者方向分析确定的潜在的主要说话人之内对特定其他说话人的选择,对用户的行为进行分析。例如将在(借助较大程度的头部运动识别出的)用户不太强地固定其他说话人期间,与附近说话人的过度频繁的交互或者(借助小程度的头部运动或者没有头部运动识别出的)特定说话人的固定,评估为不一样好地感知到不同的主要说话人的指示。

35.优选在交互分类中考虑前面描述的标准(说话人的空间分布、轮换、语音贡献的音量和/或信噪比以及用户的生理反应)以及可选地一个或多个另外的标准中的多个的组合。在这种情况下,优选基于对多个标准的同时发生的检查(其中,例如,当同时满足多个标志时,将说话人分类为主要说话人),或者基于多个单独的标准的满足或者不满足的加权考虑,来进行交互分类。

36.在本发明的优选实施方式中,在信号处理步骤中对主要说话人和次要说话人的识别出的他人语音区间的不同的修改表现为,

37.‑

与被分类为次要说话人的说话人或者每一个被分类为次要说话人的说话人的他人语音区间相比,以更大的程度对被分类为主要说话人的说话人或者每一个被分类为主要说话人的说话人的他人语音区间进行放大,

38.‑

与被分类为次要说话人的说话人或者每一个被分类为次要说话人的说话人的他人语音区间相比,以更弱的程度对被分类为主要说话人的说话人或者每一个被分类为主要说话人的说话人的他人语音区间进行动态压缩(特别是在不进行压缩的情况下进行处理),

39.‑

与被分类为次要说话人的说话人或者每一个被分类为次要说话人的说话人的他人语音区间相比,对被分类为主要说话人的说话人或者每一个被分类为主要说话人的说话人的他人语音区间进行更小的干扰噪声减小(active noise cancelling(主动降噪)),和/或

40.‑

与被分类为次要说话人的说话人或者每一个被分类为次要说话人的说话人的他人语音区间相比,以更强的程度对被分类为主要说话人的说话人或者每一个被分类为主要说话人的说话人的他人语音区间进行与方向有关的衰减(波束成形);在此,波束成形算法的定向波瓣特别是指向主要说话人。

41.在本发明的适宜的实施方案中,对主要和次要说话人的声音部分的处理的不同是固定地(不可改变地)预先给定的。

42.在本发明的一个优选变形方案中,相反地,根据交流质量来改变该不同。在此,针对被分类为主要说话人的说话人或者每一个被分类为主要说话人的说话人,确定交流质量的度量(即特征参量),其表征该主要说话人和用户之间的信息传输的成功,和/或表征与这种交流相关联的用户的倾听努力。当用户在倾听努力没有明显增加的情况下检测到由被分类为主要说话人的说话人传输的信息时,所提到的交流质量的度量(也简称为:“质量度量”/“quality measure”)例如具有相对高的值;相反,当用户在该主要说话人的他人语音区间期间显示增加的倾听努力,用户明显不理解该主要说话人传输的信息,或者用户完全没注意到该主要说话人时,所提到的交流质量的度量具有相对小的值。

43.质量度量优选是可以取在预先给定的两个边界之间可变的值的连续可变的参量、

例如浮点数。作为其替换,在本发明的简单的实施方案中,质量度量也可以是二进制参量。在此,在前面提到的情况中的每一种中,在信号处理步骤中,根据所提到的质量度量,对与该主要说话人相关联的他人语音区间进行修改。

44.在确定质量度量时,优选使用与用于交互分类的标准相同或者类似的标准。因此,优选

45.‑

根据主要说话人相对于用户的头部的空间朝向和/或距离,

46.‑

根据与主要说话人相关联的他人语音区间、识别出的自身语音区间的时间顺序(轮换),

47.‑

根据与主要说话人相关联的他人语音区间期间的用户的生理反应,

48.‑

根据主要说话人的声音部分的音量,和/或

49.‑

根据如前面所描述的对行为模式的评估,

50.来确定质量度量。将用户固定主要说话人(即用户不同寻常地强烈地关注主要说话人)、用户和主要说话人之间的不同寻常地小的距离、表征不同寻常地高的倾听努力或者沮丧的用户的生理反应以及主要说话人的声音的音量增大,评估为很差的交流质量的标志。

51.附加地或者替换地,在本发明的一个有利的实施方式中,对于至少一个自身语音区间,确定用户的声音的频谱特性、特别是基频(pitch(音高)),和/或对于与主要说话人相关联的至少一个他人语音区间,确定主要说话人的声音的频谱特性。在这些情况下,(仅或者至少也)根据用户的声音的频谱特性,或者根据主要说话人的声音的频谱特性,来确定质量度量。在此,例如,将用户或者主要说话人的声音的相对于正常值增大的基频,评估为很差的交流质量的标志。本发明的这种变形方案基于如下认识,即,在具有很差的交流质量的情况下,用户或者其他说话人一般倾向于提高声音。

52.又附加地或者替换地,优选对于至少一个自身或者他人语音区间,确定接收到的声音信号的音量(特别是用户或者主要说话人自己的声音的音量),并且在确定质量度量时考虑该音量。本发明的这种变形方案基于如下经验,即,人(由此特别是听力系统的用户以及与其交流的主要说话人也)倾向于在具有很差的交流质量的情况下更大声地说话。

53.又附加地或者替换地,优选对于至少一个自身语音区间,确定用户的语音节奏或者说话速率(语速),和/或对于与主要说话人相关联的至少一个他人语音区间,确定主要说话人的语音节奏。在此,在确定质量度量时考虑用户或者主要说话人的语音节奏。本发明的这种变形方案基于如下知识,即,在具有很差的交流质量的情况下,人(由此特别是听力系统的用户以及与其交流的主要说话人也)倾向于以与正常情况相比改变的语音节奏说话。因此,很差的交流质量例如经常表现为放慢的语音节奏,因为用户或者其他说话人尝试通过缓慢的说话,来实现对交流伙伴的更好的理解。但是另一方面,作为用户或者其他说话人不满的结果,具有很差的交流质量的情况也可能与不同寻常地加速的语音节奏相关联。因此,将用户或者主要说话人的不同寻常地提高或者降低的语音节奏,评估为很差的交流质量的标志。

54.语音分析单元优选基于对前面描述的标志的加权分析来计算质量度量。作为其替换,如果同时满足上面提到的标志中的多个,那么语音分析单元将质量度量设置为指示很差的交流质量的值。

55.一般地说,根据本发明的听力系统被配置为用于自动执行前面描述的根据本发明的方法。也即,听力系统被配置为用于,借助至少一个听力设备的至少一个输入转换器,接收来自听力设备的环境的声音信号,在信号处理步骤中,修改接收到的声音信号,以辅助用户的听力,并且借助听力设备的输出转换器,输出修改后的声音信号。此外,听力系统被配置为用于,在分析步骤中识别他人语音区间,在识别出的他人语音区间中辨别不同的说话人,并且将每一个他人语音区间与在该他人语音区间中说话的说话人相关联。最后,听力系统还被配置为用于,对于每一个识别出的他人语音区间,在交互分类的过程中,将相关联的说话人分类为主要说话人或者次要说话人,并且在信号处理步骤中,根据交互分类(也即根据相关联的说话人被分类为了主要说话人、还是次要说话人),以不同的方式对识别出的他人语音区间进行修改。

56.用于自动执行根据本发明的方法的听力系统的这种配置具有程序技术性质和/或电路技术性质。也即,根据本发明的听力系统包括程序技术装置(软件)和/或电路技术装置(例如asic形式的硬件),其在听力系统运行时自动执行根据本发明的方法。在此,用于执行所述方法的程序技术装置或者电路技术装置,可以仅布置在听力系统的听力设备(或者两个听力设备)中。替换地,用于执行所述方法的程序技术装置或者电路技术装置,分布在听力系统的听力设备或者助听器上,以及至少分布在听力系统的另一个设备或者软件部件上。例如,用于执行所述方法的程序技术装置,分布在听力系统的至少一个听力设备上,以及分布在安装在外部电子设备(特别是智能电话)上的控制程序上。

57.前面描述的根据本发明的方法的实施方式对应于根据本发明的听力系统的相应的实施方式。前面关于根据本发明的方法的描述相应地可以转用于根据本发明的听力系统,反之亦然。

58.在优选实施方式中,听力系统特别是被配置为用于,在分析步骤中,

59.‑

对于至少一个(优选对于每一个)辨别出的说话人,检测并且在交互分类中考虑该说话人相对于用户的头部的空间朝向(以及可选地距离),

60.‑

还识别自身语音区间,对于至少一个(优选对于每一个)辨别出的说话人,检测并且在交互分类中考虑相关联的他人语音区间和识别出的自身语音区间的时间顺序(轮换),

61.‑

对于每一个识别出的他人语音区间,确定并且在交互分类中考虑平均音量和/或信噪比,和/或

62.‑

对于每一个识别出的他人语音区间,检测并且在交互分类中考虑用户的生理反应。

63.在另外的优选实施方式中,听力系统特别是被配置为用于,在信号处理步骤中,

64.‑

与被分类为次要说话人的说话人或者每一个被分类为次要说话人的说话人的他人语音区间相比,以更大的程度对被分类为主要说话人的说话人或者每一个被分类为主要说话人的说话人的他人语音区间进行放大,

65.‑

与被分类为次要说话人的说话人或者每一个被分类为次要说话人的说话人的他人语音区间相比,以更小的程度对被分类为主要说话人的说话人或者每一个被分类为主要说话人的说话人的他人语音区间进行动态压缩(特别是根本不进行压缩),

66.‑

与被分类为次要说话人的说话人或者每一个被分类为次要说话人的说话人的他人语音区间相比,对被分类为主要说话人的说话人或者每一个被分类为主要说话人的说话

人的他人语音区间进行更小的噪声减小(active noise cancelling(主动降噪))和/或反馈抑制(active feedback cancelling(主动反馈消除)),和/或

67.‑

与被分类为次要说话人的说话人或者每一个被分类为次要说话人的说话人的他人语音区间相比,以更强的程度对被分类为主要说话人的说话人或者每一个被分类为主要说话人的说话人的他人语音区间进行与方向有关的衰减(波束成形)。

68.在另外的优选实施方式中,听力系统特别是被配置为用于,对于被分类为主要说话人的说话人或者每一个被分类为主要说话人的说话人,检测交流质量的度量(质量度量),并且根据该质量度量,对与该主要说话人相关联的他人语音区间进行修改。

69.在此,听力系统特别是被配置为用于,以前面描述的方式,

70.‑

根据主要说话人相对于用户的头部的空间朝向(和/或距离),

71.‑

根据与主要说话人相关联的他人语音区间和识别出的自身语音区间的时间顺序(轮换),

72.‑

根据与主要说话人相关联的他人语音区间期间的用户的生理反应,

73.‑

根据用户和/或主要说话人的声音的频谱特性、特别是基频,

74.‑

根据自身语音区间和/或他人语音区间的音量(特别是根据用户自己的的声音或者主要说话人的声音的音量),

75.‑

根据用户和/或主要说话人的语音节奏(语速),和/或

76.‑

根据对前面描述的行为模式的评估,

77.来确定质量度量。

附图说明

78.下面,根据附图进一步说明本发明的实施例。其中:

79.图1以示意图示出了可佩戴在用户耳朵后面的助听器形式的听力系统,该听力系统由一个听力设备构成,

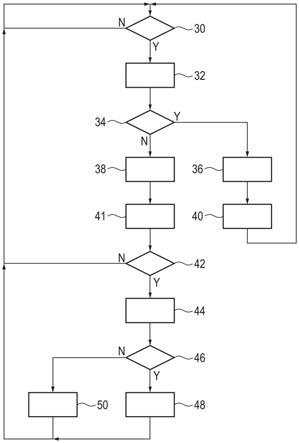

80.图2以流程图示出了用于运行图1中的听力系统的方法,

81.图3以流程图示出了所述方法的一个替换实施方式,以及

82.图4以根据图1的图示示出了听力系统的一个替换实施方式,其中,听力系统包括可佩戴在耳朵后面的助听器形式的听力设备以及在智能电话中实现的控制程序。

83.在所有附图中,相同的部分和参量始终设置有相同的附图标记。

具体实施方式

84.图1示出了听力系统2,其具有一个助听器4,即被配置为用于辅助听力受损的用户的听力的一个听力设备。在这里示出的示例中,助听器4是可佩戴在用户耳朵后面的bte助听器。

85.可选地,在本发明的另一个实施方式中,听力系统2包括未具体地示出的用于供应用户的第二只耳朵的第二助听器。

86.助听器4在壳体5内部包括作为输入转换器的至少一个麦克风6(在所示出的示例中为两个麦克风)以及作为输出转换器的听筒8(receiver(接收器))。此外,助听器4包括电池10和信号处理器12形式的信号处理单元。优选信号处理器12包括可编程的子单元(例如

微处理器)和不可编程的子单元(例如asic)。信号处理器12包括(声音识别)单元14和(语音分析)单元16。附加地,信号处理器12可选地具有(生理分析)单元18,其评估一个或多个(同样可选的)生物传感器19的信号,例如心率监测器、皮肤电阻传感器、体温传感器和/或eeg传感器的信号。

87.优选单元14至18被构造为以能够在信号处理器12中运行的方式实现的软件部件。如在图1中示例性地示出的,生物传感器19或者每一个生物传感器19可以集成在助听器2中。但是附加地或者替换地,生理分析单元18也可以从一个或多个外部的(即布置在壳体5外部的)生物传感器获得信号。

88.信号处理器12由电池10提供供电电压u。

89.在助听器4正常运行时,麦克风6接收来自助听器4的环境的空气声。麦克风6将声音转换成(输入)音频信号i,(输入)音频信号i包含有关接收到的声音的信息。输入音频信号i在助听器4内部被馈送到信号处理器12。

90.信号处理器12相应地使用多个信号处理算法,对输入音频信号i进行处理,这些算法例如是

91.‑

与方向有关的衰减(波束成形),

92.‑

干扰噪声抑制和/或反馈抑制,

93.‑

动态压缩,以及

94.‑

基于听力图(audiogramm)数据的与频率有关的放大,

95.以便补偿用户的听力损失。这些信号处理算法、因此信号处理器12的相应的工作方式通过多个信号处理参数来确定。信号处理器12将包含有关处理后的、因此修改后的声音的信息的输出音频信号o输出到听筒8。

96.听筒8将输出声音信号o转换成修改后的空气声。该修改后的空气声经由将听筒8与壳体5的尖端22连接的声音通道20以及经由(未明确示出的)将尖端22与插入用户耳道中的耳机(ohrst

ü

ck)连接的柔性音管传输到用户耳道中。

97.声音识别单元14一般地检测输入音频信号i中的声音(即与说话人无关的说出的语音)的存在。也即声音识别单元14不区分用户的声音和其他说话人的声音,因此一般地显示语音区间,即输入音频信号i包含说出的语音的时间片段。

98.语音分析单元16评估识别出的语音区间,并且在其中确定

99.‑

说话的人相对于用户的头部的朝向,特别是方式是,语音分析单元16将输入音频信号i(波束成形器信号)中的多个不同地取向的变体中的声音部分彼此进行比较,或者语音分析单元16调节方向算法(波束成形器)的放大或者衰减最大的方向,从而使输入音频信号i中的声音部分最大,

100.‑

说话的人相对于用户的头部的距离(的估计值);为了估计该距离,语音分析单元16特别是以与说话的人的朝向随着时间的改变的平均角速度和/或幅度组合的方式来评估音量,其中,优选计算出或者以其它方式忽略基于用户的头部转动的朝向改变;在这种评估中,语音分析单元16考虑,从用户的角度来看,另一个说话人与用户的距离越小,那么该另一个说话人的朝向一般越快并且范围越大地发生改变;附加地或者替换地,语音分析单元16评估用户和/或其他说话人的语音区间中的基本频率和元音的共振峰(formant)之间的比,以估计距离;在此,语音分析单元16使用如下知识,即,前面提到的说话人的参量一般以

特征性的方式,与相对于相应的听众的距离有关地发生变化(说话的人一般根据相对于听众的距离,通常在耳语、正常说话方式和大喊之间改变其说话方式,以便于理解);此外,听力系统2优选被配置为用于,识别用户的周围环境中的进行无线通信的移动电子设备(例如智能电话、其它助听器等),确定识别出的设备各自的距离,并且使用检测到的距离值,来确定说话的人与用户的头部的距离或者确定该距离的合理性,

101.‑

输入音频信号i或者输入音频信号i中的声音部分的基频(pitch(音高)),

102.‑

说话的人的语音节奏(语速),

103.‑

输入音频信号i或者输入音频信号i中的声音部分的水平(音量),和/或

104.‑

输入音频信号i的信噪比。

105.根据上面提到的参量中的一个或多个,语音分析单元16一方面将识别出的语音区间,区分为用户说话的自身语音区间和(与用户不同的)说话人说话的他人语音区间。

106.语音分析单元16特别是借助针对该区间中的输入音频信号i的声音部分,相对于用户的头部,确定不变的前方的朝向,来识别自身语音区间。

107.附加地,为了进行自身声音识别,语音分析单元16可选地评估该声音部分的基频和/或语音节奏,并且例如将其与所存储的用户的基频或者语音节奏的参考值进行比较。

108.再一次或者替换地,语音分析单元16使用例如从us 2013/0148829 a1中或者从wo 2016/078786 a1中已知的、其它本身已知的方法,来进行自身声音(语音)识别。又附加地或者替换地,语音分析单元16使用固体声信息或者接收到的内耳声音信号,来进行自身声音识别;这基于如下知识,即,与在与环境声音对应的输入音频信号i中相比,在通过用户的身体传输的固体声中或者在用户的耳道中测量的内耳声音信号中,以明显更大的比例测量到用户自己的声音。

109.另一方面,语音分析单元16评估识别出的他人语音区间,以相对于彼此区分不同的说话人,因此将每一个他人语音区间与特定的个体的说话人相关联。

110.在此,语音分析单元16例如关于基频和/或语音节奏来评估所分析的他人语音区间。附加地,语音分析单元16优选也评估检测到的语音信号的朝向,并且必要时评估检测到的语音信号的距离,以相对于彼此区分不同的说话人。这种评估特别是利用如下事实,即,一方面,说话人关于头部并且相对于其他说话人的位置不会突然改变,另一方面,两个说话人不会同时位于同一位置。因此,语音分析单元16将恒定的或者连续改变的朝向和距离值,评估为相关的语音信号来自于同一说话人的标志。相反,语音分析单元16将两个他人语音区间的相应的声音部分的不相关地改变的朝向和距离值,评估为相关的语音信号来自于不同的说话人的标志。

111.语音分析单元16优选针对前面提到的参量(基频、语音节奏、朝向、距离)中的多个,创建具有相应的参考值的识别出的说话人的简档(profile),并且在分析每一个他人语音区间时,确定相应的参量是否与简档中的一个中的参考值兼容。如果是这种情况,那么语音分析单元16将他人语音区间与相应的简档(由此与识别出的相应的说话人)相关联。否则,语音分析单元16假定,可以将所分析的他人语音区间与新的(仍未知的)说话人相关联,并且针对该说话人创建新的简档。

112.如果在一个时间点,几个人(例如用户和至少一个另外的说话人或者与用户不同的多个说话人)同时说话,那么语音分析单元16优选(使用波束成形算法)借助空间源分离,

相对于彼此单独评估相应的声音部分。因此,在这种情况下,得到在时间上重叠的多个自身和/或他人语音区间。

113.此外,语音分析单元16记录关于自身语音区间和他人语音区间的时间长度和顺序以及相应地与他人语音区间相关联的说话人的信息。语音分析单元16根据该信息,确定与特定说话人的自身语音区间和他人语音区间之间的所谓的轮换(turn

‑

taking)相关的特征参量。将两个说话的人在谈话中的语音贡献的组织、特别是这些人的语音贡献的顺序称为“轮换”。如例如在s.a.chowdhury等人的“predicting user satisfaction from turn

‑

taking in spoken conversations”,interspeech 2016中所定义的,“轮换”的相关的参数特别地是说话的人的不间断的语音贡献(turn(轮))、重叠(overlap)、间隙(lapse)、暂停(pause)和交换(switch)。

114.语音分析单元16特别是具体地确定:

115.‑

用户的turn和/或其他说话人的turn的时间长度或者时间频率,其中,turn是相应的对话者保持沉默的、没有pause的自身或者他人语音区间;

116.‑

pause的时间长度或者时间频率,其中,pause是输入音频信号i的没有语音部分的区间,如果该区间的时间长度超过预先给定的阈值,那么该区间使用户的两个连续的turn或者其他说话人的两个连续的turn分离;可选地,相应地彼此分离地检测并且评估用户的turn之间的pause以及其他说话人或者每一个其他说话人的turn之间的pause;作为其替换,共同检测并且评估所有的pause。

117.‑

lapse的时间长度或者时间频率,其中,当输入音频信号i中的、在用户的turn和随后的其他说话人的turn之间或者在其他说话人的turn和随后的用户的turn之间没有语音部分的区间的时间长度超过预先给定的阈值时,lapse是输入音频信号i中的这种区间;可选地,相应地彼此分离地检测并且评估用户的turn与其他说话人的turn之间的lapse以及其他说话人的turn与用户的turn之间的lapse;作为其替换,共同检测并且评估所有的lapse;

118.‑

overlap的时间长度或者时间频率,其中,overlap是输入音频信号i中的、不仅用户、而且其他说话人说话的区间;优选仅当该区间的时间长度超过预先给定的阈值时,将这种区间评估为overlap;可选地,相应地彼此分离地检测并且评估用户的turn与随后的其他说话人的turn之间的overlap以及其他说话人的turn与随后的用户的turn之间的overlap;作为其替换,共同检测并且评估所有的overlap;和/或

119.‑

switch的时间频率,其中,switch是在没有overlap或者之间的pause的情况下,从用户的turn到其他说话人的turn的过渡,或者从其他说话人的turn到随后的用户的turn的过渡,特别是也即特定时间阈值内的过渡;可选地,彼此分离地检测并且评估用户的turn与其他说话人的turn之间的switch以及其他说话人的turn与随后的用户的turn之间的switch;作为其替换,共同检测和评估所有的switch。

120.针对每一个识别出的说话人单独确定与“轮换”相关的特征参量。因此,语音分析单元16针对每一个识别出的说话人,单独确定该个体的说话人的他人语音区间与自身语音区间具有什么样的时间顺序(因此该说话人如何与用户互动)。

121.语音分析单元16根据前面描述的分析进行如下的交互分类,在该交互分类的过程中,如前面所描述的,将每一个说话人分类为“主要说话人”或者“次要说话人”。

122.语音分析单元16优选以比较分析,来评估前面描述的特征参量中的多个、特别是与“轮换”相关的一个或多个特征参量、相应的说话人相对于用户的头部的朝向和距离、相应的说话人的声音部分的水平以及可选地还有用户的声音部分的水平和/或说话人的声音部分的基频以及可选地还有用户的声音部分的基频。

123.语音分析单元16将如下发现,评估为特定说话人是主要说话人的标志:

124.‑

如下发现,即,用户在与该说话人相关联的他人语音区间期间主要关注该说话人,从而该说话人的声音部分主要来自前方;将用户关注说话人评估为用户有意地倾听说话人的标志,无论说话人是否直接向用户说话;

125.‑

如下发现,即,用户和该说话人主要在时间上同步地(特别是交替地)说话,从而该说话人的自身语音区间和他人语音区间处于在时间上相关的顺序;语音分析单元16特别是借助用户与该说话人之间的交流中的switch的相对高的频率和/或overlap的相对低的频率和/或lapse的相对低的频率,识别出这一点;例如,语音分析单元16为此将switch、overlap和lapse的频率分别与相应的阈值进行比较;一方面,用户和说话人的语音贡献的在时间上相关的顺序是说话人和用户之间的相互交谈的标记;但是语音贡献的相关的顺序也可以识别出即使用户甚至可能没有注意到、说话人也想要与用户接触的交流情形,或者用户中断了自己的说话贡献、以倾听说话人的交流情形;

126.‑

如下发现,即,该说话人(绝对地或者与其他说话人相比)相对于用户的头部位于特定的距离范围内;这基于如下知识,即,对话者相对于彼此经常具有被限制为相对近的(取决于用户和说话人的文化区域、环境水平、对话位置和群组大小;例如80厘米和2米之间的)距离,同时对话者之间的更近或者更远的距离很少出现。语音分析单元16为此将说话人相对于用户的头部的距离与所存储的阈值进行比较;这些阈值可以是固定地预先给定的,或者可以根据用户发生改变;可选地,同样将用户与说话人之间的距离的减小,特别是当该减小与用户和/或该说话人的语音贡献在时间上相关时,评估为直接交流关系的标志;以及

127.‑

如下发现,即,该说话人的声音部分位于预先确定的水平范围内;这基于如下知识,即,对话者通常调整自己的声音的音量,使得自己的声音根据环境条件可以相应地良好地被其他对话者听到,并且在此既不太小声,也不会太吵;在此,可选地,根据干扰噪声水平来改变该预先确定的水平范围;可选地,同样将说话人的水平的升高,评估为说话人尝试与用户进行接触的标志。

128.可选地,在进行交互分类时,语音分析单元16还附加地评估生理分析单元18的信号。在此,语音分析单元16将如下发现评估为识别出的特定说话人是主要说话人的标志,即,由生理分析单元18评估的生物传感器19的信号(或者当助听器2访问多个生物传感器的信号时,这些信号中的至少一个)显示与该说话人的他人语音区间在时间上相关的改变;在此,与特定说话人的他人语音区间相关的生理反应的确定,可以推断出用户的提高的注意力,因此推断出用户有意的倾听。

129.在此,在交互分类的过程中,特别是当对于识别出的特定说话人,满足前面描述的标志中的多个(例如至少两个或者至少三个)时,语音分析单元16将该说话人分类为主要说话人。否则,将该说话人分类为次要说话人。在此,这种分类是随着时间可变的。在此,被分类为主要说话人的说话人可以被重新分类为次要说话人,以及相反。

130.根据识别出的特定说话人被分类为了主要说话人、还是次要说话人,信号处理器

12对输入音频信号i中的该说话人的声音部分进行不同的处理。在此,与相关联的说话人被分类为了次要说话人的他人语音区间相比,当与他人语音区间相关联的说话人被分类为了主要说话人时,对该语音区间

131.‑

以更大的放大因子进行放大,

132.‑

以更小的程度进行动态压缩,

133.‑

以更小的程度进行干扰噪声或者反馈抑制,和/或

134.‑

以更强的程度进行与方向有关的衰减。

135.如果输入音频信号i在特定时间点包含多个说话人的声音部分,那么信号处理器12针对被分类为主要说话人的说话人或者每一个被分类为主要说话人的说话人,以及被分类为次要说话人的说话人或者每一个被分类为次要说话人的说话人,以相应的方式对通过源分离而分离的该多个说话人的声音部分进行不同的处理。

136.在图2中示例性地示出了由听力系统2执行的方法的具体流程。据此,声音识别单元14在助听器4的通常的运行中,在步骤30中检查输入音频信号i是否包含说出的语音。如果是这种情况(y),那么声音识别单元14促使信号处理器12执行随后的步骤32。否则(n),声音识别单元14重复步骤30。由此,声音识别单元14将输入音频信号i的语音区间与没有声音部分的区间分开。在此,仅在识别出的语音区间中执行所述方法的步骤32和该步骤后面的其它步骤。

137.在步骤32中,信号处理器12执行源分离。在此,信号处理器12通过应用波束成形算法,来识别输入音频信号i中的在空间上不同的噪声源(特别是说话的人),并且将相应地与这些噪声源对应的信号部分彼此分离,以便使得能够对这些信号部分进行不同的处理。在通常的情况下,输入音频信号i仅包含一个说话的人(即用户或者与用户不同的说话人)的声音部分。

138.在随后的步骤34中,语音分析单元16检查在输入音频信号i中识别出的声音部分(或者可能在输入音频信号i中识别出的声音部分中的一个)是否包含用户自己的声音。如果是这种情况(y),那么语音分析单元16将随后的步骤36应用于该声音部分。

139.否则(n),即,语音分析单元16将步骤38应用于包含与用户不同的说话人的声音的输入音频信号i的声音部分。以这种方式,语音分析单元16彼此分离地分析输入音频信号i中的自身语音区间和他人语音区间。

140.为了确定与“轮换”相关的特征参量,在步骤36中,语音分析单元16针对识别出的自身语音区间或者每一个识别出的自身语音区间,确定开始和结束时间点。

141.在随后的步骤40中,语音分析单元16针对识别出的自身语音区间,促使信号处理器12设置针对用户自己的声音优化的信号处理参数。然后,信号处理器12在方法执行中返回到步骤30。

142.对于每一个识别出的他人语音区间,在步骤38中,语音分析单元16以如下方式辨别相应的说话人,即,语音分析单元16以前面描述的方式确定输入音频信号i中的声音部分的特性(朝向、距离、基频、语音节奏),并且将其与所存储的说话人简档的相应的参考值进行比较。在此,如果可能,语音分析单元16将相应的他人语音区间与兼容的说话人简档相关联,或者否则建立新的说话人简档。在此,语音分析单元16还检查哪些说话人在用户当前的听力情形中是主动的。语音分析单元16删除(例如根据说话人的群组大小和听力环境)在特

定时间段内无法与他人语音区间相关联的说话人简档。

143.对于辨别出的说话人中的每一个,语音分析单元16也在步骤41中检测相应地相关联的他人语音区间的开始和结束时间点,以便确定与“轮换”相关的特征参量。

144.在步骤42中,语音分析单元16检查是否多于一个的说话人在用户当前的听力情形中是主动的,即,是否存在多于一个的存储的说话人简档,或者是否多于一个的存储的说话人简档是主动的。

145.在这种情况下(y),语音分析单元16执行随后的步骤44。否则(n),信号处理器12跳转回步骤30。因此,仅在多说话人环境中执行进一步的方法。

146.在步骤44中,语音分析单元16根据在步骤36和41中记录的自身和他人语音区间的开始和结束时间点,确定与用户和每一个辨别出的说话人之间的轮换相关的特征参量(turn、pause、lapse、overlap、switch)以及其长度或者时间频率。

147.在随后的步骤46中,语音分析单元16执行前面描述的交互分类。在此,语音分析单元16判断是否满足前面提到的用户和与当前检查的他人语音区间相关联的说话人之间的直接交流关系的标志中的多个。

148.如果是这种情况(y),那么语音分析单元16将该说话人分类为主要说话人,并且将该分类记录在相关的说话人简档中。然后,在步骤48中,语音分析单元16针对相关的他人语音区间,促使设置针对对主要说话人的声音部分的处理优化的助听器参数,特别是

149.‑

输入音频信号i的相对大的放大,

150.‑

相对小的动态的压缩,以及

151.‑

输入音频信号i的相对强的与方向有关的衰减(波束成形),其中,波束成形算法的定向波瓣特别是与该主要说话人相对于用户的头部的朝向对应地定向。

152.否则(n),语音分析单元16将该说话人分类为次要说话人,并且同样将该分类记录在相关的说话人简档中。然后,在步骤50中,语音分析单元16针对相关的他人语音区间,促使设置针对对次要说话人的声音部分的处理优化的助听器参数,特别是

153.‑

输入音频信号i的相对小的放大,

154.‑

相对强的动态的压缩,以及

155.‑

相对小的与方向有关的衰减。

156.在这两种情况下,即不仅在步骤48之后,而且在步骤50之后,信号处理器12随后返回到步骤30。

157.在图3中示出了图2中的方法的一个变形方案。根据图3的方法在很大程度上对应于前面根据图2描述的方法。根据图3的方法特别是包括前面描述的步骤30至50。但是根据图3的方法附加地包括两个附加的步骤52和54。

158.如果在步骤46中将与当前的他人语音区间相关联的说话人分类为了主要说话人,那么在交互分类(步骤46)之后执行步骤52。

159.在这种情况下,语音分析单元16根据与轮换相关的特征参量,根据先前的自身语音区间中的用户自己的声音的音量和基频以及当前的他人语音区间中的说话人的声音的音量和基频,以及可选地根据生理分析单元18所评估的生物传感器19或者每一个生物传感器19的信号,检查是否存在困难的(即与增加的倾听努力和/或与用户的沮丧相关联的)听力情形。

160.如果是这种情况(y),那么在步骤54中,语音分析单元16促使调整在步骤48中要设置的信息处理参数。例如,语音分析单元16增大要应用于对主要说话人的声音部分的处理的放大因子,或者减小在这种情况下要应用的动态压缩。

161.否则(n),也即当在步骤52中进行的检查没有得到针对困难的听力情形的指示时,在方法执行中跳过步骤54。

162.因此,通过步骤52和54,在一种调节回路中根据需要调整信号处理参数,以使处于困难的听力情形中的用户对一个或多个直接交流伙伴(主要说话人)的理解变得容易。当困难的听力情形结束,因此在步骤52中进行的检查在特定时段内产生否定的结果时,将依次取消在步骤54中进行的对信号处理参数的调整。

163.图4示出了听力系统2的另一个实施方式,其中,除了助听器4(或者用于供应用户的两只耳朵的两个这种类型的助听器)之外,听力系统2还包括控制软件。下面将该控制软件称为听力app(应用)60。在图4所示的示例中,听力app 60安装在智能电话62上。在此,智能电话62本身不是听力系统2的一部分。更确切地说,听力app 60仅作为存储空间和计算能力的资源,来使用智能电话62。

164.在听力系统2运行时,助听器4和听力app 62通过无线的数据传输连接64交换数据。数据传输连接64例如基于蓝牙标准。在此,听力app 62访问智能电话62的蓝牙收发器,以便从助听器4接收数据并且向助听器4发送数据。助听器4本身包括蓝牙收发器,用于向听力app 60发送数据,并且从该app接收数据。

165.在根据图4的实施方案中,不在信号处理器12中,而是相反在听力app 60中,实现执行根据图2或者图3的方法所需的软件部件的一部分。例如,在根据图4的实施方式中,在听力app 60中实现语音分析单元16或者其一部分。

166.根据前面描述的实施例,本发明变得特别清楚,虽然如此,本发明不限于这些实施例。相反,本领域技术人员可以从权利要求书和前面的描述中得到本发明的其它实施方式。

167.附图标记列表

[0168]2ꢀꢀꢀꢀꢀ

听力系统

[0169]4ꢀꢀꢀꢀꢀ

助听器

[0170]5ꢀꢀꢀꢀꢀ

壳体

[0171]6ꢀꢀꢀꢀꢀ

麦克风

[0172]8ꢀꢀꢀꢀꢀ

听筒

[0173]

10

ꢀꢀꢀꢀ

电池

[0174]

12

ꢀꢀꢀꢀ

信号处理器

[0175]

14

ꢀꢀꢀꢀ

(声音识别)单元

[0176]

16

ꢀꢀꢀꢀ

(语音分析)单元

[0177]

18

ꢀꢀꢀꢀ

生理分析单元

[0178]

19

ꢀꢀꢀꢀ

生物传感器

[0179]

20

ꢀꢀꢀꢀ

声音通道

[0180]

22

ꢀꢀꢀꢀ

尖端

[0181]

30

ꢀꢀꢀꢀ

步骤

[0182]

32

ꢀꢀꢀꢀ

步骤

[0183]

34

ꢀꢀꢀꢀ

步骤

[0184]

36

ꢀꢀꢀꢀ

步骤

[0185]

38

ꢀꢀꢀꢀ

步骤

[0186]

40

ꢀꢀꢀꢀ

步骤

[0187]

41

ꢀꢀꢀꢀ

步骤

[0188]

42

ꢀꢀꢀꢀ

步骤

[0189]

44

ꢀꢀꢀꢀ

步骤

[0190]

46

ꢀꢀꢀꢀ

步骤

[0191]

48

ꢀꢀꢀꢀ

步骤

[0192]

50

ꢀꢀꢀꢀ

步骤

[0193]

52

ꢀꢀꢀꢀ

步骤

[0194]

54

ꢀꢀꢀꢀ

步骤

[0195]

60

ꢀꢀꢀꢀ

听力app

[0196]

62

ꢀꢀꢀꢀ

智能电话

[0197]

64

ꢀꢀꢀ

数据传输连接

[0198]

u

ꢀꢀꢀꢀ

供电电压

[0199]

i

ꢀꢀꢀꢀ

(输入)音频信号

[0200]

o

ꢀꢀꢀꢀ

(输出)音频信号

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1