智能交互式远程辅助视频系统

1.本发明属于视频通讯系统技术领域,涉及智能交互技术,具体是一种智能交互式远程辅助视频系统。

背景技术:

2.视频通讯逐渐成为一种非常有效的工作模式。目前,市场上现有的视频会议平台,主要是面向办公室场景下的普通会议;而日常生活中人们广泛采用的视频通话工具,功能比较单一,无法满足复杂场景下的人机交互需求,例如,对于客服或者专家远程协助现场用户维修设备的一些场景,仅仅依靠语音和客户的视频画面,客服或者专家往往无法有效地表达明确的指令,现场用户仅仅依靠语音也不便于获取得到准确的信息,影响了双方的交流效果,降低了产品的用户体验。

3.眼睛具有传递信息的重要功能,人的眼睛和视线包含了丰富的情感和意图信息。视线追踪主要是以眼睛图像或人脸图像作为处理对象,进而计算人眼的视线方向或注视点位置,在人机交互、汽车安全驾驶、市场研究等领域具有重要的理论意义和应用价值。

技术实现要素:

4.本发明目的在于解决现有技术中存在的上述不足,提出一种智能交互式远程辅助视频系统,在传统视频通讯的基础上,结合云计算、大数据、人工智能以及边缘计算等技术,利用视线追踪技术和增强现实技术,开发一种以通信设备(硬件)和相关工作程序(软件)有机建立的智能交互式远程辅助视频系统,从而增强在复杂场景下进行远程辅助视频通讯的智能交互效果,提高通讯效率,丰富交互功能,优化用户体验,具有重要的工业应用价值和社会经济意义。

5.实现本发明目的的技术方案为:

6.一种智能交互式远程辅助视频系统,包括至少一个云端服务器模块、由一个现场终端和至少一个客服终端组成的边缘计算终端模块;

7.所述云端服务器模块通过互联网连接边缘计算终端模块,云端服务器模块搭载视线追踪模型用于分析客服终端的用户的注视信息,云端服务器模块还搭载了物体分割模型和语音辅助模型用于辅助分析;

8.其中,所述视线追踪模型包括两个子模型,分别是人眼视线基准模型、视线映射融合模型;所述人眼视线基准模型采用人眼图像基准数据集进行训练之后,用于根据眼睛区域图像计算眼睛注视基准方位;所述视线映射融合模型用于将眼睛注视基准方位和表征头部姿态信息的人脸关键特征点的位置坐标进行融合,计算实际场景中的人眼注视点坐标;

9.所述物体分割模型用于计算人眼注视点坐标在被注视画面中所映射对应的目标物体的轮廓信息;

10.所述语音辅助模型用于提取通话音频中的关键名词和动作指令,根据同一时间的注视点所映射对应的目标物体,将关键名词、动作指令与目标物体进行匹配,其中,关键名

词作为物体名称,动作指令用于生成相应的动画效果;

11.所述边缘计算终端模块通过互联网连接所述云端服务器模块,边缘计算终端模块用于采集终端所处环境中的音频数据和目标视野的视频画面,经过数据处理之后向云端服务器模块上传数据,并且从云端服务器模块获取数据进行信息展示;

12.其中,所述现场终端用于采集现场音频和现场视频数据并且上传到云端服务器模块;所述客服终端通过云端服务器模块接收来自现场终端的现场音频数据并实时播放,客服终端通过云端服务器模块接收来自现场终端的现场视频数据并实时显示,客服终端用于采集客服音频,客服终端利用前置摄像机捕获用户的人脸图像,所述客服终端对人脸图像数据进行实时计算处理,截取人脸图像中的眼睛区域图像,提取人脸关键特征点的位置坐标数据,所述客服终端将采集到的客服音频、处理之后得到的眼睛区域图像和人脸关键特征点的位置坐标数据上传到云端服务器模块;所述现场终端接收并处理来自云端服务器模块的数据,所述现场终端通过云端服务器模块接收来自客服终端的客服音频数据并实时播放,现场终端的显示屏在显示现场视频画面的同时,叠加展示客服终端的用户的注视点、目标物体轮廓形貌、物体名称以及客服终端的用户所表达动作指令的动画效果。

13.作为本发明的进一步改进,所述智能交互式远程辅助视频系统采用三个层级模式以满足不同场景的功能需求;模式单元包括视频通话基础模式(i)、视线追踪智能交互模式(ii)、语音辅助分析模式(iii);所述三个层级模式的功能是逐层累加的;所述视频通话基础模式(i)默认开启,在开启了视频通话基础模式(i)的基础上,用户可以选择开启视线追踪智能交互模式(ii)和语音辅助分析模式(iii),所述语音辅助分析模式(iii)要在已经开启视线追踪智能交互模式(ii)的基础之上才能开启;

14.其中,所述视频通话基础模式开启之后,即处于模式i的场景,客服终端向云端服务器模块上传的数据仅为客服音频,现场终端向云端服务器模块上传的数据包括现场音频、现场视频,客服终端从云端服务器模块获取的数据包括现场音频、现场视频,现场终端从云端服务器模块获取的数据仅为客服音频;

15.所述视频通话基础模式和视线追踪智能交互模式同时开启之后,即处于模式i+ii的场景,客服终端向云端服务器模块上传的数据包括客服音频、眼睛区域图像、人脸关键特征点的位置坐标矩阵,现场终端向云端服务器模块上传的数据包括现场音频、现场视频,客服终端从云端服务器模块获取的数据包括现场音频、现场视频,现场终端从云端服务器模块获取的数据包括客服音频、注视点坐标、轮廓数据;

16.所述视频通话基础模式和视线追踪智能交互模式以及语音辅助分析模式全部同时开启之后,即处于模式i+ii+iii的场景,客服终端向云端服务器模块上传的数据包括客服音频、眼睛区域图像、人脸关键特征点的位置坐标矩阵,现场终端向云端服务器模块上传的数据包括现场音频、现场视频,客服终端从云端服务器模块获取的数据包括现场音频、现场视频,现场终端从云端服务器模块获取的数据包括客服音频、注视点坐标、轮廓数据、物体名称、动作指令。

17.作为本发明的进一步改进,所述视线追踪模型的子模型之一的人眼视线基准模型主要包括卷积神经网络和多层全连接神经网络;所述人眼视线基准模型的训练阶段需要至少包含若干眼睛区域图像以及眼睛注视基准方位标签数据的人眼图像基准数据集;在模型的训练过程中,人眼视线基准模型的输入是眼睛区域图像,输出是用于表征眼睛注视基准

方位的坐标值,利用损失函数度量人眼视线基准模型输出的眼睛注视基准方位与人眼图像基准数据集中的眼睛注视基准方位标签之间的差异。

18.作为本发明的进一步改进,所述视线追踪模型的子模型之二的视线映射融合模型采用的主要是多层全连接神经网络,用于融合人脸关键特征点的位置坐标和眼睛注视基准方位,从而进一步分析在头部姿态影响之下从眼睛注视基准方位到人眼注视点坐标之间的非线性变换关系;所述视线映射融合模型的输入分为两项,分别是人眼视线基准模型输出的眼睛注视基准方位坐标值、人脸关键特征点的位置坐标矩阵,经过多层全连接神经网络的计算,最后输出人眼的注视点坐标;利用损失函数度量视线追踪模型子模型之二的视线映射融合模型输出的注视点坐标与注视点坐标标签之间的差异。

19.作为本发明的进一步改进,所述人眼图像基准数据集视点靶位图纸用于制作人眼视线基准模型的训练阶段所需的人眼图像基准数据集;在采集人眼图像基准数据集的图像的过程中,图像采集装置的镜头置于所述视点靶位图纸的中心位置,所述视点靶位图纸绘制若干圆圈图案作为视点靶位,每个圆圈图案包含一个数字编号和一个随机字母编号;在图像采集过程中,被采集图像人员的面部距离镜头始终保持一定距离,被采集图像人员的头部位姿保持稳定,视点靶位图纸中的数字编号依据一定规律播报,被采集图像人员根据听到的数字编号去注视对应的视点靶位,识别视点靶位中的字母编号并读出,若字母编号正确,则触发图像采集装置进行拍摄,完成一次数据采集。

20.本发明与现有技术相比,优点在于:所述智能交互式远程辅助视频系统在实现视频通讯的基础上,经过终端设备的边缘计算处理之后,传输必要数据至云端服务器模块,利用云端服务器模块的多模态特征融合的视线追踪模型、物体分割模型和语音辅助分析模型进行深度分析,以获取客服用户在观看屏幕画面时的注视信息与语音指令,最终可在现场终端显示客服用户的注视点、目标物体轮廓、物体名称、动作指令等增强现实效果,从而为现场用户带来更详细的指导信息,提升远程辅助效果;视线追踪模型分为人眼视线基准模型和视线追踪多模态融合模型两个子模型,有利于提高边缘计算终端模块和云端服务器模块之间数据传输与计算的协作效率,提升视线追踪的精度和鲁棒性;视线追踪任务需要使用大量数据,但是人工智能和机器学习的有效性并不应该以牺牲用户的隐私为代价,所述智能交互式远程辅助视频系统注重用户的隐私保护,仅使用必要的数据完成任务,并尽量在设备终端进行数据处理,经过边缘计算终端模块对人脸图像预处理之后,只需要把人脸关键特征点的位置坐标数据上传到云端服务器模块,而不是整张人脸图像数据,从而在优化数据传输效率的同时,还可以非常有效地保护用户的隐私安全。所述智能交互式远程辅助视频系统能够灵活地搭载于智能手机、平板电脑、笔记本电脑和配置摄像头的台式机电脑等多种形式的终端设备,成本较低,可实施性强,应用范围广,能够面向远程设备维护技术指导、远程授课辅助教学、远程医疗等多种应用场景,增强在复杂场景下进行远程辅助视频通讯的智能交互效果,提高通讯效率,丰富交互功能,优化用户体验,具有重要的工业应用价值和社会经济意义。

附图说明

21.本发明上述的和/或附加的方面和优点从下面结合附图对实施例的描述中将变得明显和容易理解,其中:

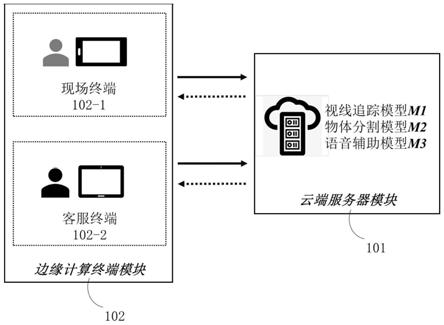

22.图1是本发明实施例的智能交互式远程辅助视频系统的整体结构示意图;

23.图2是本发明实施例的智能交互式远程辅助视频系统的不同应用模式的数据传输结构示意图;

24.图3a是本发明实施例的涉及的人眼图像基准数据集视点靶位图纸的结构示意图;

25.图3b是本发明实施例的涉及的人眼图像基准数据集视点靶位图纸的区域划分示意图;

26.图4a是本发明实施例的涉及的视线追踪模型的子模型之一的人眼视线基准模型在训练阶段的结构示意图;

27.图4b是本发明实施例的涉及的视线追踪模型的子模型之一的人眼视线基准模型在训练阶段的流程示意图;

28.图5a是本发明实施例的涉及的视线追踪模型的子模型之二的视线映射融合模型在训练阶段的结构示意图;

29.图5b是本发明实施例的涉及的视线追踪模型在训练阶段的结构示意图;

30.图5c是本发明实施例的涉及的视线追踪模型在训练阶段的流程示意图;

31.图6是本发明实施例的涉及的dlib库的人脸68个特征点示意图;

32.图7a是本发明实施例的涉及的视线追踪模型在应用阶段的结构示意图;

33.图7b是本发明实施例的涉及的视线追踪模型在应用阶段的流程示意图;

34.图8a是本发明实施例的智能交互式远程辅助视频系统的视频通话基础模式(i)的应用流程示意图;

35.图8b是本发明实施例的智能交互式远程辅助视频系统的视频通话基础模式和视线追踪智能交互模式(i+ii)的应用流程示意图;

36.图8c是本发明实施例的智能交互式远程辅助视频系统的视频通话基础模式、视线追踪智能交互模式和语音辅助分析模式(i+ii+iii)的应用流程示意图。

具体实施方式

37.下面结合具体附图和实施例对本发明作进一步说明。

38.如附图1所示,本发明提供了一种智能交互式远程辅助视频系统,该系统包括云端服务器模块101,边缘计算终端模块102;所述边缘计算终端模块102由一个现场终端102-1和至少一个客服终端102-2组成;

39.所述云端服务器模块101通过互联网连接边缘计算终端模块102,云端服务器模块101搭载视线追踪模型m1用于分析客服终端102-2的用户的注视信息,云端服务器模块101还搭载了物体分割模型m2和语音辅助模型m3用于辅助分析;

40.其中,所述视线追踪模型m1包括两个子模型,分别是人眼视线基准模型m1-1、视线映射融合模型m1-2;所述人眼视线基准模型m1-1采用人眼图像基准数据集进行训练之后,用于根据眼睛区域图像计算眼睛注视基准方位;所述视线映射融合模型m1-2用于将眼睛注视基准方位和表征头部姿态信息的人脸关键特征点的位置坐标进行融合,计算实际场景中的人眼注视点坐标;

41.所述物体分割模型m2用于计算人眼注视点坐标在被注视画面中所映射对应的目标物体的轮廓信息;首先,对被注视画面的图像进行中值滤波和锐化处理,然后,将注视点

坐标在图像中所对应区域的像素设为前景信息,使用语义分割算法进行图像前景后景分离处理,提取图像前景的边缘像素坐标作为目标物体的轮廓信息;

42.所述语音辅助模型m3采用已有的语音识别技术,将通话音频转换为文字信息,并从文字信息中提取关键名词和动作指令,根据同一时间的注视点所映射对应的目标物体,将关键名词、动作指令与目标物体进行匹配,其中,关键名词作为物体名称,动作指令用于生成相应的动画效果;

43.所述边缘计算终端模块102通过互联网连接所述云端服务器模块101,边缘计算终端模块102用于采集终端所处环境中的音频数据和目标视野的视频画面,经过数据处理之后向云端服务器模块101上传数据,并且从云端服务器模块101获取数据进行信息展示;

44.其中,所述现场终端102-1可以是智能手机、平板电脑等常见的互联网移动设备,且需要配置显示屏、后置摄像机、麦克风、扬声器等功能部件;所述客服终端102-2可以是智能手机、平板电脑、笔记本电脑以及台式机电脑等互联网移动设备或者计算机设备,且需要配置显示屏、前置摄像机、麦克风、扬声器等功能部件;所述现场终端102-1用于采集现场音频和现场视频数据并且上传到云端服务器模块101;所述客服终端102-2通过云端服务器模块101接收来自现场终端102-1的现场音频数据并实时播放,客服终端102-2通过云端服务器模块101接收来自现场终端102-1的现场视频数据并实时显示,客服终端102-2用于采集客服音频,客服终端102-2利用前置摄像机捕获用户的人脸图像,所述客服终端102-2对人脸图像数据进行实时计算处理,截取人脸图像中的眼睛区域图像,提取人脸关键特征点的位置坐标数据,所述客服终端102-2将采集到的客服音频、处理之后得到的眼睛区域图像和人脸关键特征点的位置坐标数据上传到云端服务器模块101;所述现场终端102-1接收并处理来自云端服务器模块101的数据,所述现场终端102-1通过云端服务器模块101接收来自客服终端102-2的客服音频数据并实时播放,现场终端102-1的显示屏在显示现场视频画面的同时,叠加展示客服终端102-2的用户的注视点、目标物体轮廓形貌、物体名称以及客服终端102-2的用户所表达动作指令的动画效果。

45.如附图2所示,所述智能交互式远程辅助视频系统采用三个层级模式以满足不同场景的功能需求;模式单元包括视频通话基础模式(i)、视线追踪智能交互模式(ii)、语音辅助分析模式(iii);所述三个层级模式的功能是逐层累加的;所述视频通话基础模式(i)默认开启,在开启了视频通话基础模式(i)的基础上,用户可以选择开启视线追踪智能交互模式(ii)和语音辅助分析模式(iii),所述语音辅助分析模式(iii)要在已经开启视线追踪智能交互模式(ii)的基础之上才能开启;

46.其中,所述视频通话基础模式开启之后,即处于模式i的场景,客服终端102-2向云端服务器模块101上传的数据仅为客服音频,现场终端102-1向云端服务器模块101上传的数据包括现场音频、现场视频,客服终端102-2从云端服务器模块101获取的数据包括现场音频、现场视频,现场终端102-1从云端服务器模块101获取的数据仅为客服音频;

47.所述视频通话基础模式和视线追踪智能交互模式同时开启之后,即处于模式i+ii的场景,客服终端102-2向云端服务器模块101上传的数据包括客服音频、眼睛区域图像eye-images、人脸关键特征点的位置坐标矩阵f,现场终端102-1向云端服务器模块101上传的数据包括现场音频、现场视频,客服终端102-2从云端服务器模块101获取的数据包括现场音频、现场视频,现场终端102-1从云端服务器模块101获取的数据包括客服音频、注视点

坐标(x2,y2)、轮廓数据op;

48.所述视频通话基础模式和视线追踪智能交互模式以及语音辅助分析模式全部同时开启之后,即处于模式i+ii+iii的场景,客服终端102-2向云端服务器模块101上传的数据包括客服音频、眼睛区域图像eye-images、人脸关键特征点的位置坐标矩阵f,现场终端102-1向云端服务器模块101上传的数据包括现场音频、现场视频,客服终端102-2从云端服务器模块101获取的数据包括现场音频、现场视频,现场终端102-1从云端服务器模块101获取的数据包括客服音频、注视点坐标(x2,y2)、轮廓数据op、物体名称name、动作指令action。

49.如附图3a所示,人眼图像基准数据集视点靶位图纸用于制作人眼视线基准模型m1-1的训练阶段所需的人眼图像基准数据集;在采集人眼图像基准数据集的图像的过程中,图像采集装置的镜头置于所述视点靶位图纸的中心位置,所述视点靶位图纸绘制若干圆圈图案作为视点靶位,每个圆圈图案包含一个数字编号和一个随机字母编号,数字编号是由i和j两个部分组成的一串数字;

50.以附图3a所示的视点靶位图纸中的数字编号“702”为例,第一部分i=7,第二部分j=02;

51.第一部分i=7,表示视点靶位位于径向偏离基准点的第7个径向区间,其中,所述基准点为视点靶位图纸的中心位置;

52.数字编号“ij”表示的视点靶位的径向偏离值计算公式为:

53.r(ij)=r

×i54.其中,r为第1个径向区间的径向偏离值,在图纸为a1尺寸时,一般可取r=30mm,于是,r(702)=30mm

×

7=210mm;

55.归一化公式为:

56.rr(ij)=r(ij)/(r

×

i)=i/i

57.其中,i为径向区间总数,在图纸为a1尺寸时,一般可取i=9,于是,rr(702)=7/9=0.7778;

58.第二部分j=02,表示视点靶位位于环向偏离基准线的位置编号是02号,其中,所述基准线为从基准点出发向右的水平线,数字编号“ij”表示的视点靶位的环向偏离值计算公式为:

59.s(ij)=(2π/(k

×

i))

×

(j

–

1)

60.其中,k表示第1个径向区间的视点靶位的数量,在图纸为a1尺寸时,一般可取k=6,于是,s(702)=(2π/(6

×

7))

×

(2

–

1)=0.1496;

61.归一化公式为:

62.ss(ij)=s(ij)/2π=(j

–

1)/(k

×

i)

63.于是,ss(702)=(2

–

1)/(6

×

7)=0.0238;

64.在图像采集过程中,被采集图像人员的面部距离镜头始终保持一定距离,被采集图像人员的头部位姿保持稳定,视点靶位图纸中的数字编号依据一定规律播报,为了提高被采集图像人员注视视点靶位的准确性,同时考虑被采集图像人员的舒适度,数字编号的播报规律是从视点靶位的第5个径向区间开始,径向区间的顺序依次为5、4、3、2、1、6、7、8、9、3、2、1,其中,第1个径向区间、第2个径向区间和第3个径向区间重复一次,目的是均衡各个径向区间的数据规模;如附图3b所示,视点靶位图纸分为up区域、right区域、down区域、

left区域,共四个方位区域,在图像采集过程中,数字编号的播报规律除了前述的径向区间顺序之外,对于每个径向区间,各个方位区域交替进行,以第5个径向区间为例,从up区域开始,播报up区域的第5个径向区间沿顺时针方向起始位置的第一个视点靶位的数字编号,然后播报right区域的第5个径向区间沿顺时针方向起始位置的第一个视点靶位的数字编号,之后是down区域和left区域,up区域、right区域、down区域、left区域交替进行;被采集图像人员根据听到的数字编号去注视对应的视点靶位,识别视点靶位中的字母编号并读出,若字母编号正确,则触发图像采集装置进行拍摄,完成一次数据采集;

65.人眼图像基准数据集的标签记为(x0,y0);以所述的数字编号“702”为例,则x0=rr(702)=0.7778,y0=ss(702)=0.0238,于是,数字编号“702”对应的标签为(0.7778,0.0238);

66.本领域技术人员可以理解,附图3中的人眼图像基准数据集视点靶位图纸以及实施例中以数字编号“702”为例的举例说明均不构成对本发明的限定。

67.如附图4a和附图4b所示,所述视线追踪模型m1的子模型之一的人眼视线基准模型m1-1主要包括卷积神经网络(convnet)和全连接层(fc);所述卷积神经网络(convnet)优选efficientnet(efficientnet:rethinking model scaling for convolutional neural networks),efficientnet网络的结构是由神经网络架构搜索(neural architecture search)方法生成和优化得到的,efficientnet网络采用了mbconv模块,mbconv模块中的注意力机制能够用来让网络对重要的部分施加更多的关注,而且efficientnet网络采用了一种高效的模型复合缩放方法(compound model scaling)用于权衡网络深度、网络宽度和输入图片分辨率,兼顾了速度和精度,既可以实现较高的准确率,也可以充分节省算力资源;所述全连接层(fc)采用多层全连接神经网络的方法,全连接层(fc)的大小分别为256、64、16、2;所述人眼视线基准模型的训练阶段需要至少包含若干眼睛区域图像以及眼睛注视基准方位标签数据的人眼图像基准数据集;在模型的训练过程中,人眼视线基准模型m1-1的输入是眼睛区域图像eye-images,输出是用于表征眼睛注视基准方位的坐标值(x1,y1),利用损失函数loss(1)度量人眼视线基准模型m1-1输出的眼睛注视基准方位(x1,y1)与人眼图像基准数据集中的眼睛注视基准方位标签(x0,y0)之间的差异,损失函数loss(1)的计算公式为:

68.loss(i)=α(loss(r))2+(i-α)(loss(s))269.其中,α是权重系数,0《α《1,通过改变α的值可以调控loss(r)和loss(s)的权重比例;

70.loss(r)是径向损失,计算公式为:

[0071][0072]

其中,rr(1j)是第1个径向区间归一化之后的径向偏离值;

[0073]

loss(s)是环向损失,计算公式为:

[0074]

loss(s)2

×

(|yi-y0|-ε(t))

[0075]

其中,ε(t)是阶跃函数,t=|y1–

y0|

–

0.5,用于判断模型输出注视点与数据集标签注视点之间的环向偏离是否超过180度,在t《0时,ε(t)=0,在t≥0时,ε(t)=1。

[0076]

如附图5a、附图5b和附图5c所示,所述视线追踪模型m1的子模型之二的视线映射

融合模型m1-2采用的主要是多层全连接神经网络,用于融合人脸关键特征点的位置坐标和眼睛注视基准方位,从而进一步分析在头部姿态影响之下从眼睛注视基准方位到人眼注视点坐标之间的非线性变换关系;所述视线映射融合模型m1-2的输入分为两项,分别是人眼视线基准模型m1-1的输出(x1,y1)和人脸关键特征点的位置坐标矩阵f,其中,输入的第一项(x1,y1)通过一个大小为8的全连接层(fc 8)转换为一个大小为8的列向量,输入的第二项人脸关键特征点的位置坐标矩阵f拉平为一个大小为24的列向量,并依次经过全连接层大小分别为64、128、256、64、8的多层全连接神经网络,得到一个大小为8的列向量,然后,对(x1,y1)和f分别对应得到的两个大小为8的列向量进行拼接组合,得到一个大小为16的列向量,再依次经过全连接层大小分别为16、64、128、256、64、2的多层全连接神经网络,最后输出人眼的注视点坐标(x2,y2);在模型的训练阶段,视线追踪模型m1的输入数据是包含眼睛区域的人脸图像,人脸图像首先要完成operator(i)和operator(ii)两个数据处理操作任务,其中,operator(i)用于从人脸图像中截取眼睛区域图像eye-images,operator(ii)用于提取人脸关键特征点的位置坐标,得到人脸关键特征点的位置坐标矩阵f;然后,眼睛区域图像eye-images通过输入人眼视线基准模型m1-1计算得到眼睛注视基准方位(x1,y1);人脸关键特征点的位置坐标矩阵f和眼睛注视基准方位(x1,y1)输入到视线映射融合模型m1-2,视线映射融合模型m1-2输出注视点坐标(x2,y2);利用损失函数loss(2)度量视线追踪模型m1子模型之二的视线映射融合模型m1-2输出的注视点坐标(x2,y2)与注视点坐标标签(x,y)之间的差异,损失函数loss(2)的计算公式为:

[0077][0078]

所述operator(i)和operator(ii)两个数据处理操作任务发生在边缘计算终端模块102的客服终端102-2;客服终端102-2利用前置摄像机捕获人脸图像,并对人脸图像进行实时处理;优选dlib库进行人脸特征点检测,如附图6所示,所述dlib库采用了总共68个点标记人脸的重要部位,比如,编号为18-22的点用于标记右侧眉毛,编号为51-68的点用于标记嘴巴;

[0079]

其中,所述operator(i)用于从人脸图像中截取眼睛区域图像eye-images;首先,分别选取编号为37-42的点构成的围合区域、编号为43-48的点构成的围合区域,然后,分别向围合区域之外扩展若干个像素形成两个矩形框选区域并且进行截图,以确保覆盖整个眼睛,所述两个矩形框选区域的截图即为眼睛区域图像eye-images;所述operator(ii)用于提取人脸关键特征点的位置坐标,通过选取编号为1、6、9、12、17、20、25、31、37、40、43、46的点,读取这12个点所对应的像素在图像中的位置坐标并构成一个大小为12

×

2的人脸关键特征点的位置坐标矩阵f;

[0080]

所述视线追踪模型m1完成训练阶段之后,其应用阶段的结构示意图和流程示意图分别如附图7a和附图7b所示,所述视线追踪模型m1的输入是摄像机捕获人脸图像,视线追踪模型m1的输出是注视点坐标(x2,y2)。

[0081]

具体应用时,如附图8所示,其中,附图8a所示是视频通话基础模式(i)的工作流程,其特征在于,包含以下步骤:

[0082]

(1)现场终端呼叫客服终端建立视频通话;

[0083]

(2)现场终端采集现场音频和现场视频,同时,客服终端采集客服音频;

[0084]

(3)音频和视频数据上传到云端服务器模块;

[0085]

(4)云端服务器模块向边缘计算终端模块分发传输数据;

[0086]

(5)现场终端播放客服音频,同时,客服终端播放现场音频和显示现场视频;

[0087]

在前述步骤基础上,附图8b所示是同时开启视频通话基础模式和视线追踪智能交互模式(i+ii)的工作流程,其特征在于,包含以下后续步骤:

[0088]

(6)客服选择开启视线追踪智能交互模式;

[0089]

(7)客服终端利用前置摄像机捕获用户人脸图像并计算处理;

[0090]

(8)截图人脸图像中的眼睛区域图像,同时,提取人脸关键特征点的位置坐标;

[0091]

(9)眼睛区域图像和人脸关键特征点的位置坐标上传到云端服务器模块;

[0092]

(10)视线追踪模型输入眼睛区域图像和人脸关键特征点的位置坐标;

[0093]

(11)视线追踪模型输出客服终端用户的注视点坐标数据;

[0094]

(12)物体分割模型计算注视点所映射目标物体的轮廓数据;

[0095]

(13)注视点坐标和目标物体的轮廓数据传输给现场终端;

[0096]

(14)现场终端处理注视点坐标和目标物体的轮廓数据;

[0097]

(15)现场终端显示屏的视频画面叠加展示注视点和目标物体轮廓形貌;

[0098]

在前述步骤基础上,附图8c所示是同时开启视频通话基础模式、视线追踪智能交互模式和语音辅助分析模式的工作流程,其特征在于,包含以下后续步骤:

[0099]

(16)客服选择同时开启视线追踪智能交互模式和语音辅助分析模式;

[0100]

(17)云端服务器模块的语音辅助模型从通话音频中获取物体名称和动作指令;

[0101]

(18)物体名称和动作指令数据传输给现场终端;

[0102]

(19)现场终端对物体名称和动作指令数据进行处理;

[0103]

(20)现场终端显示屏的视频画面同时展示注视点、目标物体轮廓形貌、物体名称以及客服终端的用户所表达动作的动画效果。

[0104]

以上所述的仅是本发明的优选实施方式,本发明不限于以上实施例。可以理解,本领域技术人员在不脱离本发明的精神和构思的前提下直接导出或联想到的其他改进和变化,均应认为包含在本发明的保护范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1