信息处理装置和信息处理方法与流程

1.本公开涉及信息处理装置和信息处理方法。

背景技术:

2.jp-2018-077071-a公开了一种能够稳定且正确地测量到物体的范围或距离的测距设备。

3.jp-2011-077606-a公开了一种摄像装置,当拍摄的图像中包括由手指等时,该摄像装置执行图像处理以减小包括在拍摄的图像中的手指等的影响。

4.引文列表

5.专利文献

6.[专利文献1]jp-2018-077071-a

[0007]

[专利文献2]jp-2011-077606-a

技术实现要素:

[0008]

技术问题

[0009]

本发明公开了鉴于上述问题而设计的实施方式,以提供可以容易地确认在没有不期望的物体的情况下获取所希望的三维信息的信息处理装置和信息处理方法。

[0010]

解决问题的方案

[0011]

在本发明的一个方面中,一种信息处理装置输出基于接收光来确定的三维信息,包括:摄像单元,被配置为拍摄二维图像信息,以及输出单元,被配置为输出用于显示的所述二维图像信息和与所述二维图像信息的坐标相关联的所述三维信息。

[0012]

本发明的效果

[0013]

根据本公开的一个或多个实施方式,能够提供可以容易地确认在没有不期望的物体的情况下获取所希望的三维信息的信息处理装置和信息处理方法。

附图说明

[0014]

附图旨在说明本发明的示例性实施例,而不应被解释为限制其范围。除非明确指出,否则附图不应被视为按比例绘制。另外,在所有附图中,相同或相似的附图标记表示相同或相似的部件。

[0015]

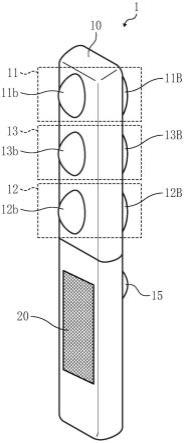

图1所示是本发明的实施方式所涉及的摄像装置的外观的示例。

[0016]

图2所示是本发明的实施方式所涉及的摄像装置的构成的剖视图。

[0017]

图3a所示是本发明的实施方式所涉及的摄像装置的使用状况的示例。

[0018]

图3b所示是本发明的实施方式所涉及的摄像装置的使用状况的示例。

[0019]

图3c所示是本发明的实施方式所涉及的摄像装置的使用状况的示例。

[0020]

图3d所示是本发明的实施方式所涉及的摄像装置的使用状况的示例。

[0021]

图4所示是本发明的实施方式所涉及的处理电路的功能框图的示例。

[0022]

图5所示是本发明的实施方式所涉及的摄像装置的处理电路的操作流程图的示例。

[0023]

图6a所示是本发明的实施方式所涉及的全景球面图像的图像数据生成的流程图的示例。

[0024]

图6b所示是本发明的实施方式所涉及的生成全景球面图像的图像数据生成的流程图的示例。

[0025]

图7所示是本发明的实施方式所涉及的判定附近物体的流程图的示例。

[0026]

图8所示是本发明的实施方式所涉及的使用显示单元的视图显示内容的示例。

[0027]

图9所示是本发明的实施方式所涉及的第一变形例的摄像装置的外观的示例。

[0028]

图10所示是本发明的实施方式所涉及的第一变形例的处理电路的功能框图的示例。

[0029]

图11所示是本发明的实施方式所涉及的第二变形例的摄像装置的外观的示例。

[0030]

图12所示是本发明的实施方式所涉及的第二变形例的处理电路的功能框图的示例。

[0031]

图13所示是本发明的实施方式所涉及的第二变形例的判定附近物体的流程图的示例。

[0032]

图14所示是本发明的实施方式所涉及的第三变形例的摄像装置的构成的剖视图。

具体实施方式

[0033]

本文使用的词仅用于说明特定实施例的目的,并不意图限制本发明。如本文所使用的,单数形式"一"、"一个"和"该"旨在也包括复数形式,除非上下文另有明确说明。在说明附图所示的实施方式时,为了清楚起见采用了特定词。然而,本说明书的公开内容并不旨在限于所选择的特定词,并且应当理解为,每个特定要素包括具有类似功能、以类似方式操作并且实现类似结果的所有技术等同物。以下,参照附图对实施本发明的构成进行说明。

[0034]

以下,参照附图来详细说明摄像装置、摄像/处理方法、信息处理装置和信息处理方法的一个或多个实施方式。

[0035]

图1所示是本发明的实施方式所涉及的摄像装置1的外观的示例。图2所示是摄像装置1的构成的剖面图的一例。图2所示是图1的摄像装置1的内部构成。

[0036]

摄像装置1是输出基于接收到的光来确定的三维信息的信息处理装置的示例。

[0037]

如图1所示,摄像装置1包括例如摄像单元11(即,相机)、投影单元12、距离信息获取单元13,它们被一体式地收容在壳体10(或盒体10)中。

[0038]

投影单元12相当于距离传感器的发光单元,其投影可见光以外的光。

[0039]

距离信息获取单元13对应于距离传感器的受光单元,其基于由投影单元12投影并从物体反射的光来获取距离信息。这些单元都被配置为经由同步信号线l(见图2)与设置在壳体10中的处理电路14(见图2)电连接,并被配置为彼此同步地动作。

[0040]

如图1所示,摄像装置1还包括摄像开关15,其由用户用于将摄像指示信号输入到处理电路14。

[0041]

如图1所示,摄像装置1还可以包括显示单元20,其显示与从处理电路14接收的输出信号相对应的内容。显示单元20例如采用液晶画面等。显示单元20可以采用例如触摸面

板来接收由用户输入的操作。

[0042]

处理电路14控制上述各个单元以获取诸如红/绿/蓝(rgb)图像数据和距离信息数据的信息,并且基于所获取的rgb图像数据和距离信息数据将所获取的距离信息数据重构为高密度的三维点组数据。可以在不处理距离信息数据的情况下使用距离信息数据来构建三维点组数据,但是在这种情况下,三维点组数据的精度限于距离信息获取单元13的像素数(即,分辨率)。

[0043]

在本发明的实施方式中,说明将距离信息数据重构为高密度的三维点组数据的处理。重构数据经由便携式记录介质或通信网络被输出到诸如个人计算机(pc)等的外部装置或设备,然后被用于显示三维恢复模型。

[0044]

从包括在壳体10中的电池向上述各个单元和处理电路14中的每一个提供电力。可替换地,电力可以经由连接线或无线来从壳体10的外部供应。

[0045]

拍摄二维图像信息的摄像单元11包括例如摄像元件11a、11a以及鱼眼透镜11b、11b。鱼眼透镜是广角透镜的示例。

[0046]

投影单元12例如具有光源单元12a、12a和广角透镜12b、12b。

[0047]

距离信息获取单元13包括例如飞行时间(tof)传感器13a、13a以及广角透镜13b、13b。

[0048]

虽然未示出,但是可以被配置为使用包括棱镜和透镜组的光学系统。例如,可以使用用于将由鱼眼透镜11b、11b收集的光聚焦到摄像元件11a、11a上的光学系统来配置摄像单元11。此外,投影单元12可以被配置为使用光学系统将来自光源单元12a、12a的光引导到广角透镜12b、12b。此外,距离信息获取单元13可以被配置为使用光学系统将由广角透镜13b、13b收集的光聚焦到tof传感器13a、13a上。各光学系统可以根据摄像元件11a、11a、光源部12a、12a以及tof传感器13a、13a的构成和配置来适当设计。在该说明中,省略了包括棱镜和透镜组的光学系统。

[0049]

摄像元件11a、11a、光源单元12a、12a以及tof传感器13a、13a被一体地收纳在壳体10内。鱼眼透镜11b、广角透镜12b、广角透镜13b和显示单元20设置在壳体10的第一面(即,前侧)上。关于第一面,鱼眼透镜11b、广角透镜12b和广角透镜13b中的每一个具有内部开放空间。

[0050]

此外,在壳体10的第二面(即,后侧)上设置有鱼眼透镜11b、广角透镜12b、广角透镜13b和摄像开关15。关于第二面,鱼眼透镜11b、广角透镜12b和广角透镜13b中的每一个具有内部开放空间。

[0051]

摄像元件11a、11a是具有规定的二维分辨率的图像传感器(或面传感器)。每个摄像元件11a、11a都具有摄像区域,其中与各个像素对应的大量受光元件(例如,光电二极管)沿二维方向配置。在摄像区域搭载由例如使用拜耳(bayer)排列来接收可见光的红(r)、绿(g)、蓝(b)的滤色器,通过滤色器的光作为电而蓄积在光电二极管中。在本说明书中,图像传感器具有大量像素,从而能够高分辨率地获取广角区域(例如,以图2所示的摄像方向作为前侧的具有180度圆周的半球范围)的二维图像。

[0052]

每个摄像元件11a、11a使用各像素的像素电路将聚焦于摄像区域的光转换为电信号,并输出高分辨率的rgb图像数据。

[0053]

每个鱼眼透镜11b、11b收集来自广角区域(例如,以图2所示的摄像方向作为前侧

的具有180度圆周的半球范围)的光,并将光聚焦于各摄像元件11a、11a的摄像区域。

[0054]

每个光源单元12a、12a例如是半导体激光器,其发射可见光区域以外的波长带(例如,红外光)的激光束光,来用于测量范围或距离。每个光源单元12a、12a可以采用单个的半导体激光器或多个的半导体激光器的组合。此外,半导体激光器可以采用面发射型半导体激光器,例如垂直腔表面发射激光器(vcsel)。

[0055]

此外,可以设置光学透镜来使半导体激光器的光形成为纵长的光,然后可以使用诸如微机电系统(mems)反射镜的光学偏转元件在测量范围的一维方向上扫描纵长的光。

[0056]

在本说明书中,光源单元12a、12a不使用例如mems反射镜等的光学偏转元件,而是通过广角透镜12b、12b将半导体激光器la的光发射到广角区域。

[0057]

光源单元12a、12a的广角透镜广角透镜具有将从光源单元12a、12a发射的光扩展到广角区域(例如,以图2所示的摄像方向作为前侧的具有180度圆周的半球范围)的功能。

[0058]

距离信息获取单元13的各广角透镜13b、13b从作为测量范围的广角区域(例如,以图2所示的摄像方向作为前侧的具有180度圆周的半球范围)的各方向分别接收与由投影单元12投影的光对应的光源单元12a、12a的反射光,并使其分别聚光于tof传感器13a、13a的受光区域。

[0059]

测量范围表示包括要被光投影的一个或多个物体(例如,诸如建筑物的目标物)的空间。从目标物反射的光(反射光)进入各广角透镜13b、13b。例如,可以通过在各个广角透镜13b、13b的整个面上设置用于截止具有比红外波长范围短的波长范围的光的滤光器来接收反射光。此外,构成不限于此。例如,由于只要红外区域的光进入受光区域就足够,所以可以在从广角透镜13b、13b到受光区域的光路中设置诸如滤光器的用于使红外区域的光通过的单元。

[0060]

各个tof传感器13a、13a是具有二维分辨率的光学传感器。各个tof传感器13a、13a具有在二维方向上排列了大量受光元件(例如光电二极管)的受光区域。在本说明中,有时将各tof传感器13a、13a称为"第二摄像受光单元"。各个tof传感器13a、13a使用对应于各区域的受光元件来接收测量范围(各区域也被称为位置)中每个区域的反射光,然后基于各受光元件检测到的光来测量或计算到各区域的距离或范围。

[0061]

在本实施方式中,使用相位差检测方法来测量距离。在相位差检测方法中,将以基本频率调制了振幅的激光束光朝向测量范围照射来接收反射光,然后测量照射光与反射光的相位差来获取或获得照射光的发光开始时间与反射光的接收时间之间的时间期间,并通过在该时间期间里乘以光速来算出距离。相位差检测可以确保一定程度的分辨率。

[0062]

各tof传感器13a、13a与投影单元12的照射光的投影同步地被驱动,从各受光元件(对应于各像素)处的反射光的相位差来计算对应于各像素的距离,并输出与像素信息相关联的表示到测量范围内各区域的距离的信息的包括距离信息的图像数据(以下,称为"距离图像"或"tof图像")。

[0063]

此外,各tof传感器13a、13a可以被配置为输出相位信息与像素信息相关联的相位信息图像数据,并且通过执行后处理来基于相位信息图像数据获取包括距离信息的图像数据。

[0064]

此外,可以鉴于受光区域的分辨率来确定测量范围中分割的区域数量。因此,当使用低分辨率来减小装置的尺寸时,距离图像数据的像素信息的数量减少,三维点组的数量

也因而减少。

[0065]

此外,代替相位差检测方法的是,可以使用脉冲方法来测量距离。在脉冲方法中,例如,各光源单元12a、12a发射具有几纳秒(ns)的上升时间和较强的强度峰值功率的超短脉冲的照射脉冲p1,并与照射脉冲p1的发射同步地,各tof传感器13a、13a测量接收反射脉冲p2所需的时间(t),该反射脉冲p2是与从光源单元12a、12a发射的照射脉冲p1相对应的反射光。当采用脉冲方法时,例如,各tof传感器13a、13a包括用于在受光元件的输出侧测量时间的一个或多个电路。各电路将从各光源单元12a、12a发射照射脉冲p1后接收反射脉冲p2所需的时间期间转换为各受光元件的距离信息,来获取或获得到各区域的距离。

[0066]

脉冲方法适合于为摄像装置1设置广角区域,因为脉冲方法可以使用峰值光来输出强度更强的光。此外,当使用mems反射镜等来振荡或扫描光时,在减小光的扩散角的同时,能够将强度更强的光照射到远处,由此可以增大测量距离。在这种情况下,光源单元12a、12a、广角透镜12b、12b以及mems反射镜以规定的构成来配置,以使得从各光源单元12a、12a发射的激光束光通过mems反射镜朝向广角透镜12b、12b扫描或偏转。

[0067]

此外,摄像单元11的有效视角和距离信息获取单元13的有效视角优选为彼此匹配,例如,180度或更大,但是摄像单元11的有效视角和距离信息获取单元13的有效视角不必一定要彼此匹配。可以根据需要来分别减小摄像单元11的有效视角和距离信息获取单元13的有效视角。

[0068]

在本实施方式中,摄像单元11和距离信息获取单元13例如在100度到180度的范围内减少有效像素的数量,以使得摄像装置1的主体和距离信息获取单元13不包括在视角中。

[0069]

此外,可以将tof传感器13a、13a的分辨率设置为低于摄像元件11a、11a的分辨率,以优先于摄像装置1的尺寸减小或小型化。通过将tof传感器13a、13a的分辨率设置为低于摄像元件11a、11a的分辨率,因为可以减小受光区域的尺寸,所以可以减小摄像装置1的尺寸。因此,各tof传感器13a、13a可以设置成低分辨率,并且由各tof传感器13a、13a获取或获得的三维点组具有低的密度,但是因为设置了用作"获取单元"的处理电路14,三维点组可以被转换为高密度的三维点组。稍后将说明使用处理电路14来转换为高密度的三维点组的处理。

[0070]

在本实施方式中,作为一个例子,摄像元件11a、光源单元12a以及tof传感器13a沿着壳体10的长边方向排列在一条直线上。类似地,摄像元件11a、光源单元12a以及tof传感器13a沿着壳体10的长边方向排列在一条直线上。以下,对摄像元件11a、光源部12a以及tof传感器13a的一例进行说明。

[0071]

如图2所示,摄像元件11a的摄像区域(摄像面)和tof传感器13a的受光区域(受光面)既可以沿着与长边方向正交的方向配置,也可以通过设置将光的方向(光路)的路径改变90度的棱镜等而沿着长边方向来配置。此外,摄像元件11a、光源单元12a和tof传感器13a可以根据各种构成来配置在任何朝向里。也就是说,摄像元件11a、光源单元12a和tof传感器13a沿着任何方向配置,以使得可以设置相同的测量范围来测量到目标物的距离。摄像单元11、投影单元12和距离信息获取单元13被配置在壳体10的一侧来面向测量范围。在该构成中,摄像元件11a和tof传感器13a可以沿着相同的基线配置以成为平行立体构成。通过使用平行立体构成来配置摄像元件11a和tof传感器13a,即使摄像元件11a的数量是一个,也可以使用tof传感器13a的输出来获取或获得视差数据。光源单元12a被配置为对tof传感器

13a的测量范围照射光。

[0072]

(处理电路)

[0073]

以下,对处理电路14的处理进行说明。由tof传感器13a、13a获取或获得的tof图像具有较低的分辨率。因此,在本实施方式中,通过处理电路14来提高分辨率,然后重构高密度的三维点组数据。此外,由诸如处理电路14的"信息处理单元"执行的以下处理的一部分或全部可以由外部设备或装置来执行。

[0074]

如上所述,由摄像装置1重构的三维点组数据经由便携式记录介质或通信网络被输出到外部设备(例如,pc),并且被用于显示三维恢复模型。

[0075]

根据这种构成,与摄像装置1在摄像装置1上显示三维恢复模型的情况相比,可以提供具有用于处理数据的更高速度、更小尺寸和更轻重量的摄像装置1。

[0076]

然而,在离开用户获取三维信息的地点并通过外部设备恢复三维信息之后,用户可以识别出在拍摄的图像中包括有用户自己或三脚架,并且还没有获取到具有所期望的布局的三维信息。在这种情况下,用户需要额外的时间和精力来重新访问获取三维信息的地点。

[0077]

该问题可以通过将三维恢复设备带到该地点来解决,但是如果用户带着三维恢复设备,就不能设计可以以高处理速度来处理数据并具有小尺寸和轻重量的摄像装置1。

[0078]

此外,可以通过经由通信线路将获取的三维信息发送到外部设备并且从外部设备接收恢复的三维信息来解决该问题。然而,该方法不具有高处理速度的优点,此外,由于三维信息具有大量的信息,因此用户难以在视觉上确认用户自身、三脚架等包含在拍摄的图像中。

[0079]

特别地,在全视图球面三维信息的情况下,用户极难视觉地确认用户自己、三脚架等包含在拍摄的图像中。

[0080]

使用本实施方式的摄像装置1可以容易地实时确认在拍摄的图像中包括用户自己、三脚架等已经尚未获取所期望的布局的三维信息的上述问题。

[0081]

图3a、3b、3c和3d所示是本实施方式所涉及的使用摄像装置1的情况的示例。

[0082]

在图3a所示的情形中,用户m和握持摄像装置1的自拍杆1a没有包含在全景球面图像摄像范围r中,从而用户m和自拍杆1a不包含在全景球面图像(即,拍摄的图像)中。在该说明中,用户m操作摄像装置1来拍摄图像。

[0083]

在图3b所示的情形中,由于用户m包含在全景球面图像摄像范围r中,因此用户m包含在全景球面图像(即,拍摄的图像)中。

[0084]

在图3c所示的情形中,因为保持摄像装置1的三脚架1b被包括在全景球面图像摄像范围r中,所以三脚架1b包含在全景球面图像(即,拍摄的图像)中。

[0085]

在图3d所示的情形中,由于用户m和握持摄像装置1的自拍杆1a没有包含在全景球面图像摄像范围r中,用户m和自拍杆1a不包含在全景球面图像(即,拍摄的图像)中。但是,由于外部光(例如,太阳光、照明设备的光)具有较强的强度,因此有可能错误地判定物体包含在拍摄的图像中。

[0086]

此外,在图3b和3c所示的情形中,因为包括在拍摄的图像中的物体的颜色、种类和外貌是各种各样的,所以传统方法难以判定例如用户等的对象物体是否被包括在拍摄的图像中。

[0087]

如果发生图3b和3c所示的上述情况,在基于从tof传感器13a、13a输出的包括距离信息的图像数据来判定诸如用户自身或三脚架的特定对象(例如,附近物体)的有无时,会难以区分是特定对象真的存在,还是外部光太强。

[0088]

也就是说,在tof传感器13a、13a的特定的像素的蓄电量饱和时,难以仅从tof传感器13a、13a的输出来区分饱和的蓄电量是由特定对象的存在引起的还是由外部光的太强强度引起的。

[0089]

鉴于上述问题,摄像装置1被配置为通过区分特定对象与外部光的影响来正确地确认拍摄的图像中是否包括例如用户自己或附近对象(例如,三角架)等的特定对象。

[0090]

图4所示是处理电路14的功能框图的示例。如图4所示,处理电路14包括例如控制单元141、rgb图像数据获取单元142、单色处理单元143、tof图像数据获取单元144、高分辨率处理单元145、匹配处理单元146、再投影处理单元147、语义分割单元148、视差计算单元149、三维重构处理单元150、判定单元160、显示控制单元170(输出单元的示例)以及发送-接收单元180(输出单元的示例)。在图4中,实线箭头表示信号的流动,虚线箭头表示数据的流动。

[0091]

响应于从摄像开关15接收on信号(摄像的开始信号)时,控制单元141对摄像元件11a、11a、光源单元12a、12a以及tof传感器13a、13a输出同步信号,并控制处理电路14全体。

[0092]

首先,控制单元141输出指示光源单元12a、12a发射超短脉冲光的信号,并以相同时机来输出指示tof传感器13a、13a生成tof图像数据的信号。此外,控制单元141输出指示摄像元件11a、11a拍摄图像的信号。在该构成中,由摄像元件11a、11a进行的摄像既可以在从光源单元12a、12a发射光的期间进行,也可以就在从光源单元12a、12a发射光的前后的期间进行。

[0093]

rgb图像数据获取单元142根据控制单元141的摄像指令来获取由摄像元件11a、11a拍摄的rgb图像数据,并输出全景球面图像的rgb图像数据。

[0094]

单色处理单元143为了与从tof传感器13a、13a获取或获得的tof图像数据的匹配处理,执行设定数据种类的处理。在该示例情况下,单色处理单元143将全景球面图像的rgb图像数据转换为全景球面图像的单色图像数据。

[0095]

tof图像数据获取单元144根据控制单元141的tof图像数据的生成指示,获取由tof传感器13a、13a生成的tof图像数据,并输出全景球面图像的tof图像数据。

[0096]

高分辨率处理单元145将全景球面图像的tof图像数据假定为单色图像数据,并增加tof图像数据的分辨率。具体来说,高分辨率处理单元145y以全景球面图像的单色图像数据的值(灰度值)来替换与全景球面图像的tof图像数据的各像素相关联的距离值。

[0097]

另外,高分辨率处理单元145将全景球面图像的单色图像数据的分辨率增加到从摄像元件11a、11a获取或获得的全景球面图像的rgb图像数据的分辨率。例如,通过执行正常的转换增加处理来执行对高分辨率的转换。

[0098]

此外,可以应用其他转换方法。例如,获取连续生成的全景球面图像的tof图像的多个帧,然后通过使用这些帧追加相邻点之间的距离来执行超分辨率处理。

[0099]

匹配处理单元146从通过将全景球面图像的tof图像数据转换为高分辨率图像数据而获取或获得的全景球面图像的单色图像数据,以及与全景球面图像的rgb图像数据相对应的全景球面图像的单色图像数据,来提取具有纹理(texture)的部分处的特征量,然后

基于所提取的特征量执行匹配处理。例如,匹配处理单元146从每个单色图像数据提取边缘,然后对所提取的边缘信息执行匹配处理。

[0100]

此外,可以应用其他转换方法。例如,可以使用诸如尺度不变特征转换(sift)的量化纹理改变的方法来执行匹配处理。在本说明中,匹配处理意味着对应像素的搜索。

[0101]

作为匹配处理的一种方法,例如可以使用块匹配。块匹配是计算在要参照的像素附近被切割成m

×

m(m是正整数)像素尺寸的块的像素值与在对应图像中要搜索的中心像素附近被切割成m

×

m像素尺寸的块的像素值之间的相似度,并且将具有最高相似度的中心像素作为对应像素的方法。

[0102]

可以使用各种方法来计算相似度。例如,可以使用表示诸如归一化自相关系数的归一化相关系数(ncc)的式子。ncc数值越高,表示相似度越高,当块的像素值完全匹配时,ncc的值变为1。

[0103]

此外,由于还从全景球面图像的tof图像数据获取或获得无纹理区域的距离数据,因此可以通过根据区域设置权重来执行匹配处理。例如,当使用表示ncc的式子来执行计算时,可以通过将权重设置到边缘以外的部分(无纹理区域)来执行计算。

[0104]

此外,代之以表示ncc的式子,可以使用选择性相关系数(scc)。

[0105]

再投影处理单元147将表示测量范围内的各位置的距离的全景球面图像的tof图像数据再投影到摄像单元11的二维坐标(屏幕坐标系)上。执行再投影以确定由tof传感器13a、13a计算出的三维点将被投影到由摄像元件11a、11a拍摄的图像的哪个二维坐标。

[0106]

全景球面图像的tof图像数据表示以距离信息获取单元13(主要是广角透镜13b、13b)为中心的坐标系中的各三维点的位置。

[0107]

因此,将全景球面图像的tof图像数据表示的三维点再投影到以摄像单元11(主要是鱼眼透镜11b、11b)为中心的坐标系上。例如,再投影处理单元147将全景球面图像的tof图像数据的三维点的坐标平行移动到以摄像单元11为中心的三维点的坐标,在平行移动之后,再投影处理单元147将tof图像数据的三维点的坐标转换为全景球面图像的rgb图像数据所示的二维坐标系(屏幕坐标系)。

[0108]

根据这种构成,全景球面图像的tof图像数据的三维点的坐标与二维图像信息的坐标能够彼此相关联。

[0109]

再投影处理单元147将全景球面图像的tof图像数据的三维点的坐标与由摄像单元11拍摄到的全景球面图像的二维图像信息的坐标建立关联。

[0110]

视差计算单元149从关于由匹配处理获取的对应像素的距离的偏差或波动来计算各位置的视差。

[0111]

此外,可以使用由再投影处理单元147转换的再投影坐标,通过搜索再投影坐标的位置处的周围像素来执行视差匹配处理,可以缩短处理时间,并且可以获取或获得更详细和更高分辨率的距离信息。

[0112]

此外,通过使用语义分割单元148执行语义分割处理而获取或获得的分割数据可以用于视差匹配处理。在这种情况下,可以获取或获得更详细和更高分辨率的距离信息。

[0113]

此外,可以仅对边缘或具有较大特征量的部分来执行视差匹配处理,并且可以使用全景球面图像的tof图像数据以及例如全景球面图像的rgb图像特征和随机技术来对其他部分执行传播处理。

[0114]

语义分割单元148使用深度学习将表示目标物的分割标签应用于测量范围的输入图像。通过该处理,能够将全景球面图像的tof图像数据的各像素固定为按每个距离分割的多个距离区域中的任意一个,能够进一步提高计算的可靠性。

[0115]

三维重构处理单元150从rgb图像数据获取单元142获取全景球面图像的rgb图像数据,并基于从视差计算单元149输出的距离信息来重构全景球面图像的三维数据,然后输出对各三维点追加了颜色信息的全景球面图像的高密度三维点组。

[0116]

三维重构处理单元150是确定三维信息的三维信息确定单元的一例。

[0117]

判定单元160从rgb图像数据获取单元142获取全景球面图像的rgb图像数据,并且还从再投影处理单元147获取被转换成通过全景球面图像的rgb图像数据表示的二维坐标系的全景球面图像的tof图像数据,然后基于这些数据判定在拍摄的图像中是否包括特定对象,并且将判定结果输出到显示控制单元170。

[0118]

显示控制单元170从rgb图像数据获取单元142获取全景球面图像的rgb图像数据,并指示显示单元20基于所获取的全景球面图像的rgb图像数据来显示二维图像信息。

[0119]

此外,显示控制单元170将从判定单元160获取或获得的表示判定结果的信息叠加到二维图像信息上,然后指示显示单元20显示二维图像信息。

[0120]

显示控制单元170是与三维信息分开地输出的由摄像单元11拍摄的二维图像信息的输出单元的一例。显示单元20是输出二维图像信息的输出目的地的一例。

[0121]

显示控制单元170可以被配置为从三维重构处理单元150获取或获得全景球面图像的三维数据,并且指示显示单元20显示三维信息。具体来说,显示控制单元170可以根据预设条件来选择显示控制单元170指示显示单元20显示二维图像信息的模式,以及显示控制单元170指示显示单元20显示三维信息的另一种模式。根据这种构成,显示控制单元170可以与三维信息分开地输出二维图像信息。

[0122]

发送-接收单元180通过有线或无线与外部设备进行通信。发送-接收单元180经由网络400,将从三维重构处理单元150输出的全景球面图像的三维数据和从rgb图像数据获取单元142输出的全景球面图像的二维图像信息发送或输出到执行三维恢复处理的外部设备300。

[0123]

在本说明中,由摄像单元11拍摄的二维图像信息是指用于创建"用于显示的二维图像数据"的"原始二维图像信息"或"用于显示的二维图像数据"。例如,可以在摄像装置1内部处理由摄像单元11拍摄的二维图像信息(即,原始二维图像信息)以创建"用于显示的二维图像数据",或者可以将摄像单元11拍摄的二维图像信息(即,原始二维图像信息)从摄像装置1发送到外部设备,然后外部设备可以从"原始二维图像信息"来创建"用于显示的二维图像数据"。

[0124]

发送-接收单元180是输出三维信息的输出单元的一例。外部设备300是输出三维信息的输出目的地的一例。

[0125]

此外,发送-接收单元180可以被配置为不发送全景球面图像的二维图像信息,而仅发送全景球面图像的三维数据。此外,发送-接收单元180可以被配置为使用能够与诸如安全数字(sd)卡和个人计算机的便携式存储介质通信的接口电路。

[0126]

(处理电路的动作)

[0127]

图5所示是摄像装置1的处理电路14的动作的流程图的一例。当摄像开关15被用户

接通并且摄像指示信号被输入时,处理电路14的控制单元141使用以下方法(摄像/处理方法和信息处理方法的一例)来执行生成高密度三维点组的动作。

[0128]

首先,控制单元141驱动光源单元12a、12a、tof传感器13a、13a以及摄像元件11a、11a来拍摄测量范围的图像(步骤s1)。控制单元141指示光源单元12a、12a发射红外光(光投影步骤的一例),然后tof传感器13a、13a接收从物体反射的光(光接收步骤的一例)。此外,摄像元件11a、11a在开始驱动光源单元12a、12a的时机或就在开始驱动光源单元12a、12a的时机的附近的期间拍摄测量范围的图像(摄像步骤的一例)。

[0129]

然后,rgb图像数据获取单元142从摄像元件11a、11a获取测量范围的rgb图像数据(步骤s2)。

[0130]

然后,显示控制单元170从rgb图像数据获取单元142获取全景球面图像的rgb图像数据,然后指示显示单元20基于所获取的全景球面图像的rgb图像数据来显示二维图像信息(二维图像信息输出步骤的一例)(步骤s3)。

[0131]

显示控制单元170指示显示单元20显示所获取的全景球面图像的rgb图像数据的部分区域的二维图像信息,然后响应于接收到由用户输入的各种指令来改变由显示单元20显示的二维图像信息的区域。例如,如果摄像装置1设有摄像开关15以外的一个或多个操作开关,或作为输入单元的例如触摸面板等的显示单元20,则用户可以使用这些开关和单元来输入各种指令。

[0132]

在步骤s3中,用户可以通过观看使用显示单元20显示的二维图像信息来确认在拍摄的图像中是否包括用户自己、三脚架等,以及是否已经获取所期望的布局的二维图像信息。

[0133]

然后,tof图像数据获取单元144从tof传感器13a、13a获取表示二维区域中的各位置的距离的tof图像数据(步骤s4)。

[0134]

然后,单色处理单元143将rgb图像数据转换为单色图像数据(步骤s5)。因为tof图像数据是距离数据而rgb图像数据是rgb数据(即,tof图像数据和rgb图像数据的数据种类不同),所以不能对tof图像数据和rgb图像数据执行匹配。因此,首先,将各tof图像数据和各rgb图像数据转换为单色图像数据。关于tof图像数据,在进行分辨率增强之前,高分辨率处理部145通过将表示各像素的距离的值直接置换为单色图像数据的值,来对表示各像素的距离的值进行转换。

[0135]

接着,高分辨率处理单元145增加tof图像数据的分辨率(步骤s6)。

[0136]

然后,匹配处理单元146针对每个单色图像数据提取具有纹理的部分的特征量,然后使用所提取的特征量来执行匹配处理(步骤s7)。

[0137]

然后,视差计算单元149从对应像素的距离的偏差来计算各位置的视差,以计算距离(步骤s8)。

[0138]

然后,判定单元160从rgb图像数据获取单元142获取全景球面图像的rgb图像数据,并且还从再投影处理单元147获取被转换成通过rgb图像数据表示的二维坐标系的全景球面图像的tof图像数据,然后基于全景球面图像的rgb图像数据和全景球面图像的tof图像数据来判定在拍摄的图像中有无附近物体(即,特定对象),然后将判定结果输出到显示控制单元170。

[0139]

然后,显示控制单元170将从判定单元160获取或获得的表示判定结果的信息叠加

到二维图像信息上,并指示显示单元20显示二维图像信息(显示步骤的一例)(步骤s9)。

[0140]

然后,三维重构处理单元150从rgb图像数据获取单元142获取rgb图像数据,并基于从视差计算单元149输出的距离信息来重构三维数据,然后输出对各三维点追加了颜色信息的高密度三维点组(步骤s10)。

[0141]

然后,发送-接收单元180经由网络400,将从三维重构处理单元150输出的三维数据和从rgb图像数据获取单元142输出的二维图像信息发送到执行三维恢复处理的外部设备300(三维信息输出步骤的一例)(步骤s11)。

[0142]

发送-接收单元180可以被配置为发送从三维重构处理单元150输出的三维数据,而不发送从rgb图像数据获取单元142输出的二维图像信息。

[0143]

如上所述,摄像装置1包括摄像单元11和与三维信息分开地输出由摄像单元11拍摄的二维图像信息的显示控制单元170。

[0144]

根据这种构成,在不确认三维信息的情况下,用户可以从二维图像信息容易地确认拍摄的图像中是否包括用户自己、三脚架等,以及是否已经获取具有所期望的布局的三维信息。

[0145]

因此,用户可以在停留在获取或获得三维信息的地点的同时重新获取三维信息,相比于用户在离开获取三维信息的地点之后识别出拍摄的图像中包括用户自己、三脚架等或者没有获取到具有期望布局的三维信息的情况,可以减少重新访问获取或获得三维信息的地点的工作或劳动。

[0146]

在本说明中,三维信息包括例如全景球面图像的三维信息。在这种情况下,如果全景球面三维信息被拍摄且用户感觉难以确认拍摄的图像中是否包括用户自己、三脚架等,以及是否已经获取具有所期望的布局的三维信息,则用户可以从摄像单元11拍摄的二维图像信息容易地确认拍摄的图像中是否包括用户自己、三脚架等,以及是否已经获取具有所期望的布局的三维信息。

[0147]

在发送-接收单元180在步骤s11中发送或输出三维信息之前,显示控制单元170在步骤s3中输出二维图像信息g。此外,在步骤s10中三维重构处理单元150确定三维信息之前,显示控制单元170在步骤s3中输出二维图像信息g。

[0148]

根据这种构成,在确认三维信息之前,用户可以从二维图像信息确认拍摄的图像中是否包括用户自己、三脚架等,以及是否已经获取具有所期望的布局的三维信息。

[0149]

摄像装置1可以具备显示单元20,其中显示控制单元170指示显示单元20显示二维图像信息。

[0150]

根据这种构成,用户可以从使用显示单元20显示的二维图像信息容易地确认拍摄的图像中是否包括用户自己、三脚架等,以及是否已经获取具有所期望的布局的三维信息。

[0151]

显示控制单元170可以将二维图像信息输出到与发送-接收单元180输出三维信息的外部设备300不同的显示单元20。

[0152]

根据这种构成,用户可以确认拍摄的图像中是否包括用户自己、三脚架等,以及从输出到不同于外部设备300的显示单元20的二维图像信息是否已经获取具有所期望的布局的三维信息,而无需确认输出到外部设备300的三维信息。

[0153]

摄像装置1可以具备基于距离信息获取单元13的输出来确定三维信息的三维重构处理单元150。三维重构处理单元150基于从距离信息获取单元13接收到的输出和二维图像

信息来确定三维信息。

[0154]

根据这种构成,用户可以确认拍摄的图像中是否包括用户自己、三脚架等,以及从摄像单元11拍摄的二维图像信息是否已经获取具有所期望的布局的三维信息,而无需确认由三维重构处理单元150确定的三维信息。

[0155]

图6所示是本实施方式所涉及的全景球面图像的图像数据生成的处理的流程图的示例。

[0156]

图6a所示是对应于参照图5说明的步骤s2的全景球面图像的rgb图像数据生成的处理的流程图的示例。

[0157]

rgb图像数据获取单元142输入具有鱼眼图像格式的两帧rgb图像数据(步骤s201)。

[0158]

然后,rgb图像数据获取单元142将两帧rgb图像数据中的每一帧转换为具有等距圆柱图像格式的图像数据(步骤s202)。rgb图像数据获取单元142基于相同的坐标系将两帧rgb图像数据转换为具有等距圆柱图像格式的图像数据,以便于在下一步骤s203中的图像组合或拼接。要注意的是,也可以根据需要将rgb图像数据转换为使用了等距圆柱图像格式以外的一种以上的图像格式的图像数据。例如,可以将rgb图像数据转换为在任意面上透视投影的图像的坐标或者在任意多面体的每个面上透视投影的图像的坐标。

[0159]

以下,对等距圆柱图像格式进行说明。等距圆柱图像格式是能够表现全景球面图像的格式,并且是使用等距圆柱方法创建的图像(即,等距圆柱图像)的格式。等距圆柱方法是例如地球的纬度和经度等的两个变量表示三维方向,并显示纬度和经度彼此正交的平面图像的方法。因此,等距圆柱图像是使用等距圆柱方法生成的图像,并且使用以球面坐标系统的两个角变量作为两个轴的坐标来表示。

[0160]

然后,rgb图像数据获取单元142组合或拼接在步骤s202中生成的两帧rgb图像数据,以生成全景球面图像的rgb图像数据的一个图像(步骤s203)。输入的两帧rgb图像数据的每一帧覆盖具有大于180度的全视角的区域。因此,通过适当地组合或拼接两帧rgb图像数据而生成的全景球面图像rgb图像数据可以覆盖全景球面图像区域。

[0161]

此外,步骤s203中的组合或拼接处理可以使用用于组合或拼接多个图像的任何的已知技术,并且该方法不受特别限制。

[0162]

图6b所示是对应于参照图5说明的步骤s4的全景球面图像的tof图像数据生成的处理的流程图的示例。

[0163]

tof图像数据获取单元144获取具有鱼眼图像格式的两帧距离图像数据(步骤s401)。

[0164]

然后,tof图像数据获取单元144将具有鱼眼图像格式的两帧tof图像数据转换为具有等距圆柱图像格式的图像数据(步骤s402)。如上所述,等距圆柱图像格式是能够表现全景球面图像的格式。在步骤s402中,基于相同的坐标系将两帧tof图像数据转换为具有等距圆柱图像格式的图像数据,以便于在下一步骤s403中的图像的组合或拼接处理。

[0165]

然后,tof图像数据获取单元144组合或拼接在步骤s402中生成的两帧tof图像数据,以生成一个全景球面图像的tof图像数据(步骤s403)。输入的两帧tof图像数据中的每一帧覆盖具有大于180度的全视角的区域。因此,通过适当地组合或拼接两帧tof图像数据而生成的全景球面图像tof图像数据可以覆盖全景球面图像区域。

[0166]

此外,步骤s403中的组合或拼接处理可以使用用于组合或拼接多个图像的任何的已知技术,并且该方法不受特别限制。

[0167]

图7所示是本实施方式所涉及的判定附近物体的流程图的示例。

[0168]

图7所示是判定附近物体是否包括在拍摄的图像中的处理的流程图,该处理对应于参照图5说明的步骤s9。

[0169]

判定单元160基于从再投影处理单元147获取或获得的全景球面图像的tof图像数据,判定全景球面图像的tof图像数据是否具有1个以上的蓄电量饱和的像素(步骤s801)。

[0170]

如果判定单元160在步骤s801中判定全景球面图像的tof图像数据具有1个以上的蓄电量饱和的像素(s801:"是"),基于从rgb图像数据获取单元142获取或获得的全景球面图像的rgb图像数据,判定单元160判定全景球面图像的rgb图像数据是否具有与在步骤s801中蓄电量饱和的一个或多个像素为相同坐标的一个或多个像素,该像素具有饱和的蓄电量(步骤s802)。

[0171]

如果判定单元160在步骤s802中判定全景球面图像的rgb图像数据具有1个以上的蓄电量饱和的像素(s802:"是"),判定单元160判定在步骤s801中具有饱和的蓄电量的像素是由外部光(例如,阳光、照明设备的光)引起的,并将出错信息输出到显示控制单元170。

[0172]

然后,基于从判定单元160获取或获得的出错信息,显示控制单元170将出错信息叠加到二维图像信息上,然后指示显示单元20显示叠加有出错信息的二维图像信息(步骤s803)。

[0173]

如果判定单元160在步骤s802中判定全景球面图像的rgb图像数据不具有蓄电量饱和的像素(s802:"否"),判定单元160判定在步骤s801中具有饱和的蓄电量的像素是因附近物体的存在引起的,并且在步骤s801中将具有饱和的蓄电量的像素的坐标位置信息输出到显示控制单元170。

[0174]

然后,基于从判定单元160获取或获得的像素的坐标位置信息,显示控制单元170将识别附近物体的识别信息叠加在二维图像信息上,然后指示显示单元20显示叠加在二维图像信息上的识别附近物体的识别信息(步骤s804)。

[0175]

如果判定单元160在步骤s801中判定全景球面图像的tof图像数据没有蓄电量饱和的像素(s801:"否"),基于从再投影处理单元147获取或获得的全景球面图像的tof图像数据,判定单元160判定全景球面图像的tof图像数据是否具有表示全景球面图像的tof图像数据中的规定距离信息,例如0.5m以下的一个或多个像素(步骤s805)。

[0176]

如果判定单元160在步骤s805中判定全景球面图像的tof图像数据没有表示0.5m以下的距离信息的像素(s805:"否"),判定单元160结束该时序。

[0177]

如果判定单元160在步骤s805中判定全景球面图像的tof图像数据具有一个以上表示0.5m以下的距离信息的像素(s805:"是"),判定单元160继续时序到步骤s804。

[0178]

如果步骤s805为"是",则判定单元160判定表示小于0.5m的距离信息的像素是由附近物体的存在引起的,并且在步骤s805中将表示小于0.5m的距离信息的像素的坐标位置信息输出到显示控制单元170。

[0179]

然后,在步骤s804中,基于从判定单元160获取或获得的像素的坐标位置信息,显示控制单元170指示显示单元20通过将识别附近物体的识别信息叠加在二维图像信息上来显示识别附近物体的识别信息。

[0180]

如上所述,如果判定单元160判定附近物体存在,则显示控制单元170将识别信息叠加在二维图像信息上,并且如果判定单元160判定附近物体不存在,则显示控制单元170不将识别信息叠加在二维图像信息上。

[0181]

也就是说,显示控制单元170指示显示单元20根据附近物体的有无来输出不同的显示。

[0182]

此外,基于从判定单元160获取或获得的像素的坐标位置信息,显示控制单元170指示显示单元20在二维图像信息上显示识别附近物体的识别信息。

[0183]

也就是说,显示控制单元170指示显示单元20根据附近物体在空间中的位置来设置附近物体的显示位置,这意味着每个附近物体的显示位置根据每个附近物体在空间中的位置而变得不同。

[0184]

图8所示是本实施方式所涉及的使用显示单元的视图显示内容的示例。

[0185]

图8所示是对应于图5中的步骤s3和图7中的步骤s803和s804的图。

[0186]

如图8所示,显示控制单元170指示显示单元20显示二维图像信息g。此外,如图8所示,通过将识别信息g1、g2和出错信息g3重叠在二维图像信息g上,显示控制单元170指示显示单元20显示识别各附近物体(例如,手指、三脚架)的信息g1、g2和出错信息g3。出错信息g3可以是图8所示的表示"太阳光"的标记,也可以是"照明设备"。

[0187]

如上所述,摄像装置1包括用于拍摄目标物的图像的摄像单元11、用于将光投影到目标物上的投影单元12、距离信息获取单元13,用于接收从目标物反射的光的距离信息获取单元13,以及用于指示显示单元20根据基于从距离信息获取单元13接收的输出信息和摄像单元11的输出信息判定的附近对象的有无来输出不同的显示的显示控制单元170。

[0188]

根据这种构成,通过将附近物体与外部光的影响区分开,用户可以正确地确认用户自身以及附近物体(例如,三脚架)是否被包括在拍摄的图像中。

[0189]

如上所述,摄像装置1设置有显示单元20。根据这种构成,用户可以正确地检查附近物体是否包括在拍摄的图像中。

[0190]

如上所述,显示控制单元170指示显示单元20根据附近物体在空间中的位置来设置附近物体的显示位置,这意味着附近物体的显示位置根据每个附近物体在空间中的位置而变得不同。根据这种构成,用户可以确认包括在拍摄的图像中的每个附近对象的位置。

[0191]

如上所述,显示控制单元170指示显示单元20显示由摄像单元11拍摄的图像信息g,并且指示显示单元20通过将识别信息g1和g2叠加在图像信息上来显示识别各个附近物体的识别信息g1和g2。根据这种构成,用户可以正确地确认包括在拍摄的图像中的每个附近对象的位置。

[0192]

如上所述,摄像装置1具备判定单元160,其在由距离信息获取单元13接收的光引起的蓄电量饱和并且摄像单元11中的像素的蓄电量不饱和时,判定有附近物体。

[0193]

根据这种构成,通过将附近物体与外部光的影响区分开,用户可以正确地确认附近物体是否被包括在拍摄的图像中。

[0194]

图9所示是本实施方式所涉及的第一变形例的摄像装置1的外观的示例。图10所示是本实施方式所涉及的第一变形例的处理电路的功能框图的一例。

[0195]

在第一变形例中,显示控制单元170从rgb图像数据获取单元142获取全景球面图像的rgb图像数据,并指示显示设备500的显示单元520基于所获取的全景球面图像的rgb图

像数据来显示二维图像信息。显示单元520是输出二维图像信息的输出目的地的一例。

[0196]

根据这种构成,用户可以从显示单元520显示的二维图像信息容易地确认拍摄的图像中是否包括用户自己、三脚架等,以及是否已经获取具有所期望的布局的三维信息。

[0197]

显示控制单元170将二维图像信息输出到与发送-接收单元180输出三维信息的外部装置300不同的显示单元520。

[0198]

根据这种构成,用户可以确认拍摄的图像中是否包括用户自己、三脚架等,以及从输出到不同于外部设备300的显示单元520的二维图像信息是否已经获取具有所期望的布局的三维信息,而无需确认输出到外部设备300的三维信息。

[0199]

此外,显示控制单元170可以被配置为从三维重构处理单元150获取或获得全景球面图像的三维数据,并且指示显示单元520显示三维信息。具体来说,显示控制单元170可以根据预设条件来选择显示控制单元170指示显示单元520显示二维图像信息的情况,以及显示控制单元170指示显示单元520显示三维信息的另一种情况。根据这种构成,显示控制单元170可以与三维信息分开地输出二维图像信息。

[0200]

显示控制单元170基于从判定单元160获取或获得的出错信息将出错信息叠加在二维图像信息上,并且指示显示单元520显示叠加有出错信息的二维图像信息。

[0201]

显示控制单元170基于从判定单元160获取或获得的像素的坐标位置信息,指示显示单元520显示叠加在二维图像信息上的标识附近物体的标识信息。

[0202]

即,显示控制单元170指示显示单元520根据基于从距离信息获取单元13接收的输出信息和摄像单元11的输出信息判定的附近对象的有无来输出不同的显示。

[0203]

根据这种构成,通过将附近物体与外部光的影响区分开,用户可以正确地确认用户自身以及附近物体(例如,三脚架)是否被包括在拍摄的图像中。

[0204]

如上所述,显示控制单元170指示显示单元520根据附近物体在空间中的位置来设置附近物体的显示位置,这意味着附近物体的显示位置根据每个附近物体在空间中的位置而变得不同。根据这种构成,用户可以确认包括在拍摄的图像中的每个附近对象的位置。

[0205]

显示控制单元170指示显示单元520显示由摄像单元11拍摄的图像信息g,并且还指示显示单元520通过将识别信息叠加在图像信息上来显示识别附近物体的识别信息。根据这种构成,用户可以正确地确认包括在拍摄的图像中的每个附近对象的位置。

[0206]

图11所示是本实施方式所涉及的第二变形例的摄像装置1的外观的示例。图12所示是本实施方式所涉及的第二变形例的处理电路的功能框图的一例。

[0207]

在图11所示的第二变形例中,摄像装置1例如具有多个显示单元20a、20a来代替图1所示的显示单元20。各显示单元20a、20a例如能够由发光二极管(led)等构成,并基于处理电路14的输出信号使光闪烁。

[0208]

显示单元20a设置在壳体10的第一面(例如,壳体10的前侧)上,并且显示单元20a设置在壳体10的第二面(例如,壳体10的后侧)上。

[0209]

在图12所示的第二变形例中,显示控制单元170指示显示单元20a、20a显示表示从判定单元160获取或获得的判定结果的信息或信号。例如,如果在摄像装置1的各侧上由靠近物体,则显示单元20a和20b可以闪烁红色。

[0210]

此外,发送-接收单元180经由网络400将从rgb图像数据获取单元142输出的全景球面图像的二维图像信息发送或输出到显示设备500。显示设备500是输出二维图像信息的

输出目的地的一例。

[0211]

即,关于第二变形例,在图5中的步骤s3中,发送-接收单元180从rgb图像数据获取单元142获取全景球面图像的rgb图像数据,然后将基于所获取的全景球面图像的rgb图像数据的二维图像信息发送或输出到显示设备500。

[0212]

显示设备500的发送-接收单元510接收从摄像装置1的发送-接收单元180发送来的二维图像信息。

[0213]

显示设备500的控制单元530指示显示单元520显示由发送-接收单元510接收的二维图像信息。

[0214]

如上所述,摄像装置1包括摄像单元11和与三维信息分开地输出由摄像单元11拍摄的二维图像信息的发送-接收单元180。

[0215]

根据这种构成,在不确认三维信息的情况下,用户可以从二维图像信息容易地确认拍摄的图像中是否包括用户自己、三脚架等,以及是否已经获取具有所期望的布局的三维信息。

[0216]

因此,用户可以在停留在获取或获得三维信息的地点的同时重新获取三维信息,相比于用户在离开获取三维信息的地点之后识别出拍摄的图像中包括用户自己、三脚架等或者没有获取或获得到具有期望布局的三维信息的情况,可以减少重新访问获取或获得三维信息的地点的工作或劳动。

[0217]

在步骤s11中发送或输出三维信息之前,发送-接收单元180在步骤s3中发送或输出二维图像信息g。此外,在步骤s10中三维重构处理单元150确定三维信息之前,发送-接收单元180在步骤s3中输出二维图像信息g。

[0218]

根据这种构成,在确认三维信息之前,用户可以从二维图像信息确认拍摄的图像中是否包括用户自己、三脚架等,以及是否已经获取具有所期望的布局的三维信息。

[0219]

发送-接收单元180将二维图像信息发送到显示设备500,并且显示设备500指示显示单元520显示二维图像信息。

[0220]

根据这种构成,用户可以从显示单元520显示的二维图像信息容易地确认拍摄的图像中是否包括用户自己、三脚架等,以及是否已经获取具有所期望的布局的三维信息。

[0221]

发送-接收单元180将二维图像信息发送到与输出三维信息的外部设备300不同的显示设备500。

[0222]

根据这种构成,用户可以确认拍摄的图像中是否包括用户自己、三脚架等,以及从输出到不同于外部设备300的显示单元520的二维图像信息是否已经获取具有所期望的布局的三维信息,而无需确认输出到外部设备300的三维信息。

[0223]

此外,发送-接收单元180可以被配置为将三维信息发送到显示设备500。具体来说,发送-接收单元180可以根据预设条件来选择发送-接收单元180将二维图像信息发送到显示设备500的情况,以及发送-接收单元180将三维信息发送到显示设备500的另一种情况。根据这种构成,发送-接收单元180可以将二维图像信息与三维信息分开地发送到显示设备500。

[0224]

图13所示是本实施方式所涉及的第二变形例的判定附近物体的流程图的示例。

[0225]

图13所示是第二变形例所涉及的判定附近物体是否包括在拍摄的图像中的处理的流程图,该处理对应于参照图5说明的步骤s9。

[0226]

判定单元160基于从再投影处理单元147获取或获得的全景球面图像的tof图像数据,判定全景球面图像的tof图像数据是否具有1个以上的蓄电量饱和的像素(步骤s811)。

[0227]

如果判定单元160在步骤s811中判定全景球面图像的tof图像数据具有1个以上的蓄电量饱和的像素(s811:"是"),基于从rgb图像数据获取单元142获取或获得的全景球面图像的rgb图像数据,判定单元160判定全景球面图像的rgb图像数据是否具有与在步骤s811中蓄电量饱和的像素为相同坐标的一个或多个像素,该像素具有饱和的蓄电量(步骤s812)。

[0228]

如果判定单元160在步骤s812中判定全景球面图像的rgb图像数据具有1个以上的蓄电量饱和的像素(s812:"是"),判定单元160判定在步骤s811中具有饱和的蓄电量的像素是由外部光引起的,并将出错信息输出到显示控制单元170。

[0229]

然后,基于从判定单元160获取或获得的出错信息,显示控制单元170将出错信息叠加到二维图像信息上,然后指示显示单元20a或显示单元20a显示出错信息(步骤s813)。

[0230]

如果判定单元160在步骤s812中判定全景球面图像的rgb图像数据不具有蓄电量饱和的像素(s812:"否"),判定单元160判定在步骤s801中具有饱和的蓄电量的像素是因附近物体引起的,并且在步骤s811中将具有饱和的蓄电量的像素的坐标位置信息输出到显示控制单元170。

[0231]

然后,显示控制单元170基于从判定单元160获取或获得的像素的坐标位置信息,判定坐标位置信息是否表示壳体10的前侧(步骤s814)。

[0232]

如果判定单元160在步骤s811中判定全景球面图像的tof图像数据没有蓄电量饱和的像素(s811:"否"),基于从再投影处理单元147获取或获得的全景球面图像的tof图像数据,判定单元160判定全景球面图像的tof图像数据是否具有表示全景球面图像的tof图像数据中的规定距离信息(例如0.5m以下)的一个或多个像素(步骤s815)。

[0233]

如果判定单元160在步骤s815中判定全景球面图像的tof图像数据没有表示规定距离信息(例如0.5m以下)的像素(s815:"否"),判定单元160结束该时序。

[0234]

如果判定单元160在步骤s815中判定全景球面图像的tof图像数据具有一个以上表示规定距离信息(例如0.5m以下)的像素(s815:"是"),判定单元160继续时序到步骤s814。

[0235]

如果步骤s815为"是",则判定单元160判定表示小于0.5m的距离信息的像素是由附近物体的存在引起的,并且在步骤s815中将表示小于0.5m的距离信息的像素的坐标位置信息输出到显示控制单元170。

[0236]

然后,在步骤s814,显示控制单元170基于从判定单元160获取或获得的像素的坐标位置信息,判定像素的坐标位置信息是否表示壳体10的前侧。

[0237]

如果显示控制单元170在步骤s814中判定像素的坐标位置信息表示前侧(s814:"是"),显示控制单元170指示配置在壳体10的前侧上的显示单元20a闪烁光(步骤s816)。

[0238]

如果显示控制单元170在步骤s814中判定像素的坐标位置信息不表示前侧(s814:"否"),显示控制单元170指示配置在壳体10的后侧上的显示单元20a闪烁光(步骤s817)。

[0239]

如上所述,当显示控制单元170判定有附近物体时,显示控制单元170指示显示单元20a或显示单元20a闪烁光,当显示控制单元170判定没有附近物体时,不指示显示单元

20a或显示单元20a闪烁光。

[0240]

也就是说,显示控制单元170指示显示单元20a或显示单元20a根据附近物体的有无来输出不同的显示。

[0241]

根据这种构成,通过将附近物体与外部光的影响区分开,用户可以正确地确认用户自身或附近物体(例如,三脚架)是否被包括在拍摄的图像中。

[0242]

此外,显示控制单元170基于从判定单元160获取或获得的像素的坐标位置信息来指示显示单元20a或显示单元20a闪烁光。

[0243]

也就是说,显示控制单元170指示显示单元20a或显示单元20a根据附近物体在空间中的位置来显示附近物体的位置,这意味着附近物体的位置根据每个附近物体在空间中的位置而不同地显示。根据这种构成,用户可以确认包括在拍摄的图像中的每个附近对象的位置。

[0244]

然后,显示控制单元170指示显示单元20a、20a中更靠近附近物体的任一个,根据附近物体的有无来输出不同的显示。根据这种构成,用户可以正确地确认包括在拍摄的图像中的特定对象的位置。

[0245]

图14所示是本实施方式所涉及的第三变形例的摄像装置1的构成的剖视图。

[0246]

在图14所示的第三变形例中,除了图2所示的构成之外,摄像装置1还包括例如具有另一摄像元件111a、111a以及另一鱼眼透镜(广角透镜)111b、111b的另一摄像单元111。

[0247]

在第三变形例中,rgb摄像单元11和另一摄像单元111被设置在同一基线上。在该构成中,处理电路14能够对具有多眼的构成执行处理。也就是说,可以通过同时驱动摄像单元11和另一摄像单元111来获取或获得两个视点的rgb图像,其中沿着一个面在摄像单元11和另一摄像单元111之间设有规定的预设距离。因此,可以使用从两个rgb图像计算的视差,并可以提高整个测量范围的距离精度。

[0248]

具体来说,当设置摄像单元11和用于拍摄rgb图像数据的另一摄像单元111时,可以如传统的视差计算那样,使用利用了平方差之和(ssd)的多基线立体(msb)和核极线平面图(epi)处理。因此,通过使用摄像单元11和另一摄像单元111,可以增加视差的可靠性,并且可以实现高的空间分辨率和高精度。

[0249]

如上所述,摄像装置1包括另一摄像单元111,以及基于从距离信息获取单元13接收的输出信息、二维图像信息和由另一摄像单元111拍摄的另一二维图像信息来确定三维信息的三维重构处理单元150。

[0250]

此外,摄像装置1可以包括另一摄像单元111和基于二维图像信息以及由另一摄像单元111拍摄的另一二维图像信息来确定三维信息的三维信息确定单元,而不使用来自距离信息获取单元13的输出信息。

[0251]

根据这种构成,用户可以确认拍摄的图像中是否包括用户自己、三脚架等,以及从摄像单元11拍摄的二维图像信息是否已经获取具有所期望的布局的三维信息,而无需基于二维图像信息来确认由三维重构处理单元150确定的三维信息。

[0252]

关于上述实施方式,摄像装置1(信息处理装置的一例)包括拍摄二维图像信息的摄像单元11、输出用于显示的二维图像信息g的输出单元,以及与二维图像信息的坐标相关联的三维信息。

[0253]

输出单元可以被实现为显示控制单元170。在这种情况下,显示控制单元170输出

用于显示的二维图像信息和三维信息。

[0254]

此外,输出单元可以被实现为发送-接收单元180。在这种情况下,发送-接收单元180将用于显示的二维图像信息输出到外部设备,并且将三维信息输出到外部设备。

[0255]

此外,输出单元可以被实现为显示控制单元170和发送-接收单元180。在这种情况下,显示控制单元170输出用于显示的二维图像信息,发送-接收单元180将三维信息输出到外部设备。可替换地,显示控制单元170将三维信息输出到外部设备,发送-接收单元180输出用于显示的二维图像信息。

[0256]

根据这种构成,在不确认三维信息的情况下,用户可以从二维图像信息容易地确认拍摄的图像中是否包括用户自己、三脚架等,以及是否已经获取具有所期望的布局的三维信息。

[0257]

因此,用户可以在停留在获取或获得三维信息的地点的同时重新获取三维信息,相比于用户在离开获取三维信息的地点之后识别出拍摄的图像中包括用户自己、三脚架等或者没有获取或获得到具有期望布局的三维信息的情况,可以减少重新访问获取或获得三维信息的地点的工作或劳动。

[0258]

显示控制单元170或发送-接收单元180在输出三维信息之前输出二维图像信息g。此外,显示控制单元170或发送-接收单元180在确定三维信息之前输出二维图像信息g。

[0259]

根据这种构成,在确认三维信息之前,用户可以从二维图像信息确认拍摄的图像中是否包括用户自己、三脚架等,以及是否已经获取具有所期望的布局的三维信息。

[0260]

显示控制单元170指示显示单元20和显示单元520显示二维图像信息g。摄像装置1具备显示单元20。

[0261]

根据这种构成,用户可以从显示单元显示的二维图像信息容易地确认拍摄的图像中是否包括用户自己、三脚架等,以及是否已经获取具有所期望的布局的三维信息。

[0262]

显示控制单元170或发送-接收单元180将二维图像信息g输出到与输出三维信息的外部设备300(输出目的地的一例)为不同的显示单元20和显示单元520(输出目的地的一例)。

[0263]

根据这种构成,用户可以确认拍摄的图像中是否包括用户自己、三脚架等,以及从输出到不同于外部设备300的显示单元20和显示单元520的二维图像信息是否已经获取具有所期望的布局的三维信息,而无需确认输出到外部设备300(输出目的地的一例)的三维信息。

[0264]

摄像装置1包括用于将光投影到目标物上的投影单元12、用于接收从目标物反射的光的距离信息获取单元13(受光单元的一例),以及用于基于从距离信息获取单元13接收的输出信息来确定三维信息的三维重构处理单元150(三维信息确定单元的一例)。三维重构处理单元150基于从距离信息获取单元13接收到的输出信息和二维图像信息来确定三维信息。

[0265]

根据这种构成,用户可以确认拍摄的图像中是否包括用户自己、三脚架等,以及从摄像单元11拍摄的二维图像信息是否已经获取具有所期望的布局的三维信息,而无需确认由三维重构处理单元150确定的三维信息。

[0266]

摄像装置1包括另一摄像单元111,以及基于从距离信息获取单元13接收的输出信息、二维图像信息和由另一摄像单元111拍摄的另一二维图像信息来确定三维信息的三维

重构处理单元150。

[0267]

如上所述,摄像装置1可以包括另一摄像单元111和基于二维图像信息以及由另一摄像单元111拍摄的另一二维图像信息来确定三维信息的三维信息确定单元,而不使用来自距离信息获取单元13的输出信息。

[0268]

根据这种构成,用户可以确认拍摄的图像中是否包括用户自己、三脚架等,以及从摄像单元11拍摄的二维图像信息是否已经获取具有所期望的布局的三维信息,而无需基于二维图像信息来确认由三维重构处理单元150确定的三维信息。

[0269]

三维信息包括例如全景球面三维信息。在这种情况下,即使用户难以确认拍摄的图像中是否包括用户自己、三脚架等,以及在全景球面三维信息中是否已经获取具有所期望的布局的三维信息,则用户可以从摄像单元11拍摄的二维图像信息容易地确认拍摄的图像中是否包括用户自己、三脚架等,以及是否已经获取具有所期望的布局的三维信息。

[0270]

关于上述实施方式,摄像装置1(信息处理装置的一例)包括拍摄目标物的图像的摄像单元11、将光投影到目标物上的投影单元12、接收从目标物反射的光的距离信息获取单元13(受光单元的一例),以及指示显示单元20和显示单元520根据基于距离信息获取单元13的输出信息和摄像单元11的输出信息判定的特定对象的有无来输出不同的显示的显示控制单元170。

[0271]

根据这种构成,用户可以通过区分特定对象与外部光的影响来正确地确认拍摄的图像中是否包括特定对象,诸如用户自己或附近物体(例如,三脚架)。

[0272]

摄像装置1包括显示单元20。根据这种构成,用户可以正确地确认特定对象是否包括在拍摄的图像中。

[0273]

也就是说,显示控制单元170指示显示单元20和显示单元520根据特定对象在空间中的位置来设置特定对象的显示位置,这意味着每个特定对象的显示位置根据每个特定对象在空间中的位置而变得不同。根据这种构成,用户可以正确地确认包括在拍摄的图像中的特定对象的位置。

[0274]

显示单元20包括多个显示单元20a、20a。也就是说,显示控制单元170指示靠近附近物体的显示单元20a或显示单元20a根据特定对象的有无来输出不同的显示。根据这种构成,用户可以正确地确认包括在拍摄的图像中的特定对象的位置。

[0275]

显示控制单元170指示显示单元20和显示单元520显示由摄像单元11拍摄的图像信息g,并且指示显示单元20和显示单元520通过将识别信息g1和g2叠加在图像信息g上来显示识别特定对象的识别信息g1和g2。根据这种构成,用户可以正确地确认包括在拍摄的图像中的特定对象的位置。

[0276]

摄像装置1具备判定单元160,其在由距离信息获取单元13接收的光引起的蓄电量饱和并且摄像单元11中的像素的蓄电量不饱和时,判定有特定对象。

[0277]

根据这种构成,通过将特定对象与外部光的影响区分开,用户可以正确地确认特定对象是否被包括在拍摄的图像中。

[0278]

另外,上述实施例的每个功能可以通过一个或多个处理电路或电路来实现。处理电路包括编程的处理器,处理器包括电路系统。处理电路还包含专用集成电路(asic)、数字信号处理器(dsp)、现场可编程门阵列(fpga)和布置为执行所述功能的常规电路元件等设备。用于执行上述实施例的程序可以被存储在载体装置或存储介质中。

[0279]

本专利申请基于并要求2020年3月23日向日本专利局提交的日本专利申请no.2020-050539和2020年3月23日向日本专利局提交的日本专利申请no.2020-050608的优先权,其全部公开内容通过引用合并于此。

[0280]

附图标记列表

[0281]

1 摄像装置(信息处理装置的示例/实施例)

[0282]

10 壳体

[0283]

11 摄像单元

[0284]

11a、11a 摄像元件

[0285]

11b、11b 鱼眼透镜

[0286]

12 投影单元

[0287]

12a、12a 光源单元

[0288]

12b、12b 广角透镜

[0289]

13 距离信息获取单元(受光单元的示例)

[0290]

13a、13a tof传感器

[0291]

13b、13b 广角透镜

[0292]

14 处理电路

[0293]

15 摄像开关

[0294]

20 显示单元

[0295]

20a、20a 显示单元

[0296]

111 另一摄像单元

[0297]

150 三维重构处理单元(三维信息确定单元的示例)

[0298]

160 判定单元

[0299]

170 显示控制单元(输出单元的示例)

[0300]

180 发送-接收单元(输出单元的示例)

[0301]

300 外部设备(输出目的地的示例)

[0302]

500 显示装置(输出目的地的示例)

[0303]

520 显示单元(输出目的地的示例)

[0304]

l 同步信号线。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1