多机位视频同步方法和系统以及计算机程序产品与流程

1.本发明涉及一种多机位视频同步方法和系统以及计算机程序产品。

背景技术:

2.对同一活动场景进行多机位直播时,由于多个视频采集设备的型号、编码格式、传输方式以及网络波动等原因,会导致视频流不同步。另一种场景是,对同一活动进行的实时录制的视频因为同样的原因,导致后期的视频合成等制作中存在视频不同步的问题。因此,亟需一种可以对多机位视频进行同步的技术。

3.这种问题在体育直播场景中尤为显著。体育直播中常常需要多个摄像机的视频流保持同步,否则在切换视频流时会由于不同步导致画面跳动。传统的视频同步方法是通过硬件设备提供同步信号来同步,用于同步设备的线缆经常有上百米,这种方法设备笨重,成本高;另一种是用专用编码器设备将同步时间戳写入视频流,这种方法增加了专用编码器硬件的成本,无法解决拍摄设备到编码器之间的延时造成的不同步;另外一些方法是在直播开始前进行同步调节,包括用人工调节、数字时钟画面同步等方法,这种方法不能解决直播过程由于网络波动等各种原因造成的视频流不同步。

4.专利文献1中记载一种在场景中植入编码显示的方法用于视频同步,但是该方法硬件成本高,依赖对场景的现实布置。

5.专利文献2中提出一种利用目标分布的匹配来进行视频同步的方法,该专利虽然针对多个摄像头,但基本适合于从同一方向(机位)的拍摄,不适用于多机位拍摄角度差异大,不同物体在从三维空间向二维空间投影时分布的准确度受到较大影响的场景。

6.专利文献1: 中国专利公开cn108055423。

7.专利文献2: 中国专利公开cn112449152。

技术实现要素:

8.本发明鉴于以上问题进行了研发,目的在于提供一种多机位视频同步方法和系统,能够用于便捷独立地实现多机位视频的同步。

9.提供一种多机位视频同步方法,包括:获取多机位视频数据,所述多机位视频数据来自具有共视区域的多机位拍摄;确定多机位视频数据中的目标的运动轨迹,通过各机位视频数据间运动轨迹的动态时间归整来确定所述多机位视频的时间差。

10.优选地,所述确定多机位视频数据中的目标的运动轨迹包括:检测各机位视频数据中的目标,并获取目标的追踪时序数据;向各机位视频数据的同一参照系投影追踪时序数据,获得目标运动轨迹的归一化时序数据。

11.优选地,所述参照系是所述共视区域中的一条基准线。

12.优选地,所述参照系是所述共视区域中的一个基准点。

13.优选地,所述通过各机位视频数据间运动轨迹的动态时间归整来确定所述多机位视频的时间差包括:在各机位视频数据之间对归一化时序数据进行目标匹配;对各机位视频数据间匹配的归一化时序数据进行动态时间归整来获得各机位视频的时间差。

14.优选地,所述对各机位视频数据间匹配的归一化时序数据进行动态时间归整包括:在任意两机位视频数据间对匹配的归一化时序数据任意确定起点和终点获得各归一化时序数据的多段截断时序数据;计算任意匹配的两组归一化时序数据间各段截断时序数据的矢量距离,获得矢量距离最短的截断时序数据配对;计算配对截断时序数据的起点时间的差值。

15.优选地,所述获得目标运动轨迹的归一化时序数据还包括将归一化时序数据中目标遮挡时段的两端坐标进行线性连接;所述对各机位视频数据间匹配的归一化时序数据进行动态时间归整还包括对基于包含进行了线性连接处理的部分的截断时序数据计算的矢量距离加权范围在0《ρ≤0.001的极小值系数。

16.优选地,还包括计算通过多个目标的各机位视频数据间归一化时序数据的动态时间归整来确定的平均时间差。

17.优选地,还包括对所述平均时间差进行量化处理。

18.优选地,根据量化处理的平均时间差矫正多机位视频的时间戳。

19.提供一种多机位视频同步系统,包括:处理器;存储器;和存储在所述存储器中的计算机程序指令,在所述计算机程序指令被所述处理器运行时执行上述任一项所述的多机位视频同步方法。

20.提供一种多机位视频同步系统,包括:处理器;存储器;和存储在所述存储器中的计算机程序指令,在所述计算机程序指令被所述处理器运行时执行:获取多机位视频数据,所述多机位视频数据来自具有共视区域的多机位拍摄;确定多机位视频数据中的目标的运动轨迹,通过各机位视频数据间运动轨迹的动态时间归整来确定所述多机位视频的时间差。

21.优选地,在所述计算机程序指令被所述处理器运行时执行所述确定多机位视频数据中的目标的运动轨迹包括:检测各机位视频数据中的目标,并获取目标的追踪时序数据;向各机位视频数据的同一参照系投影追踪时序数据,获得目标运动轨迹的归一化时序数据。

22.优选地,所述参照系是所述共视区域中的一条基准线。

23.优选地,所述参照系是所述共视区域中的一个基准点。

24.优选地,在所述计算机程序指令被所述处理器运行时执行所述通过各机位视频数

据间运动轨迹的动态时间归整来确定所述多机位视频的时间差包括:在各机位视频数据之间对归一化时序数据进行目标匹配;对各机位视频数据间匹配的归一化时序数据进行动态时间归整来获得各机位视频的时间差。

25.优选地,在所述计算机程序指令被所述处理器运行时执行所述对各机位视频数据间匹配的归一化时序数据进行动态时间归整包括:在任意两机位视频数据间对匹配的归一化时序数据任意确定起点和终点获得各归一化时序数据的多段截断时序数据;计算任意匹配的两组归一化时序数据间各段截断时序数据的矢量距离,获得矢量距离最短的截断时序数据配对;计算配对截断时序数据的起点时间的差值。

26.优选地,在所述计算机程序指令被所述处理器运行时执行所述获得目标运动轨迹的归一化时序数据还包括将归一化时序数据中目标遮挡时段的两端坐标进行线性连接;在所述计算机程序指令被所述处理器运行时执行所述对各机位视频数据间匹配的归一化时序数据进行动态时间归整还包括对基于包含进行了线性连接处理的部分的截断时序数据计算的矢量距离加权范围在0《ρ≤0.001的极小值系数。

27.优选地,还执行计算通过多个目标的各机位视频数据间归一化时序数据的动态时间归整来确定的平均时间差。

28.优选地,还执行对所述平均时间差进行量化处理。

29.优选地,根据量化处理的平均时间差矫正多机位视频的时间戳。

30.提供一种计算机程序产品,包括计算机可读存储介质,在所述计算机可读存储介质上存储了计算机程序指令,所述计算机程序指令在被计算机运行时执行上述任一项所述的多机位视频同步方法。

31.提供一种计算机程序产品,包括计算机可读存储介质,在所述计算机可读存储介质上存储了计算机程序指令,所述计算机程序指令在被计算机运行时执行:获取多机位视频数据,所述多机位视频数据来自具有共视区域的多机位拍摄;确定多机位视频数据中的目标的运动轨迹,通过各机位视频数据间运动轨迹的动态时间归整来确定所述多机位视频的时间差。

32.优选地,所述计算机程序指令在被计算机运行时执行所述确定多机位视频数据中的目标的运动轨迹包括:检测各机位视频数据中的目标,并获取目标的追踪时序数据;向各机位视频数据的同一参照系投影追踪时序数据,获得目标运动轨迹的归一化时序数据。

33.优选地,所述参照系是所述共视区域中的一条基准线。

34.优选地,所述参照系是所述共视区域中的一个基准点。

35.优选地,所述计算机程序指令在被计算机运行时执行所述通过各机位视频数据间运动轨迹的动态时间归整来确定所述多机位视频的时间差包括:在各机位视频数据之间对归一化时序数据进行目标匹配;对各机位视频数据间匹配的归一化时序数据进行动态时间归整来获得各机位视频的时间差。

36.优选地,所述计算机程序指令在被计算机运行时执行所述对各机位视频数据间匹配的归一化时序数据进行动态时间归整包括:在任意两机位视频数据间对匹配的归一化时序数据任意确定起点和终点获得各归一化时序数据的多段截断时序数据;计算任意匹配的两组归一化时序数据间各段截断时序数据的矢量距离,获得矢量距离最短的截断时序数据配对;计算配对截断时序数据的起点时间的差值。

37.优选地,所述计算机程序指令在被计算机运行时执行所述获得目标运动轨迹的归一化时序数据还包括将归一化时序数据中目标遮挡时段的两端坐标进行线性连接;所述计算机程序指令在被计算机运行时执行所述对各机位视频数据间匹配的归一化时序数据进行动态时间归整还包括对基于包含进行了线性连接处理的部分的截断时序数据计算的矢量距离加权范围在0《ρ≤0.001的极小值系数。

38.优选地,还执行计算通过多个目标的各机位视频数据间归一化时序数据的动态时间归整来确定的平均时间差。

39.优选地,还执行对所述平均时间差进行量化处理。

40.优选地,根据量化处理的平均时间差矫正多机位视频的时间戳。

41.根据本发明,可以用于便捷独立地实现多机位视频的同步,并且不依赖于拍摄配置数据,也不需要进行复杂的坐标系变换。

附图说明

42.通过结合附图对本发明实施例进行更详细的描述,本发明的上述以及其它目的、特征和优势将变得更加明显。附图用来提供对本发明实施例的进一步理解,并且构成说明书的一部分,与本发明实施例一起用于解释本发明,并不构成对本发明的限制。在附图中,相同的参考标号通常代表相同部件或步骤。

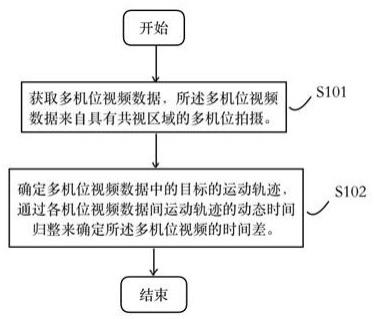

43.图1是图示本发明实施例的多机位视频同步处理的流程图。

44.图2是图示本发明实施例的多机位视频同步系统的功能性框图。

45.图3是图示本发明实施例的多机位视频同步方法中确定目标运动轨迹的归一化时序数据的流程图。

46.图4是图示本发明实施例的多机位视频同步方法中某一目标的追踪时序数据进行归一化处理获得的归一化时序数据的曲线图。

47.图5是图示本发明实施例的多机位视频同步方法中归一化运动轨迹的动态时间归整的流程图。

48.图6是图示本发明实施例的多机位视频同步方法中归一化运动轨迹的动态时间归整计算的示意图。

49.图7是图示本发明实施例的多机位视频同步系统的示意性框图。

50.图8是图示本发明实施例的多机位视频同步系统整合于播放器终端的情况下的播放器的构成图。

51.图9a是图示篮球赛事直播场景中拍摄区域重叠的示意图。

52.图9b是图示主机位镜头中的篮球赛场的参照线的示意图。

53.图9c是图示左机位镜头中的篮球赛场的参照线的示意图。

54.图10a、10b是本发明例示篮球赛事直播视频同步处理的流程图。

55.要理解的是,前面的一般描述和下面的详细描述两者都是示例性的,并且意图在于提供要求保护的技术的进一步说明。

具体实施方式

56.为了使得本发明的目的、技术方案和优点更为明显,下面将参照附图详细描述根据本发明的示例实施例。显然,所描述的实施例仅仅是本发明的一部分实施例,而不是本发明的全部实施例,应理解,本发明不受这里描述的示例实施例的限制。基于本公开中描述的本发明实施例,本领域技术人员在没有付出创造性劳动的情况下所得到的所有其它实施例都应落入本发明的保护范围之内。

57.以下,将参考附图详细描述本发明的优选实施例。

58.图1是图示根据本发明实施例的视频同步处理的流程图。如图1所示,根据本发明在步骤s101中,获取多机位视频数据,所述多机位视频数据来自具有共视区域的多机位拍摄。多机位拍摄是由物理位置上分离配置的视频采集装置从多角度对同一活动场景进行实时拍摄。在本发明的一个实施例中,所述视频采集装置为能够获取被摄场景的视频数据的摄像机或摄像头。获取多机位视频数据包括但不限于,在由多机位拍摄采集视频数据之后,经由有线或者无线方式从多机位接收视频数据。具有共视区域是指多机位具有重叠拍摄视野。此后,处理进到步骤s102。

59.在步骤s102中,确定多机位视频数据中的目标的运动轨迹,通过各机位视频数据间运动轨迹的动态时间归整来确定所述多机位视频的时间差。所述目标是指活动场景中的运动对象,在一个示例场景中,可以是篮球比赛中的运动员或篮球。所述运动轨迹是指表示目标轨迹变化的时序坐标数据。在各机位视频数据间对目标移动的时序坐标数据进行动态时间归整,从而将任意目标在不同机位视频数据中的轨迹时间序列拉齐,从而确定多机位视频的时间差。时间差可以发送给前端或数据中心用于矫正时间戳或生成同步视频,也可以当即对在处理的多机位视频进行时间戳矫正。时间差的计算结果也可以作为监视多机位视频是否存在不同步的校量值,通过与阈值进行比对来判断是否发生不同步。

60.以下,将参照图2进一步描述执行上述视频同步方法的多机位视频同步系统。

61.图2是图示根据本发明实施例的多机位视频同步系统的功能性框图。如图2所示,根据本发明实施例的包括视频数据获取模块21和视22。例如可以由诸如硬件(服务器、专用计算机等)、软固件及它们的任意可行的组合配置。

62.具体地,所述视频数据获取模块21用于获取多机位视频数据,所述多机位视频数据来自具有共视区域的多机位拍摄。多机位拍摄是指由物理位置上分离配置的视频采集装置对同一活动场景进行实时静态拍摄。在本发明的一个实施例中,所述视频采集装置为能够获取被摄场景的视频数据的摄像机或摄像头。获取多机位视频数据包括但不限于,在由多机位拍摄采集视频数据之后,经由有线或者无线方式从多机位接收视频数据。具有共视区域是指多机位具有重叠拍摄视野。

63.视频数据同步模块22用于确定多机位视频数据中的目标的运动轨迹,通过各机位视频数据间运动轨迹的动态时间归整来确定所述多机位视频的时间差。所述目标是指活动场景中的运动对象,在一个示例场景中,可以是篮球比赛中的运动员或篮球。所述运动轨迹

是表示目标轨迹变化的时序坐标数据。在各机位视频数据间对目标移动的时序坐标数据进行动态时间归整,从而将任意目标在不同机位视频数据中的轨迹时间序列拉齐,从而确定多机位视频的时间差。时间差可以发送给前端或数据中心用于矫正时间戳或生成同步视频,也可以当即对在处理的多机位视频进行时间戳矫正。该时间差的计算值也可以作为监视多机位视频是否存在不同步的校量值,通过与阈值进行比对来判断是否发生不同步。

64.以下,将进一步参照附图详细描述由根据本发明实施例的多机位视频同步系统的各个模块执行的根据本发明实施例的视频同步方法的各个具体步骤流程。

65.图3是进一步图示根据本发明实施例的多机位视频同步方法中确定相对运动轨迹的流程图。如图3所示,根据本发明实施例的多机位视频同步方法中确定相对运动轨迹的流程包括以下步骤。

66.在步骤s301中,检测各机位视频数据中的目标,并获取目标的追踪时序数据。在一个实施例中,可以使用预先训练好的检测器(诸如yolov5(you only look once v5,一阶段统一实时目标检测v5)、fasterr-cnn(faster region convolutional neural network,区域卷积神经网络)、ssd (single shot multi-box detector,单镜头多盒检测器)模型)对多机位视频数据进行目标检测,以获取任意目标的位置和特征。

67.在一个实施例中,对每一帧图像找到目标对象,通过边框把目标对象的位置和大小表示出来。边框也叫边界框(boundingbox),可以是矩形框、圆形框、椭圆框等,作为一个优选例,边框由四角位置坐标表示,例如p={(x[i],y[i])|i=1..4},其中(x[i],y[i])是第i个关键点的位置。以下用px(i,t)和py(i,t)来表示t时刻目标第i个关键点的x和y坐标。四角坐标可以单独或整体作为目标的位置,也可以计算边框中心坐标p={(x[1]+x[2])/2,(y[1]+y[3])/2}作为目标的位置。四角坐标可以计算出边框的面积和长宽比等作为目标的外观特征。某些场景下用来表示人物目标的身体区域,例如在混杂的场地活动中可以确定移动人物的肩宽,在更大型的比赛中例如足球比赛场景下可以确定移动人物的全身。在一个实施例中可以包括目标分类,通过目标类型将检测框分成对象框、字符框或编码框,进一步通过预定的物理间距判定,将对象框与字符框或编码框关联起来,从而将关联信息作为目标的特征信息。在一种存在跑动的实施例中,还可以通过边框把目标对象的步伐表示出来,从而应对运动速度较快的场景。由此将目标的空间位置和运动/外观相似程度因素关联。

[0068]

目标的追踪方法可以不做限定,可以进行单目标追踪,也可进行多目标追踪来获取追踪时序数据,在多目标检测的基础上,可使用mot(multipleobjecttracking)多目标追踪法。作为一般示例,根据取得的外观特征和/或运动特征进行相似度计算,计算前后帧目标间的距离,属同一目标的情况下距离较小,从而进行数据关联并分配目标身份。

[0069]

另外,多目标追踪可以基于model-free进行,但根据不同场景,为实现对追踪过程中新检测出的目标进行追踪,也可以选用基于tracking-by-detection的追踪算法。因此所述检测各机位视频数据中的目标,并获取目标的追踪时序数据应被认为既包含分步处理,也包含处理间的交织和同步进行。

[0070]

作为tracking-by-detection的检测追踪方法,可示例sort(simpleonlineandrealtimetracking)和deepsort(simple online and realtime tracking with a deep association metric)。在该类策略的算法中,利用卡尔曼滤波器获得目标的预测轨迹,利用匈牙利算法将预测值和检测值进行数据关联,利用卡尔曼滤波

器对全部轨迹进行更新。在所述数据关联中,sort追踪应用iou快速实现预测状态与检测状态的匹配,deepsort追踪在sort的基础上增加级联匹配,通过reid模块集成表面特征,能够更好地处理目标被长时间遮挡的情况,避免频繁进行身份更迭。因此优选采用deepsort追踪适用于赛事直播或网络在线领域的目标追踪处理技术,采用deepsort技术能够更适合目标被长时间遮挡的场景。

[0071]

通过以上示例方法,可获得任意或全部目标在不同视频帧中的坐标位置的追踪时序数据t(i)={px(i,t),py(i,t)|i=1..4}。在另一个可供选择的实施例中,通过sift(scale-invariant feature transform:尺度不变特征变换)等方法,在目标检测框内提取角点,获取不同视频帧中相同目标的相同角点的坐标的追踪时序数据t

cor

(x,y,t)。此后,处理进到步骤s302。

[0072]

在步骤s302中,向各机位视频数据的同一参照系投影追踪时序数据,获得目标的运动轨迹的归一化时序数据。在各类多机位拍摄中,所获的目标位置信息一般是二维的坐标数据,为优化对时间规整计算的适应,还可对步骤s301中获得的追踪时序信息进行归一化计算,以算得单维坐标的时序数据。

[0073]

本实施例中,将追踪时序数据向各机位视频数据的同一参照系投影以获得目标运动轨迹的归一化时序数据。所谓向参照系投影应当理解为一种形象的数学描述,不局限于狭义的几何运算,还包含或等同地对应一般代数运算和矩阵计算,只要能够获得反应追踪目标现实的轨迹曲线特征的一维时序数列的方法都应该视为包含在该投影运算的概念当中。

[0074]

同一参照系是指各机位视频数据中应用相同的参照系。相同的参照系既指参照系本身相同,又指参照物的标度相同。参照系在一些实际应用中可以根据机位角度和运动方向来确定,在一个适合的实施例中,运动方向(例如比赛的对抗方向)的规律倾向于沿场地纵横趋向时,可以以场地的边线作为参照系,此时机位可以与参照系方向成较大的配置角度,例如垂直于边线。在另一个实施例中,例如篮球比赛中一机位悬挂于篮筐后方的高位,参照线选择球场的横向边线或中线。在另一适合的实施例中,运动方向的规律是环绕场地中心的运动趋向时,可以以场地的中心点为参照系。投影坐标在不同的参照系种类下可以是距离坐标或角度坐标。实际上,参照系的确定可以是任意的,因此不需要预设,但是一个优选例是在接收到视频数据后通过计算机视觉自动识别活动场景的边线作为参照线,例如对于篮球比赛,直接以球场的边线作为参照线。体育赛事中使用的摄像机往往多采用移动式摄像机,例如中线主机位采用的升降式,又例如飞猫,采用计算机视觉自动识别现场参照系使得本实施例方法更好地适用于拍摄视野存在变换的赛事拍摄。

[0075]

在此分别说明参照系采用基准线和基准点两种情况的投影计算示例。为了方便计算,例如在篮球比赛的场景中,将步骤s301中获得的作为时间序列的追踪时序数据例如t

cor

(x,y,t)投影到该基准线上,获得在基准线上的像素坐标。具体地,这种采用边线为基准线的情况下可以方便地应用垂直投影,这种情况下目标位置的x坐标和基准线上的投影对应的x坐标相同,只需计算x坐标与参照线上的预设原点xo的x坐标的差值x’求差作为归一化时序数据的x坐标值。如此获得某一目标运动在基准线上投影的时序轨迹数据t

x

={x’(t)}。以时间t为横坐标,以x为纵坐标,则如图4所示,由此获得某一目标的归一化运动轨迹(图中虚线表示目标被遮挡)。在非垂直投影的情况下,仍然可以进行位置换算获得以时间t为横

坐标,以x为纵坐标的时序轨迹数据。仍然以篮球比赛的场景为例,以球场中心点{p(x),p(y)}为参照系,并以该中心点为相对原点,计算步骤s301中获得的带有时间序列的追踪数据t(cor)={px(cor,t),py(cor,t)}相对该相对原点的夹角数据ω,由此获得某一目标运动在基准点上的时序轨迹数据ω={ω(t)}。ω的计算公式为ω=arctanx{[px(cor,t)-p(x)]/[py(cor,t)-p(y)]}。由此以时间t为横坐标,以ω为纵坐标,即获得基于角度相对参照的某一目标的归一化运动轨迹。

[0076]

归一化运动轨迹不依赖于宇宙坐标系,体现相机坐标系中运动对象相对于参照系的轨迹变化。在此,各机位视频数据间归一化运动轨迹可以是一个运动目标也可以是多个运动目标的归一化时序数据,并且一般应取足够长时间例如在1min以上,通过不同机位的视频数据间归一化运动轨迹进行动态时间归整,可以计算出最高相似度,从而拉齐运动轨迹的时序,进而得到多机位视频的时间差。时间差可以发送给前端或数据中心用于矫正时间戳或生成同步视频,也可以当即对在处理的多机位视频进行时间戳矫正。

[0077]

所述获得目标运动轨迹的归一化时序数据还可以包括将归一化时序数据中目标遮挡时段的两端坐标进行线性连接。图4的虚线部分表示目标被遮挡,该处理方式是将遮挡时段的始端和终端进行直线连接,获得该目标的归一化运动轨迹。线性连接应当理解是,在数值计算上坐标x从遮挡时段的起始时刻到终止时刻的匀速变化。

[0078]

图5是进一步图示根据本发明实施例的多机位视频同步方法中归一化运动轨迹的动态时间归整的流程图。如图5所示,根据本发明实施例的多机位视频同步方法中归一化运动轨迹的动态时间归整的流程包括以下步骤。

[0079]

在步骤s501中,在各机位视频数据之间对归一化时序数据进行目标匹配。所述对归一化时序数据进行目标匹配是将同一目标的归一化时序数据进行匹配。本实施例中,通过匹配不同机位视频数据中的同一目标,从而匹配同一目标在各机位视频数据中的相对运动轨迹。所述匹配各机位视频数据之间的同一目标是对各机位视频中的目标进行身份匹配,确定相同目标。所述身份匹配是对具有识别特征的目标进行匹配,对于同质化的运动目标进行丢弃处理或者选择跟踪时间最长的目标。例如在球类比赛的场景中,包含多个球员和一个球体,通过神经网络生成人体id,对于球体保留跟踪时间最长的那个球体(一种情景是场内进入第二个球或拍摄到换球的过程)。通过神经网络生成人体id可以采用用于人脸或体型等特征识别的卷积网络,也可以关联球场这种特殊场景下的号牌等特征确定目标身份。通过计算id间的匹配相似度,来确定匹配是否成功。该实施方式虽然在进行归一化运动轨迹的动态时间归整之前对各机位视频数据之间的同一目标进行匹配,但根据不同的目标检测手段也可以适时地提前于目标检测阶段,待取得归一化运动轨迹后自然将归一化时序数据匹配于一起。此后处理进到步骤s502。

[0080]

在步骤s502中,对各机位视频数据间匹配的归一化时序数据进行动态时间归整来获得各机位视频的时间差。通过步骤s302对各机位视频数据中的各检测目标获得作为一串时间序列数据的归一化运动轨迹,通过步骤s501中对同一目标进行匹配后,获得相同目标在不同机位视频中的归一化时序数据,进一步地在该步骤s502中对多机位间的归一化时序数据进行动态时间归整计算,将不同机位间运动轨迹数据的时间序列拉齐获得不同机位间运动轨迹的时间差。

[0081]

本领域技术人员应当理解,在实际的计算中,动态时间归整采用了对两组时序数

据进行计算,对于三机位以上视频之间的处理,可通过两两机位间目标匹配和匹配目标的动态时间归整来获得各机位间的时间差。

[0082]

所述对各机位视频数据间匹配的归一化时序数据进行动态时间归整包括:在任意两机位视频数据间对匹配的归一化时序数据任意确定起点和终点获得各归一化时序数据的多段截断时序数据;计算任意匹配的两组归一化时序数据间各段截断时序数据的矢量距离,获得矢量距离最短的截断时序数据配对;计算配对截断时序数据的起点时间的差值。

[0083]

在一个具体实施例中,使用dtw(dynamic time warping,动态时间归整)对身份匹配后的孤立时序数据进行相似计算,如图6所示归一化运动轨迹的动态时间归整计算的示意图,以两组时序数据t(m),t’(n)为例进行说明。通过任意确定起点和终点得到两组截断时序数据,各截断时序数据表示为t={t(m1),t(m2),

…

,t(m)},m为时序标号,m1为起点帧,m为终点帧;t’={t’(n1),t’(n2),

…

,t’(n)},n为时序标号,n1为起点帧,n为终点帧。用d[t(m),t’(n)]表示这两序列特征矢量之间的距离,计算距离d[t,t’]。反复向前或向后推移起点得到多段截断时序数据组,当得到d最小者,获得相似度最高的两组时序数据,计算两组时序数据的起点差δt=m1-n1即为时间差。在利用dtw计算时,一个实施例可以采用路径累积法。具体地,把一个模板的各帧m=1~m在一个二维直角坐标系中的横轴上标出,把另一模板的各帧n=1~n在纵轴上标出,通过以mn为帧号画出纵横网络,网络中每一交点(m,n)表示比对模式中某一帧的交汇点。dp算法归结为寻找一条通过网络中若干格点的路径,路径不是随意选择的,虽然时间起步有变化,但是各部分的先后次序不可能改变,因此所选的路径必定存在一个约束斜率。满足约束条件即为求最佳路径的方式,求最佳路径函数使得沿路径的积累距离达到最小值。该路径的积累距离公式为:d[(m,n)]=d[t(m),t’(n)]+min{d(m-1,n),d(m-1,n-1),d(m,n-1)}。

[0084]

在所述获得目标运动轨迹的归一化时序数据还包括将归一化时序数据中目标遮挡时段的两端坐标进行线性连接的基础上,所述对各机位视频数据间匹配的归一化时序数据进行动态时间归整还可以包括:对基于包含进行了线性连接处理的部分的截断时序数据计算的矢量距离加权一个极小值ρ。该极小值ρ的范围是0《ρ≤0.001。即,上式变为:d[(m,n)]=ρ*{d[t(m),t’(n)]+min{d(m-1,n),d(m-1,n-1),d(m,n-1)}}。通过该处理不但可以保证动态时间归整计算进行,还可以避免出现大的误差。

[0085]

由此,获得矢量距离最小的配对截断时序数据,求出该两段截断时序数据的起点时间差即作为拉齐任意两组归一化时序数据的时间差。此后处理可选择性地进到步骤s503。

[0086]

在步骤s503,计算通过多个目标的各机位视频数据间归一化运动轨迹的动态时间归整来确定的时间差的平均值。由步骤s502的方法可计算出任意两组机位间不同匹配目标的归一化时序数据的时间差,计算多目标的时间差的平均值获得平均时间差:δt=δ1+δ2+δ3,

…

,δs/s,类似地计算出多机位视频数据间的平均时间差。

[0087]

进一步地,还可以执行步骤s504,在步骤s504中,对获得的平均时间差δt进行量化处理。该量化处理例如可以根据直播时视频流的帧率来进行量化,例如当直播输出流帧率为25p时,时间差按40ms为单位进行取整量化(不足40ms的按0ms计算)。

[0088]

最终,量化后的时间差数据可以发送给前端直播系统进行时序调整,或者发送给数据处理中心进行同步视频合成等,或用于监视视频数据间是否存在不同步问题。

[0089]

图7是图示根据本发明实施例的多机位视频同步系统的示意性框图。如图7所示,根据本发明实施例,多机位视频同步系统7包括:处理器71、存储器72、以及在所述存储器72的中存储的计算机程序指令73。

[0090]

所述计算机程序指令73在所述处理器71运行时可以实现根据本发明实施例的多机位视频同步的各个功能模块的功能,并且/或者可以执行根据本发明实施例的多机位视频同步的各个步骤。

[0091]

具体地,在所述计算机程序指令73被所述处理器71运行时执行以下步骤:获取多机位视频数据,所述多机位视频数据来自具有共视区域的多机位拍摄;确定多机位视频数据中的目标的运动轨迹,通过各机位视频数据间运动轨迹的动态时间归整来确定所述多机位视频的时间差。

[0092]

此外,在所述计算机程序指令73被所述处理器71运行时执行确定多机位视频数据中的目标的相对运动轨迹包括:检测各机位视频数据中的目标,并获取目标的追踪时序数据;向各机位视频数据的同一参照系投影追踪时序数据,获得目标运动轨迹的归一化时序数据。

[0093]

此外,在所述计算机程序指令73被所述处理器71运行时执行通过各机位视频数据之间运动轨迹的动态时间归整来确定所述多机位视频的时间差包括:在各机位视频数据之间对归一化时序数据进行目标匹配;对各机位视频数据间匹配的归一化时序数据进行动态时间归整来获得各机位视频的时间差。

[0094]

此外,在所述计算机程序指令73被所述处理器71运行时执行对各机位视频数据间匹配的归一化时序数据进行动态时间归整包括:在任意两机位视频数据间对匹配的归一化时序数据任意确定起点和终点获得各归一化时序数据的多段截断时序数据;计算任意匹配的两组归一化时序数据间各段截断时序数据的矢量距离,获得矢量距离最短的截断时序数据配对;计算配对截断时序数据的起点时间的差值。

[0095]

此外,在所述计算机程序指令73被所述处理器71运行时执行获得目标运动轨迹的归一化时序数据还包括将归一化时序数据中目标遮挡时段的两端坐标进行线性连接;在所述计算机程序指令73被所述处理器71运行时执行对各机位视频数据间匹配的归一化时序数据进行动态时间归整还包括对基于包含进行了线性连接处理的部分的截断时序数据计算的矢量距离加权范围在0《ρ≤0.001的极小值系数。

[0096]

根据本发明实施例的多机位视频同步系统中的各模块可以通过根据本发明实施例的多机位视频同步系统中的处理器运行在存储器中存储的计算机程序指令来实现,或者可以在根据本发明实施例的计算机程序产品的计算机可读存储介质中存储的计算机指令被计算机运行时实现。

[0097]

所述计算机可读存储介质可以是一个或多个计算机可读存储介质的任意组合,例如一个计算机可读存储介质包含用于随机地生成动作指令序列的计算机可读的程序代码,另一个计算机可读存储介质包含用于进行目标识别的计算机可读的程序代码。

[0098]

所述计算机可读存储介质例如可以包括智能电话的存储卡、平板电脑的存储部件、个人计算机的硬盘、随机存取存储器(ram)、只读存储器(rom)、可擦除可编程只读存储器(eprom)、便携式紧致盘只读存储器(cd-rom)、usb存储器、或者上述存储介质的任意组合。

[0099]

在一个实施例中,多机位视频同步系统7、20可以部署在边缘环境,具体可以部署在边缘环境中的一个边缘计算设备或运行在一个或者多个边缘计算设备上的软件系统。边缘环境指在地理位置上距离用于视频采集位置较近的,用于提供计算、存储、通信资源的边缘计算设备集群。特别是在直播体育比赛的场景下,多机位视频同步系统可以部署或整合于数据交换机、转播车、转播台、卫星车。每个机位可以将实时视频流通过线路或网络发送至多机位视频同步系统,多机位视频同步系统可以执行本技术提供的多机位视频同步方法,计算出多机位视频的时间差,用于多机位的时间矫正,或者监控播放平台的同步播放,或者用于全景视频制作、多目标检测等,多机位视频同步系统可以根据应用场景将时间差发送至相应的处理系统中。

[0100]

在一个实施例中,多机位视频同步系统7、20可以部署在云环境,云环境是云计算模式下利用基础资源向用户提供云服务的实体。云环境包括云数据中心和云服务平台,所述云数据中心包括云服务提供商拥有的大量基础资源(包括计算资源、存储资源和网络资源),云数据中心包括的计算资源可以是大量的计算设备(例如服务器)。多路视频同步系统可以是云数据中心的服务器;检测装置也可以是创建在云数据中心中的虚拟机;还可以是部署在云数据中心中的服务器或者虚拟机上的软件系统,该软件系统可以分布式地部署在多个服务器上、或者分布式地部署在多个虚拟机上、或者分布式地部署在虚拟机和服务器上。

[0101]

在一个实施例中,多机位视频同步系统7、20可以直接部署在终端环境中,作为一个示例,多机位视频同步系统可以是一种播放器80,如图8所示,该播放器80具备:视频接收器81,播放处理器82,数据存储器83和视频输入器84。视频接收器81用于接收多机位视频数据并存储在数据存储器84中。播放处理器82根据本技术的多机位视频同步方法将多机位视频数据进行同步处理获得用于同步多机位视频的时间差。播放处理器82还根据算得的时间差调整多机位视频的时间戳获得同步视频。视频输入器84将同步后的视频输入给显示装置用于显示同步视频,由此进一步获得同步的多窗口视频或实现多机位的拼屏播放。该播放器80可以作为同步处理器整合在播放机或路由器中,也可以整合于网络播放器或计算机系统中。

[0102]

在一个实施例中,多机位视频同步系统7、20可以直接将所述时间差传输至不同应用场景的处理系统,也可以根据时间差直接对多机位视频进行处理获得时间同步的多机位同步视频后,再将多机位同步视频传输至相应的处理系统中。

[0103]

多机位视频数据在很多情况下同时存在共视区域和非共视区域,非共视区域指的是一些机位可以拍摄到但是另一些机位无法拍摄到的区域。参考前述内容可知,本技术根据视频帧中的目标的轨迹相似度确定不同机位视频中的时间差,而非共视区域中的目标是其他机位无法拍摄到的目标,导致非共视区域中的目标的运动轨迹与接下来计算视频帧中的目标的运动轨迹之间的相似度无关系,因此,对于本技术来讲,非共视区域中的目标的运动轨迹标可以不参与相似度计算。因此,在一个优选的实施例中,可以对多个目标的每一帧的位置坐标或运动轨迹坐标进行二次处理,筛选出每一视频帧的共视区域中目标数据,可以大大减少相似度的计算量,提高获取多机位视频同步方法的处理效率。

[0104]

提供一种将本多机位视频同步技术应用于篮球赛事直播的应用例,用以说明本发明对于在线处理的优越性。

[0105]

图9a表示篮球比赛中具有重叠拍摄区域的三个机位(主机位c0,左机位c1,右机位c2)的实时拍摄的状态,图9b是图示根据本发明实施例的主机位镜头中的篮球赛场的参照线的示意图,图9c是图示根据本发明实施例的左机位镜头中的篮球赛场的参照线的示意图。x表示篮球场地的边线,xo是边线与中线的交点,作为边线用作参照系时的原点位置。

[0106]

图10a和图10b是图示根据本发明的篮球赛事直播视频同步处理方法的流程图。在实际的应用中由于实时接收直播中的不同步数据,因此将计算的不同步偏差不会太大,对保证及时计算的要求更为适应,并可根据实时直播的偏差程度预判放出足够时长的接收时间豁口。

[0107]

该实施例以主机位c0和左机位c1(右机位c2同理)构成的两机位视频为例处理其存在不同步问题,该同步处理包括以下步骤:s1001:从机位c0和c1采集各自的静态拍摄视频数据。详细内容与上述步骤s101相同或类似,在此省略说明。

[0108]

s1002:对各机位的视频数据中的球员对象和/或篮球对象进行目标检测,并获取检测目标的追踪时序数据。详细内容与上述步骤s301相同或类似,在此省略说明。

[0109]

s1003:以球场边线x为两机位视频数据中的同一参照线,对该参照线投影追踪时序数据,获得目标运动轨迹的归一化时序数据。详细内容与上述步骤s302相同或类似,在此省略说明。

[0110]

s1004:将归一化时序数据中目标遮挡时段的两端坐标进行线性连接。详细内容与上述步骤s302相同或类似,在此省略说明。

[0111]

s1005:在视频数据之间对取得的归一化时序数据进行目标匹配。详细内容与上述步骤s501相同或类似,在此省略说明。

[0112]

s1006:对匹配的归一化时序数据任意确定起点和终点获得各归一化时序数据的多段截断时序数据。

[0113]

s1007:计算任意匹配的两组归一化时序数据间各段截断时序数据的矢量距离,并对基于包含进行了线性连接处理的部分的截断时序数据计算的矢量距离加权范围在0《ρ≤0.001的极小值系数。

[0114]

s1008:获得矢量距离最短的截断时序数据配对。

[0115]

s1009:计算配对截断时序数据的起点时间的差值作为匹配目标的轨迹时间差。

[0116]

步骤s1007~步骤s1009的详细内容与上述步骤s502相同或类似,在此省略说明。

[0117]

s1010:计算多个目标的轨迹时间差的平均值。详细内容与上述步骤s503相同或类似,在此省略说明。

[0118]

s1011:对时间差的平均值进行量化处理。详细内容与上述步骤s504相同或类似,在此省略说明。

[0119]

s1012:根据量化处理的平均时间差矫正c0或cl机位的时间戳。

[0120]

在上面详细描述的本发明的示例实施例仅仅是说明性的,而不是限制性的。本领域技术人员应该理解,在不脱离本发明的原理和精神的情况下,可对这些实施例进行各种修改,组合或子组合,并且这样的修改应落入本发明的范围内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1