一种关于分布式服务的组合限流方法与流程

1.本发明涉及分布式服务流量管控技术领域,更具体的说是涉及一种关于分布式服务的组合限流方法。

背景技术:

2.目前,互联网流量管控技术领域的分布式服务限流方案一般都是在服务端采用某种固定限流算法实现。

3.但是,这种方案无法避免客户端对服务端的访问攻击,客户端的所有请求接收后都进行验证,不仅是对服务端性能的考验,对存储服务性能也是一种考验,而且无效的请求更是造成服务器流量的巨大浪费。当限流配额巨大时,每一个请求都访问存储服务,存储服务的性能未必可以达到限流配额,从而导致限流效果不理想。

4.因此,如何避免客户端对服务端的访问攻击,提高服务器限流效果是本领域技术人员亟需解决的问题。

技术实现要素:

5.有鉴于此,本发明提供了一种关于分布式服务的组合限流方法,为涉及客户端sdk和服务端组合限制流量的方法,在一般的分布式限流方法基础上,重点解决了客户端的频繁访问或者限流配额巨大导致的服务端或者存储介质处理异常甚至崩溃的技术问题,对服务端和存储服务均进行了有效保护。

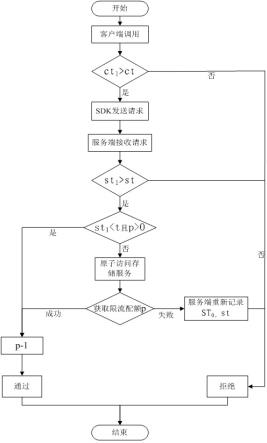

6.为了实现上述目的,本发明采用如下技术方案:一种关于分布式服务的组合限流方法,包括以下步骤:步骤1:设定每秒限流总配额p,根据限流总配额计算每次请求的限流配额;限流配额p的表达式为:限流配额p=t/1000*p;p表示限流配额;t表示固定时间;p表示每秒限流总配额;步骤2:服务端记录服务器上次请求时间戳st0和上次存储服务返回的服务器等待时间间隔st;步骤3:sdk记录客户端上次请求时间戳ct0和上次服务端返回的客户端等待时间间隔ct;步骤4:当客户端再次调用sdk后,sdk计算客户端请求时间间隔ct1,表示为:客户端请求时间间隔ct1=客户端当前请求时间戳ct

1-客户端上次请求时间戳ct0;步骤5:若客户端请求时间间隔ct1小于客户端等待时间间隔ct,则直接拒绝;反之,sdk将请求发送服务端;步骤6:服务端接收客户端发送的请求后,服务端计算服务器请求时间间隔st1,表示为:服务器请求时间间隔st1=服务器当前请求时间戳st

1-服务器上次请求时间戳st0;步骤7:若服务器请求时间间隔st1小于服务器等待时间间隔st,则直接拒绝;反

之,进入步骤8;步骤8:若服务器请求时间间隔st1小于预设固定时间《t,且限流配额p大于0,则请求通过,同时限流配额p减1;反之,进入步骤9;步骤9:服务端原子访问存储服务,获取固定时间t的限流配额p,,同时根据限流总配额和限流配额计算限流余额p’;限流余额的表达式为:p’=p-p;p表示限流配额;p表示每秒限流总配额;p’表示限流余额;步骤10:如果限流余额大于0,则限流配额p获取成功,请求通过,限流配额p减1;否则,限流配额p获取失败,则拒绝请求,存储服务响应新的服务器等待时间间隔st反馈至服务端,并且服务端重新记录服务器上次请求时间戳st0,返回步骤4。

7.经由上述的技术方案可知,与现有技术相比,本发明公开提供了一种关于分布式服务的组合限流方法,有效避免客户端对服务端的访问攻击;有效避免服务端对存储服务的访问攻击;在高频请求下,大幅度降低限流平均延迟;在高频请求下,大幅度提高限流处理性能。

附图说明

8.为了更清楚地说明本发明实施例或现有技术中的技术方案,下面将对实施例或现有技术描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据提供的附图获得其他的附图。

9.图1附图为本发明提供的关于分布式服务的组合限流方法流程图。

具体实施方式

10.下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

11.本发明实施例公开了一种关于分布式服务的组合限流方法,通过客户端sdk和服务端组合限制流量的方式,解决客户端的频繁访问或者限流配额巨大导致的服务端或者存储介质处理异常甚至崩溃的问题,对服务端和存储服务均进行有效保护。

12.实施例一本例为sdf_generaterandom接口请求次数设定20万次/秒的限流示例:s1:客户端调用sdk的对应接口后,sdk进行缓存判断:当请求频率高于20w次/秒时,假设此时服务器返回的该接口请求服务器等待时间间隔为60毫秒,则sdk进行缓存,在60毫秒内,客户端进行该接口请求都会拒绝,直到超过60毫秒。当频率低于20w次/秒时,请求通过此时服务器等待时间间隔始终为-1毫秒,表示无需等待,可发送给服务器;s2:服务端接收该接口请求后,服务端进行第一层缓存判断:当请求频率高于20w次/秒时,假设此时存储服务返回的该接口请求等待时间为60毫秒,则服务端进行缓存,在

60毫秒内,sdk进行该接口请求都会拒绝,直到超过60毫秒。当频率低于20w次/秒时,此时等待时间始终为-1毫秒,表示无需等待,可进行第二层缓存判断;s3:服务端第二层缓存判断:当没有配额可用时,服务端请求存储服务获取2000的配额(10毫秒/1000毫秒*20万),若获取失败,则请求拒绝,缓存并返回超时等待时间;若获取成功,则缓存当前时间及获取配额2000,则此刻10毫秒内的2000个请求都会通过,当10毫秒内的第2001个请求到来时,服务端会再次请求存储服务获取2000的配额。如果10毫秒内的请求不足2000,假设第1500个请求时刚好超过10毫秒,则服务端不再使用原获取剩余配额500,会再次请求存储服务获取2000的配额。

13.实施例二本例为sdf_exchangedigitenvelopebaseonrsa接口请求带宽设定2gb/秒的限流示例:s1:客户端调用sdk的对应接口后,sdk进行缓存判断:当请求带宽高于2gb/秒时,假设此时服务器返回的该接口请求等待时间为80毫秒,则sdk进行缓存,在80毫秒内,客户端进行该接口请求都会拒绝,直到超过80毫秒。当带宽低于2gb/秒时,此时等待时间始终为-1毫秒,表示无需等待,可发送给服务器;s2:服务端接收该接口请求后,服务端进行第一层缓存判断:当请求带宽高于2gb/秒时,假设此时存储服务返回的该接口请求等待时间为80毫秒,则服务端进行缓存,在80毫秒内,sdk进行该接口请求都会拒绝,直到超过80毫秒。当带宽低于2gb/秒时,此时等待时间始终为-1毫秒,表示无需等待,可进行第二层缓存判断;s3:服务端第二层缓存判断:当没有配额可用时,服务端请求存储服务获取20mb的配额(10毫秒/1000毫秒*2*1024*1024*1024b),若获取失败,则请求拒绝,缓存并返回超时等待时间;若获取成功,则缓存当前时间及获取配额20mb,则此刻10毫秒内的20mb带宽配额都会通过,当10毫秒内,超过20mb带宽请求时,服务端会再次请求存储服务获取20mb配额。如果10毫秒内的请求不足20mb,假设第1500个请求时刚好超过10毫秒,则服务端不再使用原获取剩余带宽配额,会再次请求存储服务获取20mb配额。

14.以上两种实施用例均为该发明在请求次数、请求带宽等限流配额巨大情况的组合限制优化方法,通过实施例一、二的s1,可实现避免单客户端频繁调用服务端,对服务端进行了有效保护;通过实施例一、二的s2,可实现避免上万个sdk同时调用服务端造成的频繁访问存储服务,对服务端和存储服务均进行了有效保护;通过实施例一、二的s3,可实现避免服务端频繁访问存储服务,若固定时间设置为10毫秒,优化后只需要调用100余次存储服务即可,而传统的方法则需要调用几十万次存储服务,对存储服务进行了强有力的保护。

15.本说明书中各个实施例采用递进的方式描述,每个实施例重点说明的都是与其他实施例的不同之处,各个实施例之间相同相似部分互相参见即可。对于实施例公开的装置而言,由于其与实施例公开的方法相对应,所以描述的比较简单,相关之处参见方法部分说明即可。

16.对所公开的实施例的上述说明,使本领域专业技术人员能够实现或使用本发明。对这些实施例的多种修改对本领域的专业技术人员来说将是显而易见的,本文中所定义的一般原理可以在不脱离本发明的精神或范围的情况下,在其它实施例中实现。因此,本发明将不会被限制于本文所示的这些实施例,而是要符合与本文所公开的原理和新颖特点相一

致的最宽的范围。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1