基于深度强化学习的NB-IoT上行覆盖增强优化方法

基于深度强化学习的nb-iot上行覆盖增强优化方法

技术领域

1.本发明属于nb-iot通信技术和深度强化学习领域,具体为基于深度强化学习的nb-iot上行覆盖增强优化方法。

背景技术:

2.nb-iot作为低功耗广域物联网技术,其设计目标之一是比gsm和lte更大的覆盖性。nb-iot的上行覆盖增强主要受上行功率谱密度、重复发送次数及调制与编码策略(modulation and coding scheme,mcs)三个因素的影响。现有nb-iot协议对覆盖增强等级的划分粒度较粗,分为三个覆盖增强等级,分别是:常规覆盖,mcl《144db;扩展覆盖,144db《mcl《154db;极端覆盖,mcl》154db。划分的最大耦合损耗区间范围较宽,会造成同一个覆盖增强等级下不同设备的路径损耗有比较大的差异,而对于相同覆盖增强等级下的设备会采用相同的参数配置,造成部分终端资源浪费。目前对nb-iot覆盖增强机制优化的相关研究,一些只考虑了与nb-iot覆盖增强相关三个因素中的一个或两个因素,未全面纳入所有影响因素,不能达到最优的覆盖增强;还有一些虽然考虑了全部的三个维度,但其复杂度较高或未能达到最优性能。

3.深度学习使用深度神经网络将高维的数据抽象成低维度的表示(特征),实现对事物的有效感知。强化学习中,智能体和环境进行交互,以最大化累积奖励为目标,不断优化行为决策,具有强大的决策能力。深度强化学习结合了深度学习的感知表达能力和强化学习的决策能力,能根据直接获取的原始信息做出较好的决策,并且深度强化学习使用深度神经网络拟合值函数,可解决传统强化学习维数灾难问题。深度强化学习凭借其深度神经网络的泛化能力和特征提取能力以及强化学习的决策能力,在许多领域获得成功,已有学者将深度强化学习成功应用于无线网络研究,并取得较好的效果。

技术实现要素:

4.针对现有技术不足,本发明提出了一种基于深度强化学习的nb-iot上行覆盖增强优化方法(ddqn-ce,double dqn based coverage enhancement),该方法将nb-iot上行覆盖资源分配问题构造为深度强化学习的过程,将上行数据可靠传输(bler≤10%)作为约束条件,以最小化上行通信时延为优化目标。深度强化学习智能体与nb-iot通信环境进行交互,生成用户终端的状态转移样本,并存入经验回放池。智能体从经验回放池中抽取批量样本进行训练学习,使用梯度反向传播更新神经网络参数,使智能体的神经网络参数收敛,最终实现对nb-iot上行覆盖多维参数的优化配置。进而增强nb-iot上行通信的可靠性,减小上行通信时延,扩大上行覆盖范围,有效增强nb-iot的上行覆盖。

5.为实现上述发明目的,本发明采用以下技术方案:一种基于深度强化学习的nb-iot上行覆盖增强优化方法,包括以下步骤:

6.步骤1,构建ddqn中两个结构相同的神经网络估计q网络和目标q网络;初始化估计q网络的网络参数θ和目标q网络参数θ-,令θ-=θ;初始化经验回放池r;初始化算法参数学习

步长α、目标q网络参数更新时间步c、每回合训练步数t、折扣因子γ、探索率最大值ε

max

及最小值ε

min

、探索率减小量δ、探索率ε=ε

max

、批量梯度下降的样本数m;

7.步骤2,初始化nb-iot通信环境中用户终端的上行通信参数:重复传输次数、传输带宽、mcs等级和传输块资源单元数量,初始时间步初始t=0;

8.步骤3,智能体(深度强化学习中的决策者和学习者)从nb-iot通信环境中获取用户终端的状态信息,得到状态s

t

,将状态s

t

输入估计q网络,根据∈-greedy策略选择动作a

t

;

9.步骤4,将a

t

转换为nb-iot上行覆盖增强的参数分配形式,对nb-iot用户终端进行配置,用户终端状态发生改变,并执行上行数据传输,收集snr(信噪比)、传输时延等数据,并计算奖励值;

10.步骤5,智能体从nb-iot通信环境获得执行动作后的奖励r

t+1

和状态s

t+1

,将状态转移样本(s

t

,a

t

,r

t+1

,s

t+1

)存入经验回放池中;

11.步骤6,判断经验池样本数量是否小于批采样数量m,如果小于,转步骤3,否则,从经验回放池r中随机抽取一批m个样本(s

j,n

,a

j,n

,r

j+1,n

,s

j+1,n

),n∈[1,m],对估计q网络进行训练,通过神经网络梯度反向传播进行梯度下降来更新估计q网络的参数θ;

[0012]

步骤7,更新探索率ε,令ε

max

=ε

max-δ,ε=max(ε

max

,ε

min

);

[0013]

步骤8,令t=t+1,如果t%c=0,更新目标q网络的参数θ-,令θ-=θ;

[0014]

步骤9,判断t是否小于每回合训练步数t,如果小于,转步骤3,否则,计算该回合累积奖励,判断估计q网络参数θ是否收敛,如果收敛,转步骤10,否则转步骤2;

[0015]

步骤10,将nb-iot用户终端的状态输入估计q网络,采用贪婪策略选择价值最大的动作并执行,实现nb-iot上行覆盖增强参数最优配置;

[0016]

步骤11,nb-iot上行覆盖增强优化流程结束。

[0017]

进一步,上述步骤2中,nb-iot通信系统中用户终端的上行通信参数初始化为:重复传输次数为1;传输带宽为180khz(子载波间隔为15khz,子载波数量为12);msc等级为0;传输块资源单元数量为1。

[0018]

进一步,上述步骤3中,状态空间s={i

rep

,i

bw

,i

mcs

,i

ru

,delay,rel},状态s

t

∈s。

[0019]

其中:

[0020]irep

为重复传输次数的索引值,取值范围:0-7;

[0021]ibw

为传输带宽索引值,取值范围:0-4;

[0022]imcs

为mcs等级索引值,取值范围:单子载波传输时,0-10;多子载波传输时,0-12;

[0023]iru

为传输块资源单元数量索引值,取值范围:0-7;

[0024]

delay为上行数据传输时延,为实数;

[0025]

rel为传输可靠性,有两种取值,当bler大于0.1时,为0;当bler小于等于0.1时,为1。

[0026]

∈-greedy策略公式如下:

[0027][0028]

其中,π(a|s)为状态s下选择动作a的概率,|a(s)|是状态s下所能选择动作的数

量。

[0029]

动作空间a定义为i

rep

,i

bw

,i

mcs

,i

ru

的变化情况,每个值的变化都有三种可能:加一、不变和减一,动作a

t

∈a。

[0030]

进一步,上述步骤4中,在将nb-iot上行覆盖增强优化问题构造为深度强化学习的过程时,将上行数据可靠传输(bler≤10%)作为约束条件,以最小化上行通信时延为优化目标,具体表示公式如下:

[0031]

min delay

[0032]

s.t.bler≤0.1

[0033]

其中,delay为用户终端上行传输时延,bler为用户终端上行传输块误码率。

[0034]

定义奖励r的计算公式如下:

[0035][0036]

其中,delay

max

为上行通信最大时延;bler是否大于0.1,根据当前上行信道的snr和snr

th

的比较得到,当snr≥snr

th

时,bler≤0.1;否则bler》0.1。snr

th

是当前上行传输参数配置下bler等于0.1对应的信噪比。

[0037]

进一步,上述步骤6中,对估计q网络进行训练,执行下面的步骤对参数θ做一次更新:

[0038]

6.1对估计q网络做正向传播,得到样本估计动作价值如下:

[0039][0040]

其中,为状态动作对(s

j,n

,a

j,n

)的估计动作价值。

[0041]

6.2选择s

j+1,n

的动作:

[0042][0043]

其中a

′

为状态s

j+1,n

下最大估计动作价值对应的动作。

[0044]

6.3用目标q网络求s

j+1,n

和a

′

的估计动作价值:

[0045][0046]

其中,为状态动作对(s

j+1,n

,a

′

)的目标动作价值。

[0047]

6.4计算td(temporal difference,时间差分)目标和td误差:

[0048][0049]

其中,y

j,n

为td目标。

[0050][0051]

其中,δ

j,n

为td误差。

[0052]

6.5对估计q网络做反向传播,求q(s

j,n

,a

j,n

;θ)对参数θ的梯度:

[0053][0054]

6.6做梯度下降更新估计q网络的参数:

[0055][0056]

进一步,上述步骤10中,采用贪婪策略选择动作,实现nb-iot上行覆盖增强参数最优配置,贪婪策略公式如下:

[0057][0058]

其中,π

*

(a|s)表示最优策略,q

*

(s,a)为最优动作价值函数。

[0059]

本发明的有益效果:

[0060]

本发明中基于深度强化学习的nb-iot上行覆盖方法,同时考虑nb-iot上行覆盖增强相关的三个因素,能够更全面地对nb-iot上行覆盖进行优化,使nb-iot上行通信具有更高的可靠性、更低的上行通信时延、更广的上行覆盖范围;根据nb-iot终端实际上行信道质量个性化地对其上行覆盖参数进行优化配置,可克服因nb-iot覆盖等级划分粒度较粗造成部分终端资源浪费的问题。

附图说明

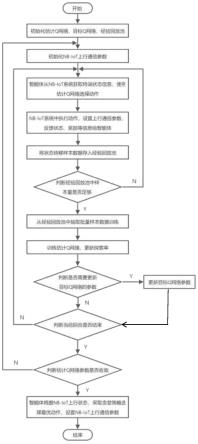

[0061]

图1是本发明中提出方法的总流程图。

[0062]

图2是本发明中提出方法的总体框架。

具体实施方式

[0063]

下面结合附图及具体实施例对本发明做进一步的详细说明,需要指出的是,此处所描述的具体实施例仅用于解释本发明,对本发明不构成限定。

[0064]

如图1、图2所示,本发明涉及一种基于深度强化学习的nb-iot上行覆盖增强优化方法,包括如下步骤:

[0065]

步骤1,构建ddqn中两个结构相同的神经网络估计q网络和目标q网络;初始化估计q网络的网络参数θ和目标q网络参数θ-,令θ-=θ;初始化经验回放池r;初始化算法参数学习步长α、目标q网络参数更新时间步c、每回合训练步数t、折扣因子γ、探索率最大值ε

max

及最小值ε

min

、探索率减小量δ、探索率ε=ε

max

、批量梯度下降的样本数m。

[0066]

作为本发明的优选实施例,估计q网络的参数θ随机初始化,令目标q网络参数θ-=θ;经验回放池容量初始化为1000;学习步长α初始化为0.001;目标q网络参数更新时间步c初始化为100;每回合训练步数t初始化为5000;折扣因子γ初始化为0.95;探索率最大值ε

max

及最小值ε

min

分别初始化为1和0.1;探索率减小量δ初始化为0.004;批量梯度下降的样本数m初始化为128。

[0067]

步骤2,初始化nb-iot通信环境中用户终端的上行通信参数:重复传输次数、传输带宽、mcs等级和传输块资源单元数量,初始时间步初始t=0。

[0068]

作为本发明的优选实施例,nb-iot通信系统中用户终端的上行通信参数初始化为:重复传输次数为1;传输带宽为180khz(子载波间隔为15khz,子载波数量为12);msc等级为0;传输块资源单元数量为1。

[0069]

步骤3,智能体(深度强化学习中的决策者和学习者)从nb-iot通信环境中获取用

户终端的状态信息,得到状态s

t

,将状态s

t

输入估计q网络,根据∈-greedy策略选择动作a

t

。

[0070]

作为本发明的优选实施例,状态空间s={i

rep

,i

bw

,i

mcs

,i

ru

,delay,rel},状态s

t

∈s。其中:

[0071]irep

为重复传输次数的索引值,取值范围:0-7,与重复传输次数对应关系如下表:

[0072]

表1重复次数的取值

[0073][0074]ibw

为传输带宽索引值,取值范围:0-4,与子载波间隔和子载波数量对应关系如下表:

[0075]

表2子载波间隔、子载波数量、ru时长及频率因子的取值

[0076][0077][0078]imcs

为mcs等级索引值,取值范围:单子载波传输时,0-10,对应mcs0-mcs10;多子载波传输时,0-12,对应mcs0-mcs12。

[0079]iru

为传输块资源单元数量索引值,取值范围:0-7,与单个传输块资源单元数量的对应关系如下表:

[0080]

表3单个传输块资源单元的个数

[0081][0082]

delay为上行数据传输时延,为实数;

[0083]

rel为传输可靠性,有两种取值,当bler大于0.1时,为0;当bler小于等于0.1时,为1。

[0084]

作为本发明的优选实施例,∈-greedy策略公式如下:

[0085][0086]

其中,π(a|s)为状态s下选择动作a的概率,|a(s)|是状态s下所能选择动作的数量。

[0087]

动作空间a定义为i

rep

,i

bw

,i

mcs

,i

ru

的变化情况,每个值的变化都有三种可能:加一、不变和减一,动作a

t

∈a。

[0088]

步骤4,将a

t

转换为nb-iot上行覆盖增强的参数分配形式,对nb-iot用户终端进行配置,用户终端状态发生改变,并执行上行数据传输,收集snr(信噪比)、传输时延等数据,并计算奖励值。

[0089]

作为本发明的优选实施例,在将nb-iot上行覆盖增强优化问题构造为深度强化学习的过程时,将上行数据可靠传输(bler≤10%)作为约束条件,以最小化上行通信时延为优化目标,具体优化模型表示为如下公式:

[0090]

min delay

[0091]

s.t.bler≤0.1

[0092]

其中,delay为用户终端上行传输时延,bler为用户终端上行传输块误码率。

[0093]

定义奖励r的计算公式如下:

[0094][0095]

其中,delay

max

为上行通信最大时延;bler是否大于0.1,根据当前上行信道的snr和snr

th

的比较得到,当snr≥snr

th

时,bler≤0.1;否则bler》0.1。snr

th

是当前上行传输参数

配置下bler等于0.1对应的信噪比。

[0096]

步骤5,智能体从nb-iot通信环境获得执行动作后的奖励r

t+1

和状态s

t+1

,将状态转移样本(s

t

,a

t

,r

t+1

,s

t+1

)存入经验回放池中。

[0097]

步骤6,判断经验池样本数量是否小于批采样数量m,如果小于,转步骤3,否则,从经验回放池r中随机抽取一批m个样本(s

j,n

,a

j,n

,r

j+1,n

,s

j+1,n

),n∈[1,m],对估计q网络进行训练,通过神经网络梯度反向传播进行梯度下降来更新估计q网络的参数θ。

[0098]

作为本发明的优选实施例,对估计q网络进行训练,执行下面的步骤对参数θ做一次更新:

[0099]

6.1对估计q网络做正向传播,得到样本估计动作价值如下:

[0100][0101]

其中,为状态动作对(s

j,n

,a

j,n

)的估计动作价值。

[0102]

6.2选择s

j+1,n

的动作:

[0103][0104]

其中a

′

为状态s

j+1,n

下最大估计动作价值对应的动作。

[0105]

6.3用目标q网络求s

j+1,n

和a

′

的估计动作价值:

[0106][0107]

其中,为状态动作对(s

j+1,n

,a

′

)的目标动作价值。

[0108]

6.4计算td(temporal difference,时间差分)目标和td误差:

[0109][0110]

其中,y

j,n

为td目标。

[0111][0112]

其中,δ

j,n

为td误差。

[0113]

6.5对估计q网络做反向传播,求q(s

j,n

,a

j,n

;θ)对参数θ的梯度:

[0114][0115]

6.6做梯度下降更新估计q网络的参数:

[0116][0117]

步骤7,更新探索率ε,令ε

max

=ε

max-δ,ε=max(ε

max

,ε

min

)。

[0118]

步骤8,令t=t+1,如果t%c=0,更新目标q网络的参数θ-,令θ-=θ。

[0119]

步骤9,判断t是否小于每回合训练步数t,如果小于,转步骤3,否则,计算该回合累积奖励,判断估计q网络参数θ是否收敛,如果收敛,转步骤10,否则转步骤2。

[0120]

步骤10,将nb-iot用户终端的状态输入估计q网络,采用贪婪策略选择价值最大的动作并执行,实现nb-iot上行覆盖增强参数最优配置。

[0121]

作为本发明的优选实施例,贪婪策略公式如下:

[0122][0123]

其中,π

*

(a|s)表示最优策略,q

*

(s,a)为最优动作价值函数。

[0124]

步骤11,nb-iot上行覆盖增强优化流程结束。

[0125]

以上实施例仅仅是本发明的可实施方式的具体说明,用于使本领域的技术人员能够理解本发明的内容并据以实施,本发明并不限于上述实施方式,本领域技术人员依据本发明的原理及设计思路所作的等效实施方式和变型均在本发明的保护范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1