一种在元宇宙中自动生成故事视频的方法及系统与流程

本发明属于计算机应用,特别涉及基于元宇宙概念具体应用在元宇宙线性或互动视频内容自动化生产,或常规多媒体的线性或互动视频自动化生产方面的一种系统和方法。

背景技术:

1、“元宇宙”作为2021年开始兴起的新概念,通过“元宇宙”赋能数字文化内容生产创新,让文化内容生产有了更多的设想和展望。随着人们对大量高质量、个性化、有创意的文化内容需求的增加,数字技术的加速应用和迭代不断升级改变着文化内容的生产模式。元宇宙赋能数字文化传播方式创新,让数字文化传播焕发新的生机。数字时代的到来,打破了文化传播主体的限制和传播的时空壁垒,在充满未来感,穿梭于线上线下、真实与虚拟之间的数字空间中,元宇宙颠覆了传统媒介的传播形态,将人类的感官无限延伸,为人们提供更加细腻的传播形式。

2、然而在当前和未来,各媒体从业工作者或机构在填充元宇宙所提供的海量内容空间时,即将或正在面临通过现有方式制作vr建模视频或者vr互动视频时的各类问题。包括且不限于生产视频时间周期过长;需要由具备unity3d、vray技术能力的视频设计师来完成vr和3d建模的工作;需要由具备掌握《互联网互动视频数据格式规范》的互动视频故事架构师和交互视频工程师来完成,普遍存在内容生产时技术壁垒较高的问题。更重要的是,当前的视频生产方式让更多的人民群众在成为ugc模式下的元宇宙内容生产者时,成本过高。

3、通过本发明提供的故事分析引擎和故事互动引擎,让普通用户通过文字或语音的方式输入自己的故事脚本,系统和方法还支持自动化生成应用于元宇宙概念之外的普通线性视频和互动视频的制作,以自动化的方式生成带有自己和故事中人物虚拟化身的元宇宙视频故事内容,让普通用户在元宇宙空间中讲述自己的故事,大大降低传统vr视频和普通视频以及互动视频的制作成本和时间成本。另外,该同时该发明所提供的系统和方法,也为专业的媒体制作从业人员提供了高效自动生产的一种选择。

技术实现思路

1、本发明的目的是提供一种故事分析引擎和故事互动引擎,通过文字或语音的方式输入故事脚本,以自动化的方式生成人物虚拟化身的元宇宙视频故事内容,大大降低传统vr视频和普通视频以及互动视频的制作成本和时间成本。

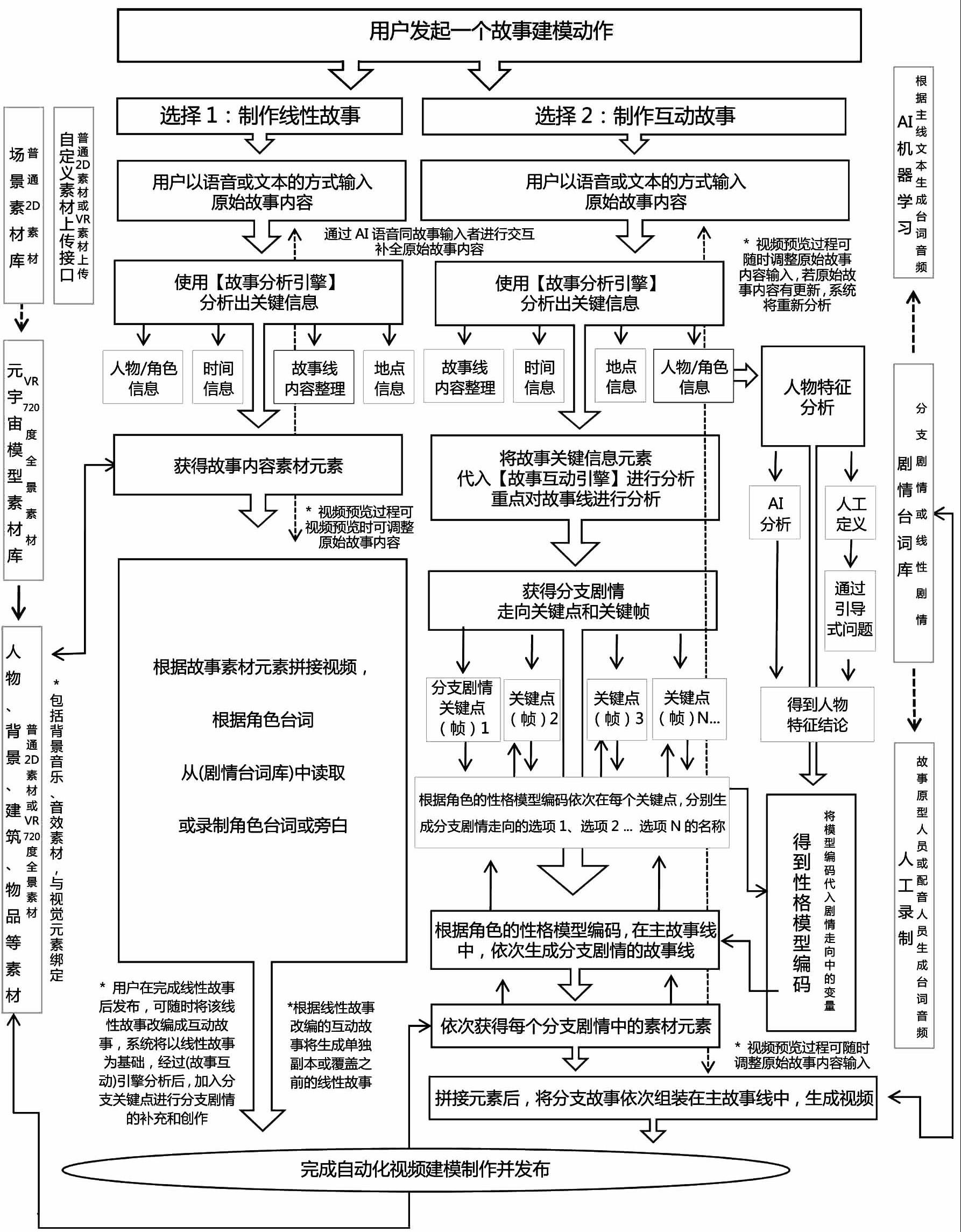

2、为实现上述目的,本发明所述的一种在元宇宙中自动生成故事视频的方法,包括至少一段用户输入的文字或语音形式的原始故事脚本,包括故事分析引擎、故事互动引擎、人物特征分析模块、故事拼装模块、元宇宙素材库,可以包含至少一个xr终端设备用于观看vr视频和vr视频制作过程中的vr画面的呈现;其中用户输入的文字或语音形式的原始故事脚本,将以本系统提供的方法作为驱动,通过故事分析引擎和故事互动引擎完成线性或互动故事线的制作,再将故事线中的元素和故事叙述经过,通过ai语义算法将元素和动作对应到元宇宙素材库中的素材进行绑定和组合,通过ai算法生成动画。若用户选择的是互动视频的制作,将通过ai算法完成每个互动视频中分支剧情选择点中的选项所对应的动画制作后,将分支选择点和分支剧情选择点中的每个分支剧情,依次组装在主故事线的关键帧中,在视频播放时,作为分支剧情进行展现。

3、所述故事生成方法构成,是根据故事分析引擎完成故事中的人物、时间、地点等关键元素的提取,并生成故事主线;程序自动将分析得到的关键元素输入到故事互动引擎中,获得分支剧情走向关键点并在故事主线中生成关键帧,同时系统的人物特征模块将通过ai分析或人工定义的方式对人物特征进行分析,并最终得到人物角色的性格模型编码。

4、所述故事生成方法构成,是系统将根据人物性格模型编码,依次在故事主线中的每个关键帧,分别生成分支剧情走向的选项1、选项2直到选项n,用户可在预览阶段对此环节的选项文本进行调整;确定关键帧的选项之后,根据人物性格编码为依据,通过ai系统算法补全该关键帧下分支剧情选项对应的剧情故事内容,在对故事元素绑定元宇宙素材库中的对应元素后生成动画,此过程与上述线性故事中的素材配型方法一致,由此完成其中一个分支剧情的制作,上述步骤将重复进行直到制作完成全部分支剧情的动画,最后将各个分支剧情在主故事线中进行组装,最终生成线性或互动视频。

5、所述用户可以选择制作线性故事或者互动故事内容,当用户选择制作线性故事视频时,在故事分析引擎分析出人物、时间、地点等关键元素的提取,并生成故事主线后,将直接通过元宇宙素材库进行动画的生成。

6、所述生成在制作互动视频的过程中,用户可随时看到生成进度并可进行暂停查看,随时对故事进行调整;调整动作包含不限于更改配音、修改分支剧情选项、修改分支剧情对应故事线内容等,若调整了故事原始脚本,系统将重新开始分析并生成对应的元素和故事主线。

7、所述播放由本系统提供的方法生成的互动视频时,用户可通过使用xr设备ui系统中提供的锚点进行分支剧情选项的选择,也可直接通过语音输入的方式与剧情中的人物进行对话,系统识别语音输入后转化成文字信息经过语义判断后匹配最优分支剧情的选项进行操作。

8、所述故事分析引擎和故事互动引擎工作时,将根据引擎算法设计故事脚本的填充,在遇到违背故事算法逻辑或内容信息不全时,将通过语音方式与用户进行互动交流,直到系统可以完成故事线的编写和互动剧情脚本的编写。系统会将补充得到的内容记录在原始故事线里。该过程可随时暂停不必一次性完成。

9、所述用户在完成线性故事后发布,可随时将该线性故事改编成互动故事,系统将以线性故事为基础,经过故事互动引擎分析后,加入分支关键点进行分支剧情的补充和创作。根据线性故事改编的互动故事将生成单独副本或覆盖之前的线性故事。

10、所述在互动视频自动化流程中,生成关键帧的依据是以人物角色的性格模型编码为变量,代入剧情演算算法中分析该变量成为分支剧情的可能性,当权重大于50%时生成分支剧情关键帧,或在用户进行视频预览时由用户决定在故事主线中添加分支剧情的关键帧。通常来讲关键帧的建立发生在角色之间的对话中,通过对话时的选择触发分支剧情。

11、所述关于人物性格模型编码的描述和规则,具体表现为:根据ai学习和大数据收集,每个角色最终将生成其唯一的性格模型编码,该编码有一组32位的大小写英文+数字+特殊符号组成,对应在系统的性格模型数据库中,该编码背后其实关联的是一组元数据矩阵信息,包括人物的姓名、简历、性格特征、倾向判断、语言词汇数据库等信息,根据机器学习和大数据积累该编码库将不断补充和发展。系统通过该编码背后的元数据信息,结合故事场景通过大数据计算出该人物在该场景下的行为和动作,是人物带动剧情发展的的原始契机。如:a遇到b类问题,编码元数据中关于遇到b问题的角色90%的都会做出c类选择,但是又因为元数据中同时a角色还具备d类特质,具备d类特质的80%的角色会选择e方法,所以经过系统判断a最终的选择是去干f类的事情,因为f类事情的属性同时属于e方法和c选自动生成故事视频建模方法的运行原理。

12、上述一种在元宇宙中自动生成故事视频方法,是通过的一种在元宇宙中自动生成故事视频系统实现的,所说该系统,由以下模组构成:

13、 1.元宇宙素材库

14、用于存储已有元素,素材库中的所有元素根据故事背景时间为参数形成外观的区分,素材的动画设计部分具有差异特点,由ai根据目标对象的特点进行匹配,或通过人工方式手动进行匹配。所有视觉类素材会对应一个或多个音频类素材,一个音频类素材也会对应一个或多个视觉类素材;

15、1.1基础元素库

16、该素材库的元素用于制作普通2d视频;

17、(1)人物素材

18、包含非vr素材的2d静态人物头像,或非vr素材的2d动画人物模型素材,所有素材具备抠像条件或本身具备透明背景性质;

19、(2)地点/背景素材

20、包含2d静态场景图片素材,或2d动画场景视频,或2d实景拍摄的场景视频;

21、(3)物品素材

22、包含2d静态物品图片素材,或2d动画物品视频剪辑loop,或2d实物拍摄的视频loop。所有素材具备抠像条件或本身具备透明背景性质;

23、(4)其它素材

24、包含且不限于2d形态的文字、装饰元素、转场效果等素材;

25、1.2 vr素材库

26、该素材库的元素用于制作元宇宙中的基础元素vr视频;

27、(1)数字头像

28、用于元宇宙中用户身份的头像,具备唯一性;

29、(2)虚拟化身、数字分身(avatar)、数字孪生人

30、角色素材分为三种类型,将根据故事脚本进行创建,具有性格特征的角色将根据性格编码匹配相应的动作和造型;根据用户职业身份、年代等属性匹配对应的素材外观元素进行展示;

31、虚拟化身:系统内定义的固定虚拟化身人偶模版,不可定制。包含多组情景动作动画设计,不支持自定义;

32、数字分身(avatar):将发型、五官、身材、服装、装饰品进行拆分组装,在系统内进行自由组合,支持用户自由“捏脸”创造的自定义虚拟形象,包含多组情景动作动画设计,可自由组合和定义;

33、数字孪生人:根据用户上传的真实模型进行数字孪生,通过表情捕捉、动作捕捉等技术手段,在元宇宙系统中形成真人比例的数字孪生人;

34、(3)vr物品模型

35、分为虚拟物品、数字自定义物品和数字孪生物品建模。其中虚拟物品不可编辑,为系统自带的一批默认3d物品;数字自定义物品可进行在系统限定范围内自由编辑;数字孪生物品将根据真实物品进行1:1建模孪生还原;

36、(4)vr场景模型

37、分为虚拟场景、数字自定义场景和数字孪生场景建模。其中虚拟场景不可编辑,为系统自带的一批默认3d场景;数字自定义场景可进行在系统限定范围内自由编辑,可将各类物品、角色类元素设计在此类场景中进行保存;数字孪生场景将根据真实场景进行1:1建模孪生还原在元宇宙里,通过创建场景地图可包含多个场景;

38、1.3音频库

39、(1)背景音乐

40、包含各种情景、年代、风格的bgm音频;

41、(2)ai文字转语音时的音色库

42、包含各类风格的语音音色库,通过平台自定义的音色经过授权后也将出现在音色库中,该音色库中的语音音频用于生成视频中角色对话或旁白时使用;

43、(3)音效库

44、包含各种场景、动作下的音效,通常和物品或人物动作进行绑定,也可自定义设定;

45、2.素材上传接口,创建元素对象

46、2.1普通素材

47、(1)上传面部/数字虚拟化身

48、通过pgc或者ugc方式上传的2d角色头像和数字虚拟化身;

49、(2)上传地点/背景虚拟化

50、通过pgc或者ugc方式上传的2d场景图片或视频;

51、(3)上传物品/虚拟化

52、通过pgc或者ugc方式上传的2d物品图片或视频或虚拟物品模型;

53、2.2 vr素材

54、该素材库的元素用于制作元宇宙中的普通素材库vr视频;

55、(1)数字头像

56、用于元宇宙中用户身份的头像,具备唯一性;

57、(2)虚拟化身、数字分身(avatar)、数字孪生人

58、角色素材分为三种类型,将根据故事脚本进行创建,具有性格特征的角色将根据性格编码匹配相应的动作和造型;根据用户职业身份、年代等属性匹配对应的素材外观元素进行展示;

59、虚拟化身:系统内定义的固定虚拟化身人偶模版,不可定制。包含多组情景动作动画设计,不支持自定义;

60、数字分身(avatar):将发型、五官、身材、服装、装饰品进行拆分组装,在系统内进行自由组合,支持用户自由“捏脸”创造的自定义虚拟形象,包含多组情景动作动画设计,可自由组合和定义;

61、数字孪生人:根据用户上传的真实模型进行数字孪生,通过表情捕捉、动作捕捉等技术手段,在元宇宙系统中形成真人比例的数字孪生人;

62、(3)vr物品模型

63、分为虚拟物品、数字自定义物品和数字孪生物品建模。其中虚拟物品不可编辑,为系统自带的一批默认3d物品;数字自定义物品可进行在系统限定范围内自由编辑;数字孪生物品将根据真实物品进行1:1建模孪生还原;

64、(4)vr场景模型

65、分为虚拟场景、数字自定义场景和数字孪生场景建模。其中虚拟场景不可编辑,为系统自带的一批默认3d场景;数字自定义场景可进行在系统限定范围内自由编辑,可将各类物品、角色类元素设计在此类场景中进行保存;数字孪生场景将根据真实场景进行1:1建模孪生还原在元宇宙里,通过创建场景地图可包含多个场景;

66、2.3音频上传

67、(1)由配音师完成人物配音

68、由配音师完成全部故事角色的配音,或由配音师通过录音采样,由ai完成音色库的建立,可供其他用户可选择该音色;

69、(2)由故事原型者完成人物配音

70、由故事提供者作为故事原型角色完成故事角色的全部配音,或由故事提供者通过录音采样,由ai完成音色库的建立,授权后可供其他用户可选择该音色,可搭配配音师的音色结合使用;

71、(3)背景音乐上传

72、(4)音效上传

73、3.故事生成引擎

74、3.1原始故事输入

75、(1)文字语音转换

76、故事输入动作,用户通过在ui输入模块中输入文字或语音的原始故事内容,用户可一次性完成输入,也可中途保存,分段输入,语音文字识别模块支持文字和语音的双向转换;

77、3.2关键元素提取

78、(1)故事时间提取

79、系统根据ai的语义判断,提取其中的故事时间和事件时间元素,其中事件时间元素是组成故事时间轴的重要部分。若原始故事内容中缺失该部分将由引擎触发ai引导询问用户进行补充。ai识别语义功能和语义判断模块将通过大数据不断进行机器学习;

80、(2)故事人物提取

81、系统根据ai的语义判断,提取其中的人物角色元素和人物关系信息,其中人物的身份、职业、年龄、性别识别是从元宇宙素材库中获取对应准确素材的重要变量,人物关系是构成故事主线和故事时间轴的重要部分,若原始故事内容中缺失该部分将由引擎触发ai引导询问用户进行补充。ai识别语义功能和语义判断模块将通过大数据不断进行机器学习;

82、(3) 故事场景提取

83、系统根据ai的语义判断,建立故事分镜,分别提取各分镜下的场景元素。若原始故事内容中缺失该场景的描述将由引擎触发ai引导询问用户进行补充,ai识别语义功能和语义判断模块将通过大数据不断进行机器学习;

84、(4) 故事物品提取

85、系统根据ai的语义判断,提取故事发生过程中产生的物品元素,若该物品具备触发剧情走向的条件,则需要获得详细特征;若该物品为普通物品或场景中常规出现的物品,则通过系统ai自动生成,若经系统判断该物品为关键物品,且原始故事内容中缺失该部分内容的描述,将由引擎触发ai引导询问用户进行补充,ai识别语义识别和判断模块将通过大数据不断进行学习;

86、3.3故事线整理

87、(1)故事结构整理

88、系统根据ai的语义判断,首先确定故事的主要架构,包含人物、时间、地点,其次确定故事的主线,并根据原始故事内容逐一将故事细节填充在故事主线架构中,当故事主线清晰但结构不够完整时,系统首先通过大数据算法提取相近的故事内容进行填充,当用户预览时调整细节部分的故事内容。当故事主线不够清晰关键的人物关系和人物特质不够清晰时,将触发ai引导式询问用户相关问题由用户逐一补充,补充完成后系统重新进入故事生成引擎进行故事结构整理,直到故事主线整理完成;

89、(2)故事时间轴生成

90、系统根据ai语义判断,在生成故事结构的同时,也会生成一条故事发展的时间轴,该时间轴处理时间和事件的关系,当时间轴有逻辑问题时,将触发ai引导式询问用户相关问题由用户逐一修正,修正完成后系统重新进入故事生成引擎进行故事结构和时间轴的整理,直到故事主线和故事时间轴的生成;

91、(3)故事转场拼接

92、系统根据ai语义判断,当故事出现转场时,将建立转场锚点以供后期效果使用,如增加转场音效、补充转场剧情、增加转场字幕、和添加转场镜头效果等;

93、3.4故事线预览/生成视频

94、(1)故事线的预览并生成视频

95、系统在完成故事线的编辑后经过调用元宇宙素材库中的素材进行视频合成,视频合成后将为用户提供预览的功能,当用户制作的是vr视频时,可通过vr设备进行影片效果的预览体验,系统在此过程中将建立详细的视频拆分点,用户可选择拆分点进行精准编辑。当用户完成编辑后系统将再次生成视频;

96、(2)调整原始故事输入

97、当用户的编辑涉及修改原始故事数据时,如修改人物的数量,身份,故事主线,场景时间等关键数据时,故事生成引擎将重新进行故事分析,在重新分析的过程中,涉及与之前故事逻辑冲突的部分将进行覆盖,新故事中缺失的部分也将重新由系统触发ai引导用户进行补充;

98、3.5故事发布

99、当用户确认故事内容后,将根据视频属性发布保存为普通视频或者vr视频,将根据故事属性保存为线性故事或互动故事。其中普通视频将保存为视频流存储在数据库中,vr视频将生成3d文件或视频流存储在服务器或数据库中,以文件形式保存的故事,用户可以下载到vr终端中离线观看;

100、4.故事互动引擎

101、4.1故事关键信息输入

102、(1)关键元素分析

103、首先,系统将从故事生成引擎中输入到故事互动引擎中的关键元素进行识别;

104、(2)关键元素分类提取

105、在完成关键元素识别后,按照“角色”“场景”“事件时间”“事件轴”“故事主线”等分类提取,并在系统内存中进行记录;

106、4.2人物特征分析

107、(1)人工或ai分析

108、通过人工方式进行人物特征分析时,ai将根据大数据匹配符合该人物行为的性格属性,从而得到人物特征结论,最后将该模型编码代入到剧情走向中的变量得到性格模型编码;通过人工方式进行人物特征分析时,系统将调用ai引导用户回答相关问题,从而印证得到人物特征结论,最后将该模型编码代入到剧情走向中的变量得到性格模型编码;

109、(2)关于人物性格模型编码的描述和规则

110、根据ai学习和大数据收集,每个角色最终将生成其唯一的性格模型编码,该编码由一组32位的大小写英文+数字+特殊符号组成,对应在系统的性格模型数据库中,该编码背后其实关联的是一组元数据矩阵信息,包括人物的姓名、简历、性格特征、倾向判断、语言词汇数据库等信息,根据机器学习和大数据积累该编码库将不断补充和发展;系统通过该编码背后的元数据信息,结合故事场景通过大数据计算出该人物在该场景下的行为和动作,是人物带动剧情发展的的原始契机;如:a遇到b类问题,编码元数据中关于遇到b类问题的角色90%的都会做出c类选择,但是又因为元数据中a角色还同时具备d类特质,而具备d类特质的80%的角色会选择使用e方法,所以经过系统判断a最终的选择是去干f类的事情,因为f类事情的属性同时属于e方法和c选择;

111、4.3分支剧情打点

112、(1)在时间轴添加断点以生成关键帧

113、在对故事主线进行分析时,系统将生成分支剧情走向的关键点并在故事主线中生成关键帧,生成关键帧的依据是以人物角色的性格模型编码为变量,代入剧情演算算法中分析该变量成为分支剧情的可能性,当权重大于50%时生成分支剧情关键帧,或在用户进行视频预览时由用户决定在故事主线中添加分支剧情的关键帧,关键帧的建立通常发生在角色之间的对话中,通过对话时的选择触发分支剧情;

114、(2)设置分支剧情选项

115、系统将根据人物性格模型编码,依次在故事主线中的每个关键帧,分别生成分支剧情走向的选项1、选项2直到选项n;用户可在预览阶段对此环节的选项文本进行调整;

116、4.4分支剧情的生成

117、确定关键帧的选项之后,根据人物性格编码为依据,通过ai系统算法补全该关键帧下分支剧情选项对应的剧情故事内容,并在对故事元素绑定元宇宙素材库中的对应元素和音频后生成动画,此过程与上述线性故事中的素材配型方法一致;由此完成其中一个分支剧情的制作;上述步骤将重复进行直到制作完成全部分支剧情的动画;在故事互动引擎工作时,将根据引擎算法进行互动故事脚本的填充,在遇到违背故事算法逻辑或互动逻辑有错或内容信息不全时,将通过引导式的语音方式与用户进行互动交流,直到系统可以完成互动剧情脚本的编写;系统会将补充得到的内容记录在原始故事线里。该过程可随时暂停不必一次性完成;当所有分支剧情在主故事线中进行组装后,系统将分支剧情下各选项对应的视频统一添加在主时间轴中的关键帧中;

118、5.故事叙述层

119、5.1.故事预览

120、(1)调整原始故事文本

121、(2)调整配音

122、(3)调整角色模型外观配型

123、(4)调整物品外观配型

124、(5)用户主动发起或ai自检发起的故事分支走向合理性调整

125、5.2故事播放

126、(1)线性故事播放

127、(2)互动故事播放

128、通过xr终端、移动、pc终端控制选项播放互动剧情段落;或通过语音输入播放互动剧情段落;

129、6.用户层

130、6.1 ui界面

131、包含以故事为单个操作单位的“暂存”、“新增”、“删除”、“编辑”操作不再赘述;

132、(1)故事生成过程反馈

133、当故事分析引擎和故事互动引擎在工作时,系统ui界面将每个操作的内容和完成进度实时展现在用户界面中;

134、(2)故事自动生成过程中的控制

135、在故事生成过程中,用户可以随时暂停进度,并对故事元素、故事主线、故事交互进行编辑;

136、(3)故事配置完成前随时保存

137、系统将每隔3分钟对当前进度进行保存,用户同时可随时手动暂停制作进度并进行保存;

138、(4)互动视频的交互界面

139、 (5)故事主线生成、互动视频补充过程中的语音交互,补全故事内容;

140、6.2.程序api

141、(1)语音文字互译模块

142、(2)交互分支剧情调度通信模块

143、该模块负责处理用户在触发交互行为时,通过算法匹配到最优分支剧情进行播放,并通过api与用户进行基于语音方式的对话通信互动;

144、(3)故事主线逻辑分析与人物关系模块

145、该模块负责在故事互动引擎运行时,处理故事主线逻辑分析与人物性格、关系合理性的分析,当发现异常时将启动ai引导用户进行改善;

146、6.3系统日志

147、(1)视频版本控制

148、由线性视频转换为交互视频的都将保留原先线性视频的版本;系统将在每次编辑前记录每半小时有编辑更新记录的视频版本,该版本控制操作只记录操作数据生成相应操作日志文件并保存在云端,不会生成视频文件;

149、(2)视频自动化生成的历史记录和生成路径记录日志。

150、用户在通过本发明提供的方法及系统实现自动化视频生成时,系统将按照制作线性故事的流程或制作互动故事的流程运行。无论用户选择的是线性故事还是互动故事的流程,系统首先都会要求用户通过语音或文字输入的方式完成原始故事内容的呈现。用户在完成原始内容呈现后将由故事分析引擎对原始故事内容中的关键信息进行提取,关键信息包括故事中的“人物角色信息”、“人物关系”、“故事发生时间信息”、“事件发生的时间信息”、“事件发生的地点信息”等,最后根据原始故事脚本的描述完成故事推进和故事时间轴的建立与故事脚本的填充。在故事分析引擎进行工作对原始故事内容进行分析时,将根据引擎算法设计故事脚本的填充。当遇到违背故事算法逻辑或内容信息不全时,将通过语音方式与用户进行互动交流,直到系统可以完成故事线的编写和互动剧情脚本的编写。

151、线性故事和互动故事的后续运行流程将在系统完成原始主线故事内容的编写后进行区分:

152、当执行制作线性故事流程时,系统将获得的故事素材元素,依次放入元宇宙素材库中进行元素素材的配对。再此过程中,一些关键元素的配对,将通过ui界面与用户进行选型确认;关键元素包括“人物”、“场景背景”、“建筑选型”、“物品选型”等。当所有元素完成选型配对后,将根据故事素材元素拼接成视频,视频拼接完成后将为用户提供预览,当用户对其中元素的配型不满意时可按需进行调整,调整的内容如果涉及原始故事逻辑和人物关系的调整,系统将重新运行故事分析引擎进行故事线的编写,并重复此步骤直到用户确认故事完成。故事中角色的台词默认将由系统提供的角色语音库中的ai语音翻译文字后生成,用户可选择使用人工配音的方式,经过语音样本录制后,由ai完成完整的剧情台词的语音部分。用户在预览视频确定无修改内容后,可选择完成本线性视频的发布。当系统在走完线性故事的整体制作流程之后,可以由用户随时决定是否将该线性故事改编成互动故事。当用户确定改编为互动故事时,系统将以线性故事为基础,经过故事互动引擎分析后,加入分支关键点进行分支剧情的补充和创作。根据线性故事改编的互动故事将生成单独副本或覆盖之前的线性故事。

153、当执行制作互动故事流程时,程序自动将故事分析引擎中获得的关键元素和原始主线故事内容分别输入到故事互动引擎中:在对其中的人物角色进行分析时,系统的人物特征模块将通过ai分析直接得出或由ai通过问题引导用户回答的方式完成对人物特征的判定,该模块最终将输出和得到人物角色的性格模型编码;在对其中的故事主线进行分析时,系统将生成分支剧情走向的关键点并在故事主线中生成关键帧,生成关键帧的依据是以人物角色的性格模型编码为变量,代入剧情演算算法中分析该变量成为分支剧情的可能性,当权重大于50%时生成分支剧情关键帧,或在用户进行视频预览时由用户决定在故事主线中添加分支剧情的关键帧。关键帧的建立通常发生在角色之间的对话中,通过对话时的选择触发分支剧情。

154、系统将根据人物性格模型编码,依次在故事主线中的每个关键帧,分别生成分支剧情走向的选项1、选项2直到选项n。用户可在预览阶段对此环节的选项文本进行调整。确定关键帧的选项之后,根据人物性格编码为依据,通过ai系统算法补全该关键帧下分支剧情选项对应的剧情故事内容,并在对故事元素绑定元宇宙素材库中的对应元素和音频后生成动画,此过程与上述线性故事中的素材配型方法一致。由此完成其中一个分支剧情的制作。上述步骤将重复进行直到制作完成全部分支剧情的动画。在故事互动引擎工作时,将根据引擎算法进行互动故事脚本的填充,在遇到违背故事算法逻辑或互动逻辑有错或内容信息不全时,将通过引导式的语音方式与用户进行互动交流,直到系统可以完成互动剧情脚本的编写。系统会将补充得到的内容记录在原始故事线里。该过程可随时暂停不必一次性完成。当所有分支剧情在主故事线中进行组装后,用户在预览视频确定无修改内容后,可选择完成本互动视频的发布。

- 还没有人留言评论。精彩留言会获得点赞!