一种融合人声特征与人脸特征的智能视频剪辑方法

本发明涉及视频剪辑,具体地说,涉及一种融合人声特征与人脸特征的智能视频剪辑方法。

背景技术:

1、快速发展的智能传感器和多媒体技术让人们可以通过手机、数码相机和摄像机等智能终端设备方便地获取、传播与使用视频数据。一直以来,传统的视频主要在电视、电脑显示器等设备上播放,视频采集和编辑通常使用4:3或者16:9的宽高比,目前主流视频平台(如腾讯视频、爱奇艺、哔哩哔哩,youtube等)的大部分视频资源均采用这种比例。与此同时,手机、平板等智能终端设备和社交网络的兴起与风靡,让越来越多的消费者更加倾向于用手机等移动设备观看视频,而不是电视或电脑显示器。手机等智能设备的显示屏广泛使用9:16,甚至更小的宽高比,使得传统的4:3和16:9宽高比的视频不能很好地在手机上显示。为了拥有更好的用手机观看视频体验,用户通常需要对视频宽高比格式进行转换。除此之外,随着近年来短视频平台,如微视、抖音、快手、美拍、k歌等,以及直播平台,如虎牙、斗鱼、b站等快速崛起,已经吸引了大量的用户,越来越多视频生产者针对手机等设备进行视频生产与编辑。这些短视频平台、直播平台的视频内容较多使用“竖屏”方式,即9:16的宽高比。而常用的数码相机、单反、摄像机等视频采集设备获取的原始视频素材通常是横屏,这些素材往往需要由人工转为竖屏。

2、传统的视频宽高比转化的方法通常使用静态裁剪(即使用一个固定的视角窗口对视频进行裁剪,保留窗口内的视频内容,裁剪掉窗口外的部分)和补充黑边(即固定视频长宽比缩放,并在其他位置补充零值)。由于视频构图、视频内容运动、相机运动等的多样性,固定窗口的静态裁剪方法通常很难获得令人满意的效果。为了提升裁剪后视频观看效果,需要视频编辑者手动地确定每一帧视频中的显著目标或区域,并且跟踪他们在连续帧中的位置,然后进行手工视频裁剪。对于海量视频的裁剪,这种手工逐帧裁剪的方式,需要消耗大量的时间和人力成本,并且该裁剪过程通常比较繁琐,容易出错。而补充黑边的方式在有限的显示区域内引入较多无效值,严重影响视频观看体验。因此,研究视频智能裁剪技术,根据视频内容进行自适应裁剪,可以大规模应用于视频编辑和辅助编辑,具有较高的实用价值。

3、另外,现有方法并不是对所有的场景都有效,对于某些场景,例如对话类节目,脱口秀节目等等多主角人物场景视频,场景画面的展现常常需要音画同步,即画面选择呈现的主体人和视频的声音必须匹配,即谁说话画面就呈现谁,而现有技术方案在视频出现多主角人物画面时,常会出现音画不匹配的问题,当视频中包含2位或2位以上的主体角色在进行对话时,说话人应该是主体,视频剪辑时,说话的声音应该与说话人画面准确的匹配上才是合理的;由于业界现有的方案均只利用了图像信息,当2位或2位以上的对话演员出现在画面中时,算法会将对话演员均判定为主要(显著性)目标,由于业界现有方案并没有有效的利用视频的声音信息,因此在对话过程中无法有效的从画面中的选择正确的讲话人,导致智能剪辑后的竖屏视频后出现音画不匹配的问题。

4、特别是在新闻节目、对话类节目、脱口秀节目类型的视频及多人场景的影视剧集中容易出现音画不匹配问题;现有方案中由于缺乏对声音特征的有效利用,无法正确地从多个人物中选取最佳的目标进行裁剪,从而导致这类型视频剪辑的失败或效果不佳。

技术实现思路

1、本发明的内容是提供一种融合人声特征与人脸特征的智能视频剪辑方法,其能够解决多主角人物视频自动剪辑中的音画不匹配问题。

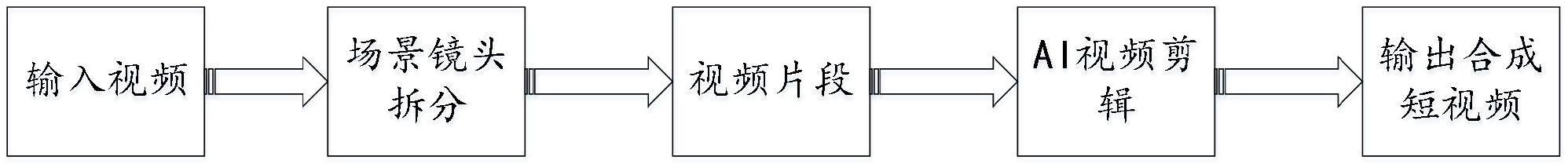

2、根据本发明的一种融合人声特征与人脸特征的智能视频剪辑方法,其包括以下步骤:

3、s1、场景镜头拆分

4、将输入的视频拆分成多个场景镜头片段,然后对每个场景镜头片段进行滑窗切片;

5、s2、智能视频剪辑

6、s2.1、对切片后的片段进行目标检测和显著性检测;

7、s2.2、多主角类视频的判定:判定片段是否为多人物主角类,若是,则采用人声与人脸智能匹配方法;

8、人声与人脸智能匹配方法为:

9、1)使用ffmpeg将片段的音频与图像进行分离;

10、2)对音频数据进行人声提取,提取出视频的主要人声;

11、3)对人声进行不同说话人聚类处理,将相同音色的人声聚为一类,从而统计出说话人的个数,及每个说话人的时间片段;

12、4)对每个说话人分别进行语音性别、年龄识别;

13、5)基于speech2face神经网络系统,通过人声来绘制其面孔;

14、6)对图像数据进行处理:通过yolo-v5对图像进行画面主体人物检测,然后通过retina人脸检测算法提取人脸与人脸识别;人脸进行明星识别与人脸特征分析,得到人脸的性别与年龄预测;

15、7)对视频人脸的进行唇动检测,检测出视频中该片段内该人脸是否在唇动;

16、8)将音频得到的特征与图像的特征进行建模,得到音画匹配模型;

17、s2.3、通过人声与人脸智能匹配方法分析得到视频每段的说话人主体目标框,再通过按比例对视频进行裁剪,再对多片段和原语音进行合成,最后对视频进行平滑即可输出最后的裁剪的短视频结果。

18、作为优选,s2.1中,利用目标检测算法retinanet进行目标检测,利用显著性检测算法对目标画面里的显著物品进行检测;目标检测是应对以人、动物、或常见物品为主体的画面,以分析出画面中的主要的人或物;而显著性检测是辅助目标检测同时对非人非物类得非常见物品的情况进行处理。

19、作为优选,2)中,采用samplernn来完成人声提取。

20、作为优选,3)中,采用说话人分割与聚类技术完成,具体实现如下:

21、a、将整段音频切分为指定长度的音频片段;

22、b、通过声纹提取模块提取所有音频片段的声纹向量信息;

23、c、将所有的音频片段声纹向量信息组合成为一个声纹向量矩阵,声纹向量矩阵的横坐标是时间维度纵坐标是声纹维度;

24、d、用声纹向量矩阵的转置声纹向量矩阵得到音频片段相似度矩阵,每个元素的值代表了该行的索引对应的音频片段声纹信息和该列的索引对应的音频片段声纹信息的相似度;

25、e、通过层次聚类的方法对相似度矩阵中的各个片段进行聚类,聚类后的每个类别单独保存为一个音频,从而实现说话人分割与聚类的工作。

26、作为优选,4)中,通过mfcc对人声提取特征,使用高斯混合模型识别说话人的性别;使用基于gbdt有监督学习分类器的声纹特征分类模型来判断是否为儿童,成年人,老人。

27、作为优选,5)中,speech2face神经网络系统是通过分析视频片段、匹配人声与人脸并找到两者之间的模式和趋势,来学习如何绘制人的样貌;speech2face可描绘出人脸中除了眼睛以外的部位。

28、作为优选,7)中,唇动检测方法为:

29、通过6)得到的人脸图像,先通过pipnet完成人脸的关键点检测,然后对前后5帧的人脸嘴巴的关键点进行张合位置对比,如果出现嘴部关键点的大量移动,则认为是出现了唇动。

30、作为优选,8)中,音画匹配模型建模过程如下:

31、a、挑选当前时间段的图像中所有人脸中唇动的人脸;

32、b、使用唇动人脸图像分析出的性别、年龄,与音频当前的分析的性别、年龄相匹配,如果能直接匹配上,则直接将在人脸作为说话人,同时使用该人脸的人像所在区域作为主体;

33、c、如果当前时间段的图像中没有检测到唇动的人脸,便使用通过音频分析得到的人脸与画面中所有的人脸进行人脸的相似度分析,然后将相似度最高的人脸作为说话人,使用该人脸的人像所在区域作为主体。

34、作为优选,步骤c中,人脸的相似度分析如下:

35、i.使用renet50作为基础网络提取人脸特征;

36、ii.将人脸特征使用余弦距离进行相似度度量,当两个向量直接的夹角趋向0时,两个向量越接近,差异就越小,说明人脸越相似。

37、作为优选,s2.2中,判定为否时,采用传统方案进行处理,传统方案以视频和给定裁剪宽高比作为输入,首先利用预处理算法进行黑边检测,然后利用显著性或主体检测等方法进行视频主要内容分析,接着根据预测结果进行视频框生成,最后利用后处理算法使得裁剪结果在时序上更加平滑,并保留裁剪视频和裁剪框位置。

38、本发明提出一种结合视频声音特征与图像特征信息的多维度融合的ai视频剪辑方案,通过神经网络系统提取人声音频、人脸图像,结合人声特征、面部特征、嘴唇特征等信息,通过生成模型与特征组合分析的方案,实现视频编辑中人像与声音自动匹配功能。从而解决多主角人物视频自动剪辑中的“音画不匹配”的问题。本方案采用多模态生成网络、检测网络相结合的方式,准确地将剪辑中呈现的图像与音频准确的匹配,让智能剪辑后的画面呈现更准确、画面更自然,表达更完整;本发明可应用于人像语音视频的人声匹配,以及提升新闻类、对话类及脱口秀类节目视频的ai剪辑效果。

- 还没有人留言评论。精彩留言会获得点赞!