基于图强化学习的物联网资源无冲突分配方法及系统

本发明涉及物联网资源管理,尤其涉及基于图强化学习的物联网资源无冲突分配方法及系统。

背景技术:

1、在未来网络领域,物联网(iot)技术正在经历快速发展。它们的关键功能不仅限于将设备彼此连接,还在于它们能够将具有先进传感、通信和计算能力的大型智能设备连接起来。物联网由多个智能无线传感器设备(wsd)组成,其连接到接入点(ap),旨在互连来自不同环境的大量终端设备,并实现各种新颖应用,如自动驾驶、智能医疗保健、智能工厂和智能城市。

2、未来的无线网络面临着一个重大挑战:由于频谱无线电稀缺和无线iot网络中的网络服务管理负担,它们可能无法支持原始数据的十倍增加。当设备密集部署时,可能会发生严重的网络资源冲突,从而显著降低网络吞吐量和用户的服务质量(qos)。因此,物联网在可预见的未来要跟上快速增长的步伐是一项挑战。为了解决这个问题,人工智能(ai)和机器学习(ml)网络服务管理技术的研究已经出现,以提高网络服务管理性能,并在物联网中使命执行期间实现网络资源冲突和网络吞吐量之间的平衡。

3、物联网环境状态总是随时间变化的,导致无线物联网网络的剧烈波动。这些波动导致网络资源冲突缓解的困难。为了解决这个障碍,提出了有效的加权聚合干扰方案来协调时变无线物联网网络的剧烈波动。但现实中,物联网网络的覆盖区域会变得非常小,以满足物联网设备数量的要求,造成该区域严重的网络资源冲突。使用定向天线阵列来减轻严重的传播损耗也会引起激烈的网络资源冲突。h.wei等人提出了基于考虑mm波段中的路径损耗和方向性增益方案的小区间干扰协调(icic)来解决该问题。为了避免由小小区和宏小区层之间的增加的基站密度引起的小区间干扰,h.ji等人提供了一种网络资源冲突缓解方案[9]。此外,物联网基础设施中的设备多样化和异构性增加了相邻信道干扰(aci)和外部干扰(ei),导致容易引起网络资源冲突。

4、网络服务管理也是消除网络资源冲突、达到最小化网络资源冲突程度的潜在方法。基于匈牙利方案的高效网络服务管理提出了联合功率分配策略和在严格的资源可用性约束下优化信道分配,以解决分布在区域上的辐射源的aci和ei的影响。然而,这导致了网络资源的浪费现象,特别是考虑到设备的爆炸式增长。联合传输协作多点(jt-comp)方案被提出来解决由于有限的网络资源而导致的严重干扰问题,有限的网络资源由位于小区边缘的大量用户使用。重叠区域网络资源冲突会导致无线物联网网络系统或设备出现失真、噪声、误码等现象,影响网络质量和网络传输精度。最近,已经提出了许多方案来缓解iot中重叠区域中的网络资源冲突。利用网络拓扑技术有效缓解网络资源冲突。根据无线通信网络中的网络拓扑结构和信道干扰的相关性,l.wu等人提出了一种通过增加无线网络节点的免疫力来解决网络资源冲突问题的信道干扰方案。x.pang等人提出了一种新的有效的网络资源冲突缓解方案,通过利用部署在基站(bs)附近的智能反射表面(irs)来解决这种重叠干扰挑战。然而,大多数干扰协调方案需要信道状态信息(csi)。为了解决这个问题,j.li等人提出了一种新的网络资源冲突缓解方案,该方案采用从引起ici的信号中去除额外符号的算法,然后使用干扰再生算法来避免二次干扰。

技术实现思路

1、本发明提供一种基于图强化学习的物联网资源无冲突分配方法及系统,解决的技术问题在于:物联网超密集部署场景下大规模wsd同时在线通信的重叠区域网络资源存在冲突。

2、为解决以上技术问题,本发明提供基于图强化学习的物联网资源无冲突分配方法,包括步骤:

3、s1、创建超密集部署的物联网的超图网络模型;

4、s2、对所述超图网络模型中的重叠网络资源冲突进行建模,得到超图网络服务管理模型;

5、s3、将所述超图网络服务管理模型建模为一个联合超图和马尔可夫决策过程的决策模型;

6、s4、基于图卷积网络双决斗深度q网络对所述决策模型进行求解。

7、进一步地,所述步骤s1具体包括步骤:

8、s11、对超密集部署的物联网进行建模,得到基础网络模型,所述基础网络模型包括nap个ap、nwsd个wsd和一个负责所有基带信号处理和网络业务管理的cu池,ap指接入点,wsd指智能无线传感器设备;所有wsd的数据在cu池处可用,并且cu池通过前传链路将每个wsd的数据分发到ap的子集;ap之间交换的信道状态信息被实时地发送到cu池;发射机和接收机之间的信道衰落遵循准静态瑞利衰落模型;

9、s12、使用初始超图g=(x,d)来建模wsd之间的关系,x表示顶点集,d表示超边集,x和d之间的关系由关联矩阵hi表示,矩阵hi的行表示顶点,列表示超边,元素取如下:

10、

11、其中,(xi,dj)=1表示第i个顶点xi在第j条超边dj的范围内,反之则(xi,dj)=0表示第i个顶点xi不在第j条超边dj的范围内;

12、s13、删除子超边来简化初始超图获得简化超图模型,若一个超边包含另一个超边,被包含的另一个超边则为子超边,hs是所述简化超图模型的关联矩阵;

13、s14、去除所述简化超图模型中的非重叠信息,获得最终的超图网络模型,ho是所述超图网络模型的关联矩阵。

14、进一步地,所述步骤s2具体包括步骤:

15、s21、将ho中为1的元素替换为相应的ap与wsd之间的通信网络资源以构建网络冲突矩阵h;

16、s22、计算网络冲突矩阵h中资源κ的网络资源冲突度:

17、

18、其中,表示网络冲突矩阵h的第n行,表示网络冲突矩阵h的第m列,分别表示网络冲突矩阵h的总行数和总列数,表示中资源κ的网络资源冲突程度,表示中资源κ的网络资源冲突程度;

19、s23、构建超图网络服务管理模型为:

20、

21、s.t.(c1):

22、(c2):

23、γi表示网络冲突矩阵h中wsd i在时间t的传输速率,表示资源集合,为最小容量速率要求;约束c1表示物联网的总网络资源冲突度必须为零,约束c2通过设置最小网络容量来确保网络冲突矩阵h中每个wsd满足传输速率要求。

24、进一步地,γi由下式计算:

25、

26、其中b是信道带宽,是wsd i处的信号与干扰加噪声比;

27、由下式计算:

28、

29、其中,p表示发射功率,gj,i表示发射机j和接收机i之间的信道系数,gk,i表示发射机k和接收机i之间的信道系数,表示加性高斯白噪声的方差。

30、进一步地,所述步骤s3具体包括步骤:

31、s31、定义在时间t的状态st为:

32、

33、

34、

35、其中,是网络资源的数量,nwsd是wsd的个数,是第n个wsd的传输速率,是第n个wsd的最低速率要求集,是第nres个网络资源的网络资源冲突度;

36、定义在时间t处执行动作at之后,返回的奖励rt为:

37、

38、定义强化学习长期累积折扣奖励为:

39、

40、其中λ∈[0,1]是奖励折扣因子;

41、s32、将超图网络服务管理模型的目标函数修改为:

42、

43、其中,π表示策略,eπ[·]表示遵循策略π的期望值;

44、s33、定义状态st=s和at=a的行动价值函数qπ(s,a)为:

45、

46、定义状态st=s的状态价值函数vπ(s)为:

47、

48、最优策略π*是在给定任何状态下都能最大化vπ(s)的策略,最优策略π*的行动价值函数值表示为相应的最优行动是

49、进一步地,所述步骤s4具体包括步骤:

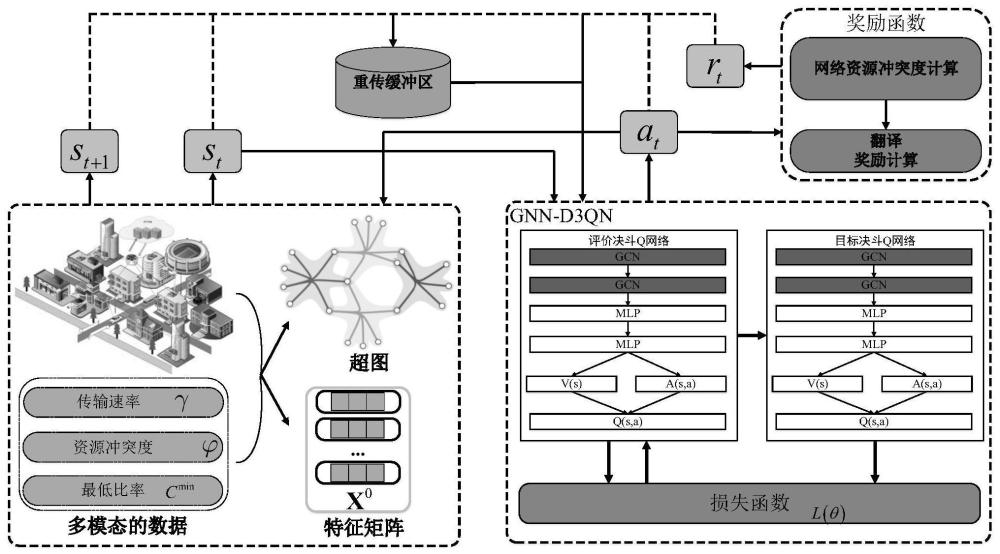

50、s41、训练图卷积网络双决斗深度q网络;所述图卷积网络双决斗深度q网络包括架构相同、网络参数不同的评价决斗q网络和目标决斗q网络,所述评价决斗q网络或所述目标决斗q网络设有两层图卷积网络gcn,gcn通过聚合邻域中的其他节点的特征来学习超图节点在下一状态中的嵌入,gcn被定义为:

51、

52、

53、其中,是超图g的邻接矩阵,是单位矩阵,nnode表示节点个数;是顶点度矩阵;w是gcn权重;wh是超边权重矩阵;de是超边度矩阵,σ()是激活函数,xk表示第k层的特征矩阵,xk+1表示第k+1层的特征矩阵,a1表示没有归一化的矩阵;

54、所述评价决斗q网络定义为:

55、

56、θ,α,β是评价决斗q网络的参数,表示执行动作的个数,qπ(s,a;θ,α,β)表示评价决斗q网络的输出,vπ(s;θ,β)表示评价决斗q网络中的价值网络的输出,aπ(s,a;θ,α)表示(s,a;θ,α)下的动作网络的输出,aπ(s,a′;θ,α)表示在(s,a′;θ,α)下的动作,a′表示下一动作;

57、s42、采用训练完成的图卷积网络双决斗深度q网络对所述决策模型进行求解,得到当前物联网状态对应的策略。

58、进一步地,所述图卷积网络双决斗深度q网络的损失函数为:

59、

60、其中rt是奖励,η是学习速率,表示目标决斗q网络在参数下的最大值,为目标决斗q网络的参数,qπ(st,at;θ,α,β)表示评价决斗q网络在参数(st,at;θ,α,β)下的值,θ,α,β为评价决斗q网络的参数。

61、进一步地,在所述步骤s41中,训练所述图卷积网络双决斗深度q网络具体包括步骤:

62、初始化gcn参数θ、随机获得初始动作a0和初始状态s0;

63、使用一个贪婪的策略来选择是探索还是利用;

64、根据执行的当前动作at反馈下一个环境状态st+1,并将该经验信息{st,at,rt,st+1}存储到重放存储器d中;

65、从经验重放缓冲器d,对元组的随机小批量进行采样;

66、使用采样样本训练评估决斗q网络的参数θ,并将评估决斗q网络参数θ每l次分配给目标决斗q网络的参数

67、本发明还提供一种基于图强化学习的物联网资源无冲突分配系统,其应用上述的基于图强化学习的物联网资源无冲突分配方法,其关键在于:包括超图网络模型创建单元、超图网络服务管理模型创建单元、决策模型创建单元和决策求解单元;

68、所述超图网络模型创建单元用于创建超密集部署的物联网的超图网络模型;

69、所述超图网络服务管理模型创建单元用于对所述超图网络模型中的重叠网络资源冲突进行建模,得到超图网络服务管理模型;

70、所述决策模型创建单元用于将所述超图网络服务管理模型建模为一个联合超图和马尔可夫决策过程的决策模型;

71、所述决策求解单元用于基于图卷积网络双决斗深度q网络对所述决策模型进行求解。

72、本发明提供的基于图强化学习的物联网资源无冲突分配方法及系统,针对网络服务管理中网络资源冲突的重叠区域,提出了一种新的超图网络服务管理模型。由于超图网络服务管理模型是一个np难问题,难以求解,提出了一种间接的解决方案,将超图网络服务管理问题建模为一个联合超图和马尔可夫决策过程的决策模型。然而,深度q网络(dqn)方法不可避免地存在高估值的问题,为了解决网络资源冲突问题,提出了一种基于图卷积网络双决斗深度q网络(gcn-d3qn)的网络服务管理算法。仿真结果表明,本发明在物联网场景下能够实现较高的性能。

- 还没有人留言评论。精彩留言会获得点赞!