一种基于双流重参数化的多视图视频合成方法

本发明涉及视频编码和质量增强,具体涉及一种基于双流重参数化的多视图视频合成方法。

背景技术:

1、随着视频技术的迅速发展,视频内容正朝着高清和三维视频的方向演进。三维视频(3dv)由于能够提供沉浸式的立体视觉体验,逐渐在虚拟现实(vr)、增强现实(ar)以及六自由度(6dof)视频系统等新兴应用中得到广泛关注。作为三维视频的典型形式,多视图视频通过多个摄像机从不同角度捕捉同一场景,使用户能够实现自由视角选择和场景漫游等交互体验。然而,多视图视频相比传统单视图视频数据量显著增加,导致存储和传输面临巨大挑战。为了解决这一问题,国际电信联盟(itu-t)和国际标准化组织(iso/iec)共同推出了3d高效视频编码(3d-hevc)标准,旨在有效压缩多视图视频数据。3d-hevc是二维视频编码标准hevc的扩展,专门设计用于对多视图加深度(mvd)格式的视频进行高效编码。mvd格式包括多个视角的纹理图、对应的深度图以及摄像机参数,利用深度图像渲染(dibr)技术,解码端可以从已有视图中生成虚拟视图。

2、虚拟视图合成技术依赖于深度图的准确性和渲染算法的精度,但在实际应用中,dibr技术面临许多挑战。首先,在多视图视频编码后,深度图像由于压缩损耗和传输噪声,通常会出现质量下降,导致渲染出的虚拟视图存在深度信息不准确的情况。其次,在虚拟视图的三维映射过程中,由于深度信息的误差、像素插值舍入误差以及物体遮挡问题,合成视图往往会出现伪影、裂缝和孔洞。这些视觉瑕疵集中出现在前景和背景交界处,严重影响了合成视图的整体质量,降低了用户的视觉体验。此外,当前的dibr技术对复杂的局部纹理细节处理不足,难以在多尺度信息之间实现平衡,尤其在高动态范围和复杂场景中,效果仍不理想。

3、为了解决上述问题,研究者们尝试通过改进深度图的编码、解码技术以及引入后处理算法来增强虚拟视图的质量。然而本技术的发明人经过研究发现,这些传统方法在处理复杂场景或大规模多视角数据时往往效果有限,无法全面应对虚拟视图合成过程中产生的各种失真问题。因此,近年来,基于深度学习的先进技术逐渐被引入到dibr虚拟视图合成领域,而如何通过深度神经网络自动提取和学习视图合成中的全局和局部信息,以显著提升合成视图的视觉质量就显得十分必要了。

技术实现思路

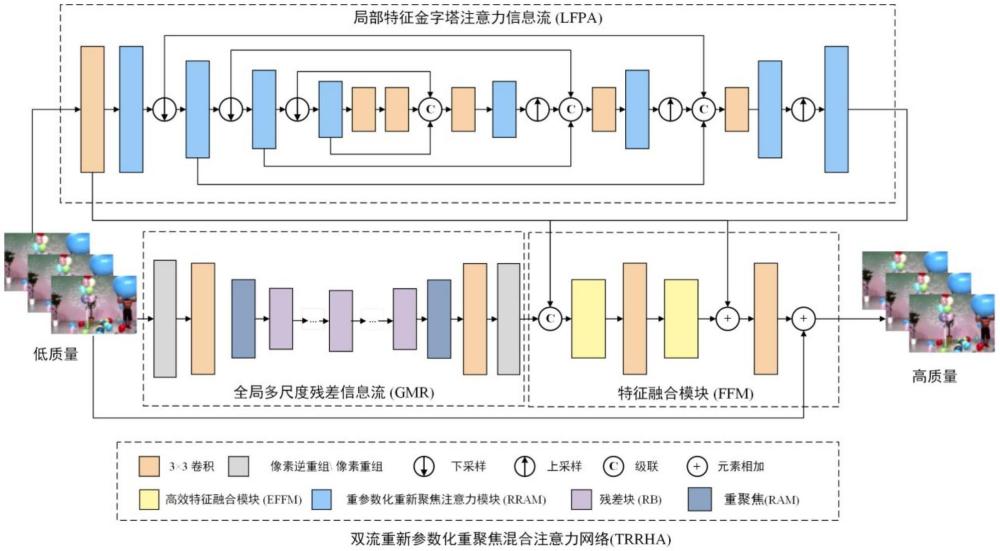

1、针对现有多视图视频合成中往往会出现伪影、裂缝和孔洞的技术问题,本发明提供一种基于双流重参数化的多视图视频合成方法,该方法基于双流重参数化再聚焦混合注意力网络,网络通过全局多尺度残差信息流和局部特征金字塔注意力信息流相结合,能够在不同尺度上自适应提取全局上下文信息和局部纹理细节,有效解决视图合成中的伪影、裂缝及孔洞问题,显著提升图像视觉质量。

2、为了解决上述技术问题,本发明采用了如下的技术方案:

3、一种基于双流重参数化的多视图视频合成方法,包括以下步骤:

4、s1、双流重参数化再聚焦混合注意力网络模型搭建:

5、s11、双流重参数化再聚焦混合注意力网络包括特征提取和特征重构两个阶段,特征提取阶段采用局部特征金字塔注意力信息流和全局多尺度残差信息流双流结构,所述局部特征金字塔注意力信息流用于提取图像的局部纹理信息,所述全局多尺度残差信息流用于获取合成视图中的全局上下文信息,确保对细节和整体信息的全面把握;特征重构阶段则是将来自所述局部特征金字塔注意力信息流和全局多尺度残差信息流的全局和局部信息进行整合输出;

6、s12、局部特征金字塔注意力信息流结构包括提取低级特征的卷积层及四层对称的编码器-解码器结构,编码器结构包括位于低级特征提取卷积层后面的四个重参数化再聚焦注意力模块和三个下采样,一个重参数化再聚焦注意力模块和一个下采样依次交替排列,最后一个重参数化再聚焦注意力模块后面设置了两个卷积层,解码器结构包括位于两个卷积层后面的三个卷积层、四个重参数化再聚焦注意力模块和三个上采样,一个卷积层、一个重参数化再聚焦注意力模块和一个上采样依次交替排列,最后一个重参数化再聚焦注意力模块作为输出;

7、全局多尺度残差信息流结构包括顺序设置的像素逆重组层、第一卷积层、第一再聚焦注意力模块、十二个串联的残差块、第二再聚焦注意力模块、第二卷积层和像素重组层;

8、特征重构阶段采用特征融合模块进行整合,特征融合模块包括两个高效特征融合模块和两个卷积层,每个高效特征融合模块后面设置一个卷积层依次交替排列;

9、s2、双流重参数化再聚焦混合注意力网络模型训练与参数优化:

10、s21、数据集建立与预处理:使用包含11个不同分辨率的视频序列作为实验数据集,其中9个序列用于模型训练,2个序列用于测试,每个视频序列包含100帧图像,并由低质量的合成视图图像与其对应的参考图像配对构成数据,为确保模型的泛化能力,训练和测试数据集中的场景是完全不重叠的,保证了训练数据集中不会出现测试数据中的场景;

11、所有视频序列根据公开测试条件下的不同质量水平进行联合编码,具体包括30-39、35-42、40-45和45-48共四个失真等级;

12、最后对训练数据集中训练图像数据样本使用mixup数据混洗进行数据增强,并使用随机水平翻转和随机旋转来提升模型的鲁棒性和泛化能力;

13、s22、将64×64大小的图像对作为双流重参数化再聚焦混合注意力网络的输入,通过网络前向计算生成特征向量;

14、s23、模型训练配置:模型训练中优化器选用adamw,并设置参数一阶动量估计的指数衰减率β1为0.9,二阶动量估计的指数衰减率β2为0.999,权重衰减值为0.02;整个训练过程中,学习率从3e-4开始,并使用余弦退火算法使学习率逐步下降到1e-6;损失函数采用pseloss,以有效捕捉合成图像的特征差异,定义如下:

15、

16、其中,lssim表示ssim损失,lpsnr表示psnr损失,ih表示预测的合成视图,ig表示相应的未失真参考视图,ξ和λ均为常数,ε用作惩罚系数以帮助网络有效处理异常值,δ表示拉普拉斯算子,δ(ih)表示ih的拉普拉斯算子,δ(ig)表示ig的拉普拉斯算子;

17、s24、采用自适应矩估计梯度下降算法优化目标函数lpse,运用误差反向传播更新双流重参数化再聚焦混合注意力网络模型参数,得到最优网络模型参数;

18、s3、基于双流重参数化的多视图视频合成:

19、用学习得到的最优网络模型参数,搭建基于双流重参数化再聚焦混合注意力的多视图视频合成网络,将低质量的合成视图图像输入该网络中进行多视图视频合成,输出高质量合成视图图像,进行质量提升。

20、进一步,所述步骤s12中,每个重参数化再聚焦注意力模块从输入端开始包括依次设置的多尺度卷积和再聚焦注意力模块,再聚焦注意力模块的输出与输入端的输入进行级联,级联的输出连接有3×3卷积层。

21、进一步,所述多尺度卷积从输入端开始包括并列设置的3×3卷积层和3×3膨胀卷积层,分别设于3×3卷积层和3×3膨胀卷积层后面的prelu激活函数,设于激活函数后与输入端输入进行相加的元素相加,对两个元素相加结果进行处理的级联,以及设于级联后面的1×1卷积层。

22、进一步,所述再聚焦注意力模块包括顺序设置的多尺度特征提取模块和特征再聚焦模块,所述多尺度特征提取模块从输入端开始并列设置有两个分支,第一个分支包括依次设置的最大池化层、1×1卷积层、prelu激活函数和1×1卷积层,第二个分支包括依次设置的平均池化层、1×1卷积层、prelu激活函数和1×1卷积层,两个分支的最后一个1×1卷积层输出相加后作为特征再聚焦模块的输入;所述特征再聚焦模块从输入端开始包括依次设置的sigmoid激活函数和点乘,点乘的输出并列连接取最大值和求平均值,取最大值和求平均值的输出连接级联,级联的输出依次连接基本卷积、sigmoid激活函数和点乘。

23、进一步,所述基本卷积从输入端开始包括依次设置的重参数卷积、归一化和prelu激活函数。

24、进一步,所述步骤s12中,每个残差块从输入端开始包括依次设置的3×3卷积层、prelu激活函数、3×3卷积层,以及将两个3×3卷积层的结果进行相加的元素相加。

25、进一步,所述步骤s12中,每个高效特征融合模块由全局平均池化分支和重参数化卷积分支两个分支组成,全局平均池化分支专注于跨通道信息的建模,并将空间位置信息整合到通道注意力图中,以增强特征表达能力;重参数化卷积分支则专注于提供多尺度的空间结构信息,并将这些信息与全局平均池化分支的特征结合。

26、进一步,所述步骤s22中的网络前向计算包括卷积操作、批量归一化和非线性激励。

27、进一步,所述卷积操作运算中,任意一个卷积核所对应的输出特征图zi采用下式进行计算:

28、

29、其中,f表示非线性激励函数,bi表示第i个卷积核所对应的偏置项,r表示输入通道索引号,k表示输入通道数,wir表示第i个卷积核的第r通道权值矩阵,是卷积损作,xr表示第r个输入通道图像。

30、进一步,所述非线性激励采用整流线性单元prelu作为特征图zi的非线性激励函数,用于将特征图zi归一化后的每个值进行非线性转化,所述整流线性单元prelu定义如下:

31、

32、其中,x是一个输入值,σ()是非线性激活函数。

33、与现有技术相比,本发明提供的基于双流重参数化的多视图视频合成方法具有以下优点:(1)通过搭建双流重参数化再聚焦混合注意力网络(trrha)模型,trrha模型通过局部特征金字塔注意力信息流(lfpa)和全局多尺度残差信息流(gmr)双流结构提取局部纹理细节和全局上下文信息,有效提升合成图像的细节和结构一致性,实现局部与全局信息高效融合,有效解决视图合成中的伪影、裂缝及孔洞问题;(2)利用高效特征融合模块(effm)融合全局平均池化和多尺度重参数化卷积(rc)分支,确保重建图像在空间结构和细节方面的精确性,生成自然且高质量的合成视图,增强图像视觉质量;(3)采用像素逆重组(pixelunshuffle)与像素重组(pixelshuffle)操作,扩展感受野的同时减少信息损失,降低计算复杂度,提升模型在高分辨率任务中的效率;(4)通过数据增强如mixup数据混洗和随机旋转以及严格分离训练和测试数据,模型在未见过的场景中依然表现优异,具有出色的泛化能力;(5)模型能够在不同级别失真情况下保持高性能,特别是在低质量输入的情况下,依然生成高质量输出,展现出强大的抗失真能力,减少dibr技术在3d视频、虚拟现实等应用中的视觉瑕疵。

- 还没有人留言评论。精彩留言会获得点赞!