一种基于多摄像头融合的多目标追踪方法

1.本发明结合深度学习与计算机视觉算法,具体公开了一种基于多摄像头融合的多目标追踪方法。

背景技术:

2.多目标跟踪因其学术和商业潜力,在计算机视觉中逐渐备受关注。尽管如今已经有多种多样的方法来处理这个课题,但诸如目标重叠、外观剧变等问题仍然是它所面临的重大挑战。如何更有效的解决目标重叠等问题,对于多目标跟踪技术的应用具有巨大意义,为了解决所有这些问题,在过去的几十年里,人们提出了广泛的解决方案

3.多目标跟踪(multiple object tracking or multiple target tracking,mot or mtt)主要任务是在给定视频中同时对多个感兴趣的目标进行定位,并且维持他们的id、记录他们的轨迹。这些目标可以是路上的行人,路上的车辆,操场上的运动员,或者多组动物(鸟,蝙蝠,蚂蚁,鱼,细胞等等),甚至是一个单目标中的不同部分。多目标跟踪除了具有单目标尺度变化,出平面旋转和光照变化等挑战,多目标跟踪还需要处理更复杂的关键问题包括:1)频繁遮挡;2)轨道初始化和终止;3)相似的外观;4)多目标间的相互影响。

4.而工业界关注度最高的多目标跟踪算法,非sort、deepsort莫属了。这两类算法通过检匹配过程和卡尔曼预测加更新的方式,实现多目标追踪,但面对遮挡、id switch问题仍无法很好的解决。

5.本方法,结合深度学习与计算机视觉的方法,构建以一个基于deepsort之上,融合多摄像头的多目标跟踪算法,能够很好解决遮挡、id交换问题。

技术实现要素:

6.本发明的目的在于提出一种基于多摄像头融合的多目标追踪方法,其采用如下方案:

7.一种基于多摄像头融合的多目标追踪方法,包括如下步骤:

8.s1、通过检测器检测得到目标检测框;

9.s2、卡尔曼滤波预测目标下一时刻位置;

10.s3、级联匹配和iou匹配对预测框与检测框进行关联;

11.s4、使用匈牙利算法将预测后的轨迹和当前时刻检测框进行匹配;

12.s5、通过辅助视角对匹配进行矫正;

13.s6、卡尔曼滤波更新;

14.进一步,上述步骤s1中,通过yolov4目标检测,获取待检测目标的检测框;

15.进一步,上述步骤s2中,通过卡尔曼滤波技术,对检测到的目标进行下一时刻的预测;

16.进一步,上述步骤s3中,级联匹配和iou匹配对预测框与检测框进行关联

17.进一步,具体关联过程为:

18.s31、通过马氏距离对检测框以及预测框进行距离度量;

19.s32、通过余弦距离对表观特征进行度量

20.s33、通过iou交并比对重合程度进行度量

21.进一步,上述步骤s4中,使用匈牙利算法寻找检测框与预测框的最优匹配。

22.进一步,上述步骤s5中,通过辅助视角对匹配进行矫正

23.进一步,矫正的过程为:

24.s51、通过相机标定算法,将会匹配框进行真实场景还原

25.s52、通过辅助摄像头,对匹配结果进行校正

26.s53、修改并还原矫正结果

27.进一步,上述步骤s6中,卡尔曼滤波更新。

28.本发明具有如下优点:

29.本发明方法通过深度神经网络与计算机视觉的方法,通过检测加预测的形式对多目标进行实时的追踪,同时针对多目标跟踪存在的遮挡等固有问题,提出使用多摄像头辅助的方案,通过辅助视角,对主摄像头遮挡位置进行位置矫正,改善因遮挡带来的id交换等问题,提高多目标检测的准确度。

附图说明

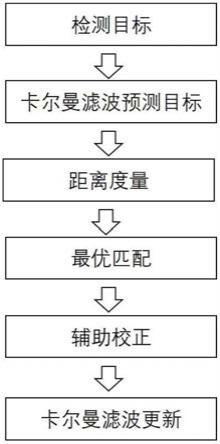

30.图1为本发明中一种基于多摄像头融合的多目标追踪方法的流程框图;

31.具体实施方法

32.下面结合附图1以及具体实施方式对本发明作进一步详细说明:

33.结合图1所示,一种基于多摄像头融合的多目标追踪方法,包括如下步骤:

34.s1、通过检测器检测得到目标检测框

35.为了鲁棒的实现多目标追踪,本方法采用了检测加预测的方式,用过更快速更有效的yolov4实现从视频帧中完成追踪人物的检测工作。

36.s2、卡尔曼滤波预测目标下一时刻位置

37.检测算法单纯实现人物从图片中的位置检测,无法实现帧与帧之间同一个人的关联,通过卡尔曼滤波对当前时刻的人物进行下一时刻的预测,为匹配关联提供参考依据,具体计算过程如下:

38.基于之前的轨迹来预测当前时刻的轨迹

39.x

′

=fx

40.其中χ为轨迹在t

‑

1时刻的状态向量,f为状态转移矩阵,该公式预测t时刻的状态向量x

′

:

[0041][0042]

其中,cx,cy分别表示目标中心点的横坐标和纵坐标位置,r表示长宽比,h表示高,其余四个为对应的导数

[0043]

s3、级联匹配和iou匹配对预测框与检测框进行关联;

[0044]

s31、通过马氏距离对检测框以及预测框进行距离度量:

[0045]

[0046]

d

j

代表第j个检测框的位置,y

i

代表第i个追踪器对目标的预测位置,s

i

代表两者之间的协方差矩阵,通过计算框与框之间的距离,对检测框与预测框进行关联,当然除了距离上的把控,仍需要看框内的表观特征的关联度

[0047]

s32、通过余弦距离对表观特征进行度量

[0048][0049]

通过神经网络对检测框以及预测框提取128维度的特征向量,通过12正则化到一个单位球的超球面上,通过求两个特征向量间的余弦距离,r

j

对应第j个检测的特征向量,对应跟踪的特征向量,其中跟踪的特征向量是一个集合,保留过去成功跟踪的k次的特征向量

[0050]

s33、通过iou交并比对重合程度进行度量

[0051][0052]

其中area(a)∩area(b)为检测框与预测框相交的面积,rea(a)∩area(b)为其相并的面积。

[0053]

s4、使用匈牙利算法寻找检测框与预测框的最优匹配;

[0054]

匈牙利算法主要用于解决分配问题,找到一个最优分配,使得完成所有任务的代价最小,又叫km算法。其具体的计算过程如下:

[0055]

1.对于矩阵的每一行,减去其中最小的元素

[0056]

2.对于矩阵的每一列,减去其中最小的元素

[0057]

3.用最少的水平线或垂直线覆盖矩阵中所有的0

[0058]

4.如果线的数量等于n,则找到了最优分配,算法结束,否则进入步骤55.找到没有被任何线覆盖的最小元素,每个没被线覆盖的行减去这个元素,每个被线覆盖的列加上这个元素,返回步骤3。

[0059]

s5、通过辅助视角对匹配进行矫正;

[0060]

为了更好的改善因遮挡带来的id交换问题,通过多个辅助摄像头对遮挡区域进行辅助校正。

[0061]

s51、通过相机标定算法,将会匹配框进行真实场景还原

[0062]

通过摄像头视角与真实场景选择关键点,计算摄像视角到真实场景的转换矩阵,计算过程如下:

[0063]

1.在真实场景选定四个标记点分别为p1、p2、p3、p4,其在摄像头中的对用点分别为q1、q2、q3、q4,对元素进行组合,计算p,q

[0064]

p=[p1,p2,p3]

t

q=[q1,q2,q3]

t

[0065]

2.计算权重

[0066]

v=(p

‑1)

t

*p

4t

[0067]

r=(q

‑1)

t

*q

4t

[0068]

[0069][0070]

3.计算转换矩阵

[0071]

t

′

=(q

t

*w*p)

t

[0072]

s52、通过辅助摄像头,对匹配结果进行校正

[0073]

通过标定矩阵,将摄像头中位置进行还原到真实场景,将主摄像头匹配结果与辅助摄像头匹配结果进行校正。

[0074]

s53、修改并还原矫正结果

[0075]

依据辅助摄像头,对于匹配结果进行重新的修订。

[0076]

s6、卡尔曼滤波更新

[0077]

1.测量矩阵h将轨迹的均值向量x

′

映射到检测空间

[0078][0079]

2.将协方差矩阵p

′

映射到检测空间,加上噪声矩阵

[0080]

s=hp

′

h

t

+r

[0081]

3.计算卡尔曼增益k,用于估计误差的重要程度

[0082]

k=p

′

h

t

s

‑1[0083]

4.计算更新后的均值向量x和协方差矩阵p

[0084]

x=x

′

+k

y

[0085]

p=(1

‑

kh)p

′

[0086]

当然,以上说明仅仅为本发明的较好实施例,本发明并不限于列举上述实施例,应当说明的是,任何熟悉本领域的技术人员在本说明书的教导下,所做出的所有等同替代、明显变形形式,均落在本说明书的实质范围之内,理应受到本发明的保护。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1