一种基于半监督对比学习的场景文本编辑方法和装置

本发明属于计算机视觉图像处理领域,具体涉及一种基于半监督对比学习的场景文本编辑方法和装置。

背景技术:

1、文字在社会交流中扮演着重要的角色,不仅是文化表达和思想交流的工具,也是信息传递的媒介。在视觉设计领域,文字作为重要的视觉元素,对整体设计起着关键作用。设计师们需要巧妙运用字体风格、颜色和排列方式,使得文字与其他设计元素和谐统一,达到视觉上的平衡和美感。

2、近年来,随着人工智能技术的迅猛发展和社交媒体的不断进步,场景文本编辑技术逐渐崭露头角。该技术的目标是在保持文本的样式(字体、颜色、纹理等)和背景纹理不变的前提下,对图片中的文本内容进行修改。这一技术已广泛应用于场景文本图像修复、文本图像合成、隐私信息保护、增强现实翻译以及广告图像编辑等领域,极大地降低了对专业软件和人工操作的需求,因此对于场景文本编辑技术的研究具有极其重要的实际意义。

3、目前存在两种主要的场景文本编辑方法,根据修改的字符数量不同分为字符级别和单词级别。字符级别的编辑方法由于无法使用不同长度的文本内容对原文本进行修改,因而在实际应用中受到一定的限制。相对而言,单词级别的编辑方法可以使用长度任意的文本来对原文本进行修改。因此,大多数现有的场景文本编辑方法更倾向于基于单词级别的操作。现有的很多基于单词级别的场景文本编辑方法都将文本编辑任务看作是图像到图像的转换任务,在图像上修改所有的像素,导致文本样式视觉效果不佳。而基于笔划级别的修改(stroke-level modification,slm)方法,可以过滤掉复杂的背景区域,明确地引导模型对文本区域进行编辑,使得在文本编辑时更加专注于模仿文本的样式,从而增强了模型的样式模仿能力。生成对抗网络(generative adversarial network,gan)作为主流的一种生成模型,在风格迁移、图像转换、姿势估计等方面受到越来越多的关注或发展,因此现有大多数基于单词级别的场景文本编辑方法也是基于gan。

4、针对当前大多数场景文本编辑方法存在的问题,由于背景纹理的复杂性,使得在保持背景纹理不变的前提下有效地模仿文本样式成为一项挑战。这些方法普遍存在字体样式模仿能力不足、颜色失真以及生成图像模糊等问题。此外,这些方法通常只能使用带标签的合成图像进行训练。由于合成图像和真实场景文本图像之间存在领域差异,这种训练方式导致使用无标签的真实场景文本图像进行推理时效果不佳。对于现有的半监督混合学习的方法,该方法同时利用合成图像和真实场景文本图像进行训练。在这种方法中,通过确保编辑前后文本内容不发生变化,并将编辑前的真实场景文本图像作为真实标签引入训练。然而,这种方式可能会导致网络退化为恒等映射网络,即生成的目标文本图像和输入的样式文本图像一致。因此,如何提升模型的样式模仿能力同时使用无标签的真实场景文本图像进行有效训练而不退化为恒等网络是一个十分重要的问题。

技术实现思路

1、本发明的要克服现有技术存在的上述问题,提出一种半监督对比学习的场景文本编辑方法和装置,以提升模型对文本样式的模仿能力,同时能有效地使用无标签的真实场景文本图像进行训练从而避免恒等网络的问题。

2、本发明的一种基于半监督对比学习的场景文本编辑方法,构建了一个新颖的文本编辑模块,采用半监督混合学习方式,并结合对比学习策略,以提升模型对样式的模仿能力生成高质量的文本图像。同时,该方法有效地利用不同的文本内容对真实场景文本图像进行编辑从而解决了网络可能退化成恒等网络的问题。

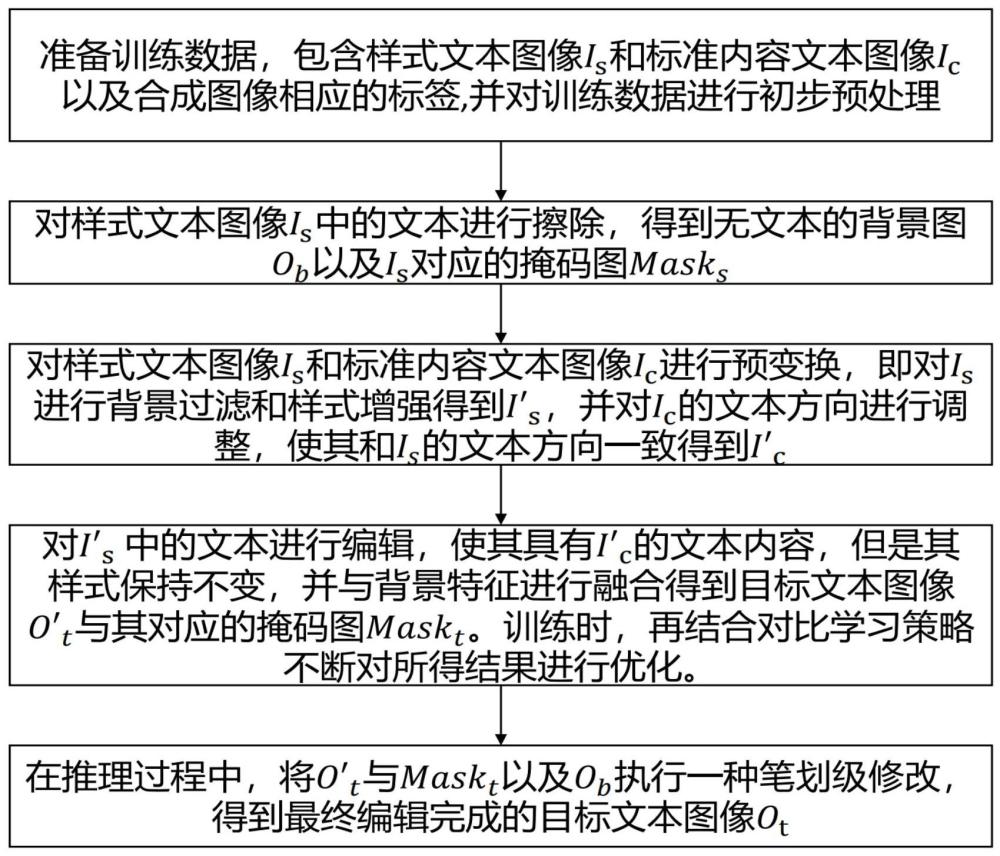

3、本发明的第一个方面涉及一种半监督对比学习的场景文本编辑方法,其具体步骤如下:

4、(1)准备训练数据,包含样式文本图像is和标准内容文本图像ic以及合成图像相应的标签,并对训练数据进行初步预处理,具体过程如下:

5、(1-1)准备150k张带标签的合成图像和34625张无标签的真实场景文本图像作为样式文本图像is。

6、(1-2)从单词库中抽取不同于真实场景文本图像的单词作为内容文本,在输入模型前,使用统一的字体(arial.ttf)和pil(python image library)来生成标准内容文本图像ic。

7、(1-3)在输入模型前,将所有的训练数据调整成256x64的大小。

8、(1-4)批次大小设置为16,包含14张带标签的合成图像和2张无标签的真实场景文本图像,以此方式进行半监督混合学习,能够同时使用合成图像和真实场景文本图像进行训练。

9、(2)对样式文本图像is中的文本进行擦除,得到无文本的背景图ob以及is对应的掩码图masks,具体过程如下:

10、(2-1)将样式文本图像is输入编码器ε进行编码,再通过psp模块进行处理,最后通过解码器进行解码,得到初步的无文本背景图和样式文本图像对应的掩码图masks。其中编码器是由三个下采样层和四个残差块组成,解码器则由三个上采样层组成。在psp模块中,首先并联了四个不同尺寸的金字塔池化层(1×1、2×2、3×3、6×6),对输入特征进行自适应平均池化,获得每个不同尺度的特征图。随后,对这些特征图分别进行自适应平均池化,并插值调整大小以匹配原始特征图的尺寸。最终,将所有金字塔池化层的输出与原始特征图进行串联输入解码器。

11、(2-2)将步骤(2-1)得到的和掩码图masks以及样式文本图像is进行笔划级别的修改(stroke-level modification,slm),得到最终的无文本背景图ob。

12、(2-3)将步骤(2-2)得到的ob使用对抗损失以及l2损失进行优化,而步骤(2-1)得到的掩码图masks使用dice损失进行优化。判别器使用与patchgan相同的结构,由5个卷积层组成,用来判别ob和真实的目标背景是否相似。

13、(3)对样式文本图像is和标准内容文本图像ic进行预变换,即对is进行背景过滤和样式增强得到i′s,并对ic的文本方向进行调整,使其和is的文本方向一致得到i′c,具体过程如下:

14、(3-1)将步骤(2-1)得到的掩码图masks和样式文本图像is逐元素相乘,得到背景过滤后的样式文本图像以去除复杂背景对编辑过程的干扰。

15、(3-2)在训练过程中,将步骤(3-1)中得到的采用[-15°,15°]的随机旋转以及0.5的概率进行随机翻转等操作以进行样式增强,得到样式增强后的样式文本图像i′s。

16、(3-3)将样式文本图像is输入空间位置变换(space position module,spt)模块获取文本轮廓的控制点信息,然后结合薄板样条插值算法(thin plate splines,tps)对标准内容文本图像ic的文本方向进行调整,使其与is具有相同的文本方向,得到转换文本方向后的内容文本图像i′c。其中spt模块包括一个编码器和两个全连接层,编码器同样是由三个下采样和四个残差块组成,然后将编码得到的特征图分别通过两个全连接层得到文本轮廓的控制点信息。

17、(4)对i′s中的文本进行编辑,使其具有i′c的文本内容,但是其样式(字体、颜色、纹理等)保持不变,并与背景特征进行融合得到初步的目标文本图像与其对应的掩码图maskt。训练时,再结合对比学习策略不断对所得结果进行优化,具体过程如下:

18、(4-1)将步骤(3-2)的得到的i′s和步骤(3-3)得到的i′c分别输入风格编码器εs和内容编码器εc中进行编码,得到对应的风格特征图fs和内容特征图fc。其中风格编码器和内容编码器均由三个下采样和四个残差块组成,风格编码器使用普通的卷积,而在内容编码器的下采样层引入的可变形卷积,并且都使用实例归一化(instance normalization,in)作为归一化的方式。

19、(4-2)将步骤(4-1)得到的fs和fc通过多层感知机(multi-layer perception,mlp)分别转换为对应的风格向量vs和内容向量vc,其中vc仅用于后续的对比学习过程。

20、(4-3)将步骤(4-1)得到的fs和fc在通道级别上进行连接输入解码器中,并将步骤(4-2)得到的vs通过自适应实例归一化(adaptive instance normalization,adain)层输入解码器中,同时解码器的每一个上采样层连接着内容编码器对应分辨率的下采样层。将这些特征与背景特征进行融合,通过解码器解码后得到初步的目标文本图像与其对应的掩码图maskt。其中,解码器具有4个卷积块,每个卷积块包含两个卷积层,在前三个卷积块的第二层引入了可变形卷积,其余卷积层均使用普通卷积,并在每一个普通卷积层后面都使用了adain层。

21、(4-4)训练过程中,将步骤(4-3)得到的与maskt逐元素相乘,得到背景过滤后的目标文本图像

22、(4-5)将步骤(4-4)得到分别输入到ε′s和ε′c中,其中ε′s和ε′c分别与风格编码器εs和内容编码器εc具有相同的结构,它们在前向传播的过程中分别与εs以及εc共享参数。通过ε′s和ε′c后可以得到相应的风格特征图和内容特征图,再采用步骤(4-2)相同的方式将特征图转化成相应的风格特征向量v′s和内容特征向量v′c,其中v′s和v′c分别用于计算风格对比损失和内容对比损失。

23、(4-6)使用对比学习策略,将与对应的作为其风格正样本,而批次中其余样式文本图像作为其负样本,使得其与正样本在特征空间中的距离更近而与负样本在特征空间的距离更远。其中风格对比损失使用infonce损失。

24、(4-7)与步骤(4-6)过程类似,将与对应的作为其内容正样本,而批次中其余内容文本图像作为其负样本,使得生成文本的内容正确性。其中内容对比损失也使用infonce损失。

25、(4-8)在带标签的合成图像上,对于步骤(4-3)得到的初步目标文本图像使用对抗损失、l2损失、vgg损失以及识别损失进行优化,判别器也使用patchgan相同的结构,包括5个卷积层,用来判别和真实的目标文本图像是否相似。其中vgg损失包含感知损失和风格损失。而在无标签的真实场景文本图像上,仅使用识别损失进行优化。掩码图maskt使用dice损失进行优化。对于步骤(4-4)所得在合成图像和真实场景文本图像上,都使用风格对比损失和内容对比损失进行优化,进而对和maskt进行间接优化。

26、(5)在推理过程中,将步骤(4)得到的初步的目标文本图像与其对应的掩码图maskt以及步骤(2)得到的无文本背景图像ob执行一种笔划级别的修改,得到最终编辑完成的目标文本图像ot,具体过程如下:

27、(5-1)将步骤(4-3)得到的初步编辑的目标文本图像与其对应的掩码图maskt以及步骤(2-2)得到的无文本背景图像ob执行笔划级别的修改(stroke-levelmodification,slm),得到最终编辑完成的目标文本图像ot,该步骤是对的进一步细化,使得最终编辑完成的目标文本图像的背景直接源自样式文本图像,以最大程度保证背景的不变性。

28、本发明的第二个方面涉及一种基于半监督对比学习的场景文本编辑装置,包括存储器和一个或多个处理器,所述存储器中存储有可执行代码,所述一个或多个处理器执行所述可执行代码时,用于实现本发明的一种基于半监督对比学习的场景文本编辑方法。

29、本发明的第三个方面涉及一种计算机可读存储介质,其上存储有程序,该程序被处理器执行时,实现本发明的一种基于半监督对比学习的场景文本编辑方法。

30、本发明提出了一种新颖的文本编辑模块,训练时采用半监督混合学习的方式,并引入对比学习,训练出一种基于半监督对比学习的场景文本编辑网络模型,使得在生成高质量文本图像的同时能有效地利用不同的文本内容对真实场景文本图像进行编辑从而解决了网络可能退化成恒等网络的问题。与现有技术相比,本发明的积极效果:

31、1.本发明提出了一种新颖的文本编辑模块,通过在文本编辑模块中使用可变形卷积以及自适应实例归一化,以提高模型对文本样式的模仿能力,生成高质量的文本图像,可以解决现有场景文本编辑方法中对文本的字体样式模仿能力不佳、颜色失真以及生成的文本与背景融合不自然的问题。

32、2.本发明提出了一种新的半监督混合式学习方法,并引入对比学习策略,在训练中同时采用内容对比损失和风格对比损失对初步的编辑结果进行优化,可以同时使用带标签的合成图像和无标签的真实场景文本图像进行混合训练。并且与现有的半监督场景文本编辑方法不同,本发明允许使用与真实场景文本图像不同的文本内容对其进行编辑,使用了对比学习来确保编辑后的目标文本图像内容和风格的准确性,因此本发明在使用无标签的真实场景文本图像进行训练的同时又能完全解决现有半监督方法中网络可能退化为恒等网络的问题。

33、3.本发明提出的方法是首次尝试使用对比学习在场景文本编辑任务上的工作,推动了场景文本编辑工作的进步。

34、4.本发明评估了提出的新模型,实验结果表明该方法在合成图像上以及真实场景文本图像上定性和定量的结果都优于现有基于gan的场景文本编辑方法。

- 还没有人留言评论。精彩留言会获得点赞!