一种用于商超防损的自助收银台多物体重识别方法

本发明涉及目标重识别,具体涉及一种用于商超防损的自助收银台多物体重识别方法。

背景技术:

1、目标重识别也称为再识别,是图像检索的一个子问题。主要用于在多个视频摄像头中对同一行人进行准确地识别和匹配,即给定一张待识别的图片,目标重识别re-id技术从图库集中将该行人在不同时间、不同角度或遮挡等情况下所拍摄的图片找到,实现准确识别。目标重识别算法广泛地应用于智能交通监测、行人监控、智能安保等领域。当前的目标重识别问题的主要关注对象在于行人和车辆,是智慧城市建设不可或缺的一部分。

2、一般而言,当前目标重识别模型分为特征提取和特征匹配两个步骤。目标的特征提取指的是通过深度学习获取目标的外观、运动或语义特征向量,特征匹配指的是通过目标间特征向量的相似性来判断两个目标是否为同一个。现如今的特征表示方法有四大类:全局特征表示学习、局部特征表示学习、注意力机制和辅助特征表示学习。全局特征表示学习是包括目标的外观特征、姿势特征、纹理特征等信息的一个全局特征表示向量。局部特征表示学习是将全局特征以某种方式分解,选取最具代表性的一个局部特征作为目标重识别的特征向量。现有的很多模型还将局部特征和全局特征结合起来,能够达到更好的目标重识别精度。注意力机制是通过计算每个行人图像中不同区域的重要性权重,并根据这些权重对行人图像进行加权,以获得更准确行人特征表示。辅助表示学习包括语义特征提取和生成对抗网络两部分。语义特征提取通过利用目标的语义信息来学习更具有判别性的特征表示,例如人体的姿态、服装颜色、性别,车辆形状等方面的信息。这些信息可以帮助区分不同的目标并提高重识别的准确性,为了提取这些语义特征,研究者们通常会从图像中提取不同的语义信息进行特征融合,从而得到更加丰富和具有判别性的特征表示。生成对抗网络(generative adversarial networks,gan)的应用是re-d探索过程中的一个重要方向,主要用于扩充训练集的样本数量并缩小数据集内不同摄像头之间的域差异。

3、现有的目标重识别应用场景大多关注行人和车辆,此类数据集往往很少会存在两个完全相同的行人或车辆目标,故目标的视觉信息能够成为目标重识别的有效线索。在自助收银台数据集中,不仅存在很多外观、形状、体积完全一样的目标,且此类目标常会同时出现,有相近的位置信息,目标的视觉信息并不可靠,这造成了自助收银台数据集中目标重识别的难点。

4、因此,现需要一种用于商超防损的自助收银台多物体重识别方法。

技术实现思路

1、本发明的主要目的在于提供一种用于商超防损的自助收银台多物体重识别方法,以解决现有技术中缺乏有效地方法避免商超自助收银台货物防损的问题。

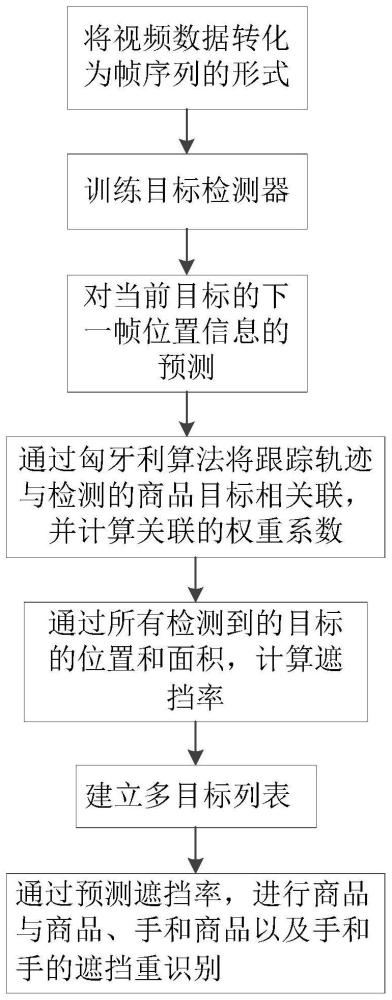

2、为实现上述目的,本发明提供了一种用于商超防损的自助收银台多物体重识别方法,具体包括如下步骤:

3、s1,将视频数据转化为帧序列的形式。

4、s2,通过神经网络模型,训练出能够识别帧序列中左右手和各种商品的目标检测器。

5、s3,通过目标检测器所定位到的目标信息,在卡尔曼滤波算法的基础上实现对当前目标的下一帧位置信息的预测。

6、s4,通过目标检测器获得目标的外观特征输出,在归一化的基础上,通过余弦距离计算外观特征输出之间的相似度。

7、s5,通过匈牙利算法将跟踪轨迹与检测的商品目标相关联,并计算关联的权重系数。

8、s6,通过所有检测到的目标的位置和面积,计算遮挡率。

9、s7,根据步骤s6的遮挡率建立多目标列表,包括:所有检测框、所有轨迹和所有帧。

10、s8,通过预测遮挡率,进行商品与商品、手和商品以及手和手的遮挡重识别。

11、进一步地,步骤s2具体包括如下步骤:

12、s2.1,目标检测器包括:input模块,backbone模块、neck模块和head模块,通过mosaic数据增强方法进行数据增强,将增强后的数据集按5:2:3的比例分别划分为训练集、测试集合验证集。

13、s2.2,数据从input模块进入backbone模块,backbone模块包括:focus模块、conv卷积块、bottleneckcsp模块和ssp模块。

14、s2.3,数据经backbone模块进入neck模块,neck模块中的fpn结构通过自顶向下进行上采样,使得底层特征图包含更强的目标强语义信息;pan结构自底向上进行下采样,使顶层特征包含强目标位置信息,两个特征最后进行融合,使不同尺寸的特征图都包含强目标语义信息和强目标特征信息。

15、s2.4,数据经neck模块进入head模块,通过conv2d卷积操作,最终得到三个特征图。

16、进一步地,步骤s3具体包括如下步骤:

17、s3.1,计算当前帧检测目标和现有轨迹的马氏距离d(1)(i,j);

18、

19、yi代表第i条轨迹的目标预测位置,dj为第j个目标检测边界框,表示卡尔曼滤波算法得到的当前帧协方差矩阵;通过卡尔曼滤波算法预测的上一帧的目标位置信息和当前帧检测器的目标信息构造卡方分布,通过设置阈值t(1)来判断上一帧的目标i和下一帧的目标j是否相似。

20、s3.2,利用公式对阈值t(1)进行判断;

21、

22、t(1)为卡方分布对应着95%置信度阈值,d(1)(i,j)若小于阈值,取值为1,表示关联成功;否则取值为0,表示关联失败。

23、进一步地,步骤s4具体为:

24、

25、

26、

27、其中,rk表示一段帧数内成功关联目标的特征向量集合,l表示保留的特征向量集合中的数量,为归一化后第j个检测目标与第i个轨迹特征向量之间的余弦距离,d(2)(i,j)为第j个检测目标与第i个轨迹中n个特征向量的余弦距离最小值,rk表示第i条轨迹中第k个外观特征向量,表示第i条轨迹中外观特征向量的集合,是判定结果。

28、进一步地,步骤s5中关联的权重系数为:

29、ci,j=(1-λ)d(2)(i,j)+λ(i,j) (6);

30、λ表示不同关联度量的比例系数,ci,j表示一次关联的权重系数,关联的权重系数值越小表示第i个跟踪轨迹与第j个检测目标越相似,最后通过卡尔曼滤波更新算法完成目标轨迹的更新。

31、进一步地,步骤s6中检测目标a的遮挡率为:

32、

33、cmax(boxa)代表检测目标a的遮挡率,boxa和boxb分别代表检测目标a和b在检测照片坐标空间上的坐标位置,s()代表检测目标所占面积。

34、进一步地,步骤s7建立的多目标列表为:

35、

36、其中,o表示当前帧中目标的编号;x,y表示目标框的中心位置坐标;γ表示目标检测框的长宽比值;h表示边界框的高度;分别表示对应参数的速度;p表示遮挡与被遮挡的上下位置关系,取值为1表示遮挡其他目标,取值为0表示被其他商品遮挡;c表示遮挡率,通过步骤s6获得;b表示与特殊背景信息的关系,取值为1,表示目标在关注范围内,取值为0,表示目标正常消失;u表示目标与轨迹是否完成关联,关联成功,则u取值为上一帧的目标关联序号;u取值为0,表示结束关联,目标合理的消失,u取值为-1,表示目标未出现在特殊的场景标注点,存在遮挡、变形因素造成的无法关联;z表示的时当前的帧数;rt表示目标的外观特征集合。

37、进一步地,步骤s8具体包括如下步骤:

38、s8.1,利用如下公式进行遮挡率预测:

39、

40、

41、其中,为目标a在t帧的遮挡率,取值范围为[0,1];boxa为商品目标a的矩形检测框,为t帧中a的矩形检测框在图像坐标系的位置信息,(x,y)为a的中心坐标γ为a的长宽比,h为a的高,为根据a的坐标信息得到面积大小,m为与a相邻的目标总数;为目标a在t-1帧的遮挡率,t-1为帧序号,为目标a在t帧的遮挡率预测值,通过δc1的正负,判断目标遮挡变化方向是否一致;利用式(10)对动态目标的轨迹进行遮挡率预测,若预测值大于80%,即当前帧无法检测到该目标,保留其轨迹信息继承到下一帧;若预测值小于80%,则对该轨迹进行适配目标预测。

42、s8.2,利用式(11)进行阈值筛选:

43、

44、其中,为当前帧t中目标targett中相邻目标遮挡率,t(1)为预测阈值。

45、本发明具有如下有益效果:

46、本发明提供的方法可以应用于自助收银台数据集中,可以对很多外观、形状、体积完全一样的目标进行重识别,进而实现商超防货损的效果。

- 还没有人留言评论。精彩留言会获得点赞!